Позиционирование

Прежде чем приступить к ознакомлению с видеокартой, необходимо определиться с портретом потенциального покупателя. На кого рассчитана GTX 1080 в первую очередь? Прежде всего на тех, кто не готов идти на компромисс и хочет насладиться в полной мере играми на WQXGA или UHD мониторах. Также, новинка придётся в пору продвинутым стримерам, энтузиастам, оверклокерам и прочему контингенту, который все же отличается от массового потребителя и точно знает, чего хочет. При этом, с учетом текущей цены в 55-60 тысяч рублей круг будущих владельцев сужается еще больше и говорить о «народной карте» здесь попросту не уместно. Увы и ах, несмотря на столь впечатляющую производительность и приятный бонус в качестве разгона в нашей стране позволить себе такой графический ускоритель смогут лишь немногие. В дополнении ко всему, ASUS предлагает во многом улучшенную версию GTX 1080, которая способна предоставить более высокий уровень производительности прямо из коробки.

Тестовый стенд

Для изучения эффективности работы технологии 3-Way SLI я использовал подходящий для этих целей тестовый стенд, так как процессоры Haswell-E вкупе с системными платами на чипсете X99 Express могут похвастать поддержкой сразу 40 линий PCI Express 3.0. Конкретно материнка ASUS X99-PRO поддерживает массивы из трех видеокарт AMD/NVIDIA по схеме х16+х16+х8. Такой пропускной способности достаточно, чтобы не считать плату узким местом в системе. Итак, тестовый стенд:

- Процессор: Intel Core i7-5960X @4,5 ГГц

- Процессорный кулер: ENERMAX LIQTECH 240

- Материнская плата: ASUS X99-PRO

- Видеокарта: 3x NVIDIA GeForce GTX 980

- Накопитель: OCZ Vertex 3, 360 Гбайт

- Блок питания:

- Периферия: , ROCCAT ARVO, ROCCAT SAVU

- Операционная система: Windows 8.1 х64

Игровые тесты

Перейдем к игровым приложениям и остановимся на методике тестирования. Измерение FPS проводилось с помощью утилиты FRAPS. Все игры были протестированы в трех наиболее актуальных разрешениях: 1920х1080, 2560х1440 и 3840х2160. Вручную отключены следующие параметры:

VSync (вертикальная синхронизация)

Все остальные настройки, включая сглаживание, были установлены на максимально возможные.

Если проанализировать результаты, то становится понятно, что благодаря заводскому разгону ASUS GTX 1080 ROG Strix предлагает заметную прибавку в производительности в сравнении с моделью оснащенной референсной системой охлаждения. Кроме того, альтернативная СО способствует повышению усреднённого показателя частоты GPU в режиме Boost. Учитывая результаты можно смело утверждать, что данная модель отлично подойдет для игры на мониторах с разрешением 2560×1440, здесь можно не церемониться и выкручивать все настройки в играх на максимально возможные. Что же до 4К, то при отключении такого параметра как сглаживание вы также сможете спокойно поиграть и насладиться отличной графикой.

Температуры и внутреннее устройство

- Вес ~ 1000 грамм

- Длина — 30 см

- Шум — 40 дБА.

Система охлаждения — 3 кулера, работающих по стандарту IP-5X (защита от попадания мелких частиц и пыли в видеокарту).

Температура — в майнинге при 100% работе кулеров карта держит GPU на отметке в 67 градусов.

Внутренняя система охлаждения

Внутренняя система охлаждения состоит из толстых теплотрубок, диаметром 6 миллиметров, соединённых с двумя массивными радиаторами, которые, в свою очередь, выводят тепло не только от GPU, но также частично соприкасаются с микросхемами памяти и силовыми элементами. Так же стоит отметить, что вентилятор крепится на радиатор, а не на кожух, как это было ранее.

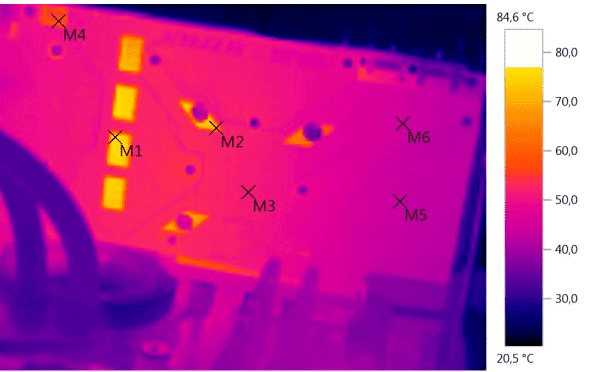

Измерение карты тепловизором

Термоснимки показывают следующий результат:

| Точка измерения | Градусы Цельсия) |

| M1 | 79.9 |

| M2 | 70.7 |

| M3 | 51 |

| M4 | 57.9 |

| M5 | 43.7 |

| M6 | 44.4 |

M1 — температура GPU

M1 — так же можем наблюдать температуру области VRM задней панели.

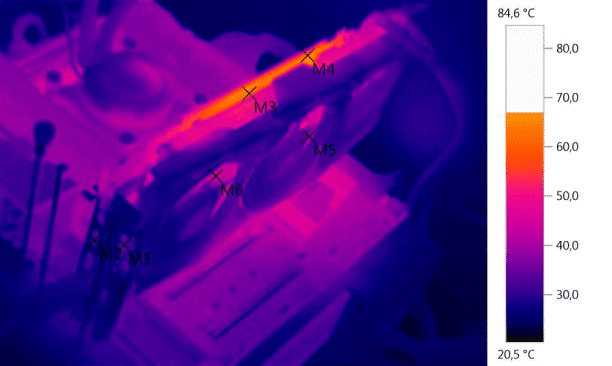

| Точка измерения | Градусы Цельсия) |

| M1 | 32.9 |

| M2 | 30.6 |

| M3 | 62.2 |

| M4 | 64.5 |

| M5 | 37.7 |

| M5 | 42.9 |

Температура GPU не превышает 65 градусов по Цельсию, при 100% работе кулеров. Это очень хороший результат.

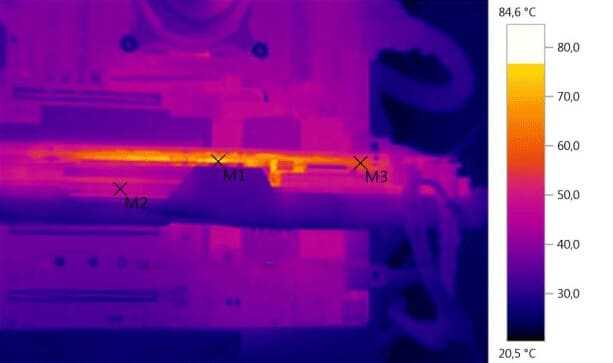

| Точка измерения | Градусы Цельсия) |

| M1 | 75.6 |

| M2 | 46.8 |

| M3 | 57.4 |

M1 — область VRM — силовая часть, по которой проходит электропитание видеокарты.

Сравнение Asus 1080 Rog Strix с аналоговой линейкой видеокарт

Рассмотрим разницу между другими брендами, производящими 1080, а также разницу между 8 гигабайтной версией и 11 гигабайтной версией 1080 и 1080TI.

Разница между брендами очень большая.

Asus 1080 Rog Strix сделан из высококачественных материалов. Система охлаждения также выдает отличные показатели.

Карта имеет 3 кулера, огромный массивный радиатор и множество термотрубок, что позволяет ей держать температуру при майнинге на отметке от 62-70 градусов. Даже в душном помещении этот порог не преодолевается.

Например, MSI 1080 Armor в майнинге без дополнительного охлаждения, находясь в квартире, может дойти до 85 градусов. Так же качество сборки MSI Armor будет ниже, чем у Asus Strix. Минусом, возможно, будут выступать крупные габариты видеокарты Asus 1080 Rog Strix, намного превышающие аналогичные карты других производителей.

Так же карта сильно шумит: ферма из 6 таких карт, сопоставима шуму работающего пылесоса.

Asus 1080 Rog Strix – пожалуй одна из лучших карт, семейства представителей 1080.

Разница между 1080 и 1080 TI.

Разница между 1080 и 1080 TI весьма существенная.

На Equihash 1080 будет выдавать ~550-570 Mh/s, когда 1080 TI ~730-770 Mh/s.

Разница в цене примерно 15-20 тысяч рублей (1080 TI дороже).

Многим эта разница может показаться существенной. Но если Вы собираете ферму в квартире, то рано или поздно вы упретесь в потолок потребляемой электроэнергии. Поэтому куда выгоднее поставить несколько карт 1080 TI, чем большее количество 1080, — чем меньше карт, тем меньше они будут выделять тепла и шума. К тому же, у 1080 TI будет больше хэшрейт, так как она мощнее. Вы так же можете произвести даунвольтинг карт и поставить еще несколько 1080 TI, сделав свою ферму мощнее.

Фермы из 1080 это отличный вариант, если Вы не упираетесь «в розетку».

Сравнение Asus 1080 Rog Strix с ASUS GeForce GTX1080 Advanced

Разница между этими картами только в цене. Так как главное отличие – это разгон. Advanced уже за нас разогнан на заводе и из коробки выдает — 1695 MHz Chiptakt, 1835 MHz Boost, когда ROG STRIX — 1607 MHz Chiptakt, 1733 MHz Boost. Поэтому Advanced стоит чаще всего дороже.

Есть ли смысл переплачивать за разгон с завода?

Смысл есть, если Вы не умеете разгонять видеокарту. Также такая карта работает более стабильно в майнинге. Но при этом гонится вручную намного меньше, чем Rog Strix, — оно и логично, ее разогнали за нас на заводе. Раз на раз не приходится, но все же на 5-10 Mh/s Advanced выдает больше.

Позиционирование

Прежде чем приступить к ознакомлению с видеокартой, необходимо определиться с портретом потенциального покупателя. На кого рассчитана GTX 1080 в первую очередь? Прежде всего на тех, кто не готов идти на компромисс и хочет насладиться в полной мере играми на WQXGA или UHD мониторах. Также, новинка придётся в пору продвинутым стримерам, энтузиастам, оверклокерам и прочему контингенту, который все же отличается от массового потребителя и точно знает, чего хочет. При этом, с учетом текущей цены в 55-60 тысяч рублей круг будущих владельцев сужается еще больше и говорить о «народной карте» здесь попросту не уместно. Увы и ах, несмотря на столь впечатляющую производительность и приятный бонус в качестве разгона в нашей стране позволить себе такой графический ускоритель смогут лишь немногие. В дополнении ко всему, ASUS предлагает во многом улучшенную версию GTX 1080, которая способна предоставить более высокий уровень производительности прямо из коробки.

Температура и разгон

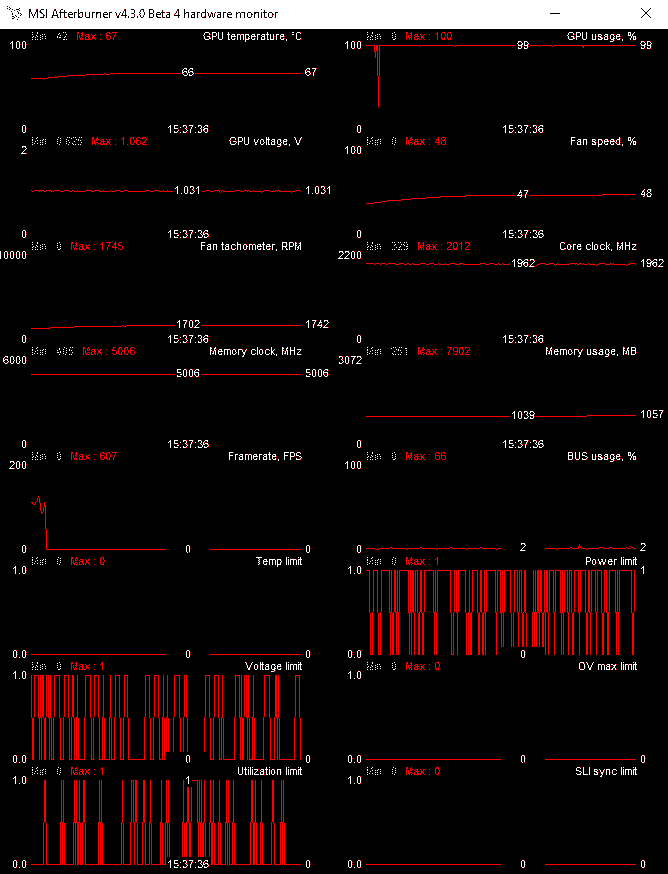

Тестирование происходило в открытом корпусе при комнатной температуре в 25 градусов. В режиме бездействия частота GPU и памяти снижается до 329/405 МГц, что напрямую сказывается на энергоэффективности и улучшает температурные показатели. В режиме покоя температура опустилась до 44°С, а под нагрузкой не превысила 71°С. Что же до уровня шума, то при малых нагрузках видеокарта останавливает вентиляторы и не издаёт ни звука. Под нагрузкой шум также не выходит из комфортной зоны. Кроме того, никаких посторонних шумов наподобие писка дросселей выявлено не было. В общем и целом, благодаря снижению потребляемой мощности и как следствие снижению нагрева, альтернативная система охлаждения отлично справляется с отводом тепла.

Разгон осуществлялся при помощи последней версии утилиты EVGA PrecisionX 16, а также, для закрепления результата использовалось фирменное ПО ASUS GPU Tweak II. Несмотря на применение более продвинутой системы охлаждения и переработанной печатной платы, в обоих случаях не удалось достичь или превысить результаты, которые были получены при разгоне референсной видеокарты. Возможно, не повезло с экземпляром.

- Частоту графического процессора удалось повысить на 30 МГц, что в итоговом варианте составило 1814 МГц. Однако, с учетом GPU Boost искомое значение выросло до 2088 МГц, что гарантирует заметную прибавку в производительности.

- Частота памяти была увеличена на 475 МГц и достигла значения 2740 МГц (10,9 ГГц QDR), получилась хорошая прибавка.

Предлагаю ознакомиться с возросшими показателями Fire Strike Extreme и Fire Strike Ultra:

Актуальность и критика

Поддержка SLI снижается со времен безмятежности графических процессоров Nvidia серии GTX 600, 700, 900. В те годы большинство игр стремились поддерживать SLI, и как Nvidia, так и разработчики заметили толчок к интеграции этой технологии. Со стороны потребителей был высокий интерес, и SLI оказался доступным способом более или менее удвоить графические возможности системы.

Однако с появлением все более мощных одиночных графических процессоров, особенно серий 1000 и 2000, более чем способных удовлетворить требования «ультра» настроек в современных играх. Потребность в установке с двумя графическими процессорами приближается к моральному устареванию для среднего уровня.

Небольшое меньшинство игроков используют SLI, означает, что создание профиля ограничено все меньшим количеством новых игр. Разработчики сосредотачивают свои ресурсы на игровых функциях, исправлениях ошибок и изменениях, которые затрагивают большую часть игроков с одним GPU. Производители не кодируют их игры для поддержки SLI, и не ломаются, для нишевой группы пуристов, стремящихся достичь лучший FPS и разрешение на 5K или выше.

Отсутствие потребителей, покупающих установки с двумя графическими процессорами, означает что разработчики реже обращают внимание на поддержку SLI. Теперь меньше людей покупают машины с SLI

Для игр, которые поддерживают SLI, масштабирование часто не достигает 200%, ожидаемого от двух идентичных графических процессоров. Технология SLI склонна к микропроцессорам (особенно в режиме рендеринга альтернативных кадров) и другим проблемам с производительностью, отсутствующим при рендеринге с одним графическим процессором. Это отталкивает многих потребителей, интересующихся технологией SLI.

Многие новые и старые игры не будут работать с включенным SLI, это означает что его нужно отключить, чтобы играть. Ценовое соображение вновь поднимает голову, и многие не видят логики в двойной трате за столь малую прибыль. Требования к мощности установки SLI учитывают эту тенденцию.

Nvidia постепенно отказывается от поддержки SLI, поскольку она выпускает новые модели, что считается лучшим признаком того, что технология находится в упадке. Из самой последней серии RTX только RTX 2080 и RTX 2080 TI поддерживают NVLink, необходимый для графических процессоров с двумя SLI. Вероятность того, что кто-либо, кроме опытных пользователей, будет использовать эту технологию за высокую цену на эти модели маловероятна.

Чтобы больше повлиять на состояние SLI, DirectX 12 в настоящее время не поддерживает SLI. Все больше разработчиков переходят на новую и универсальную версию популярного API. Вероятно названия с поддержкой SLI резко упадут.

Преданные SLI утверждают иначе. Тысячи долларов были вложены в топовую серию двойных графических процессоров. Эта группа стремится оправдать свои вложения дерзкой и сердечной дозой когнитивного диссонанса.

История

В современной итерации технология SLI принадлежит и спроектирована Nvidia, но это не совсем так. Концепция SLI это детище ныне несуществующего производителя графических процессоров 3Dfx. Который на период расцвета в 1990-х годах был основным в области обработки трехмерной графики и технологии видеокарт, конкурируя с Nvidia и ATI (ныне AMD).

В 1998 году 3Dfx произвела и распространила линейку графических ускорителей, известную как Voodoo2. Это первое устройство, использующее недавно представленный интерфейс 3dfx Scan-Line Interface, или SLI, и включающее три графических процессора на одной карте. Voodoo2 была первой ориентированной на потребителя видеокартой. Во многом задала тон богатому, динамичному аппаратному рынку в настоящее время для игровой индустрии.

Связь между двумя картами Voodoo2 обеспечивалась ленточным кабелем, который позволял картам обмениваться данными и отображать изображение, чередуя рисование горизонтальных линий пикселей. Эта технология позволила использовать разрешение 1024 × 768, что считается значительным скачком по сравнению с конкурентами с одной картой, которые могли управлять только стандартными 800 × 600.

На фоне агрессивного маркетингового продвижения технология SLI обещала удвоить вычислительную мощность ПК. В действительности, технология столкнулась со многими проблемами, в основном связанными с необходимостью жертвовать слотами PCI Express для размещения двух устройств Voodoo2 за счет сетевых карт и тому подобного.

Фактический процесс рендеринга был подвержен неприглядным артефактам отображения, таким как неполные кадры и разрывы. Запретительные затраты на приобретение двух карт (около 300 долларов каждая) оказались препятствием для широкого распространения этой технологии, и это оставалось прерогативой нишевых энтузиастов, жаждущих похвастаться своей игровой системой.

Но судьба 3Dfx быстро пошла на юг из-за грязного слияния с STB Systems, замедления продаж и неспособности идти в ногу с экспоненциально лучшими линейками карт GeForce и Radeon. В конце 2000 года Nvidia приобрела компанию-производителя графических карт, производство и поддержка которой вскоре прекратились.

Nvidia не сразу использовала технологию SLI, и она оставалась бездействующей до 2004 года. Компания повторно запустила его как Scalable Link Interface, ориентированный на использование в слотах PCI-e, а не в ранее использовавшихся слотах PCI.

Технология стала повсеместно распространенной в большинстве современных графических процессоров Nvidia, и большинство стандартных технологий чипсетов для материнских плат, особенно серии Intel X и Z, поддерживают SLI.

Большая часть аппаратной технологии была заменена и обновлена для современных потребностей, но основная концепция использования мощности двух параллельных графических процессоров остается.

Какие монеты можно майнить

Для майнинга криптовалюты на видеокарте Asus 1080 Rog Strix от компании Nvidia больше всего подходит алгори. Ниже приведены примеры монет этого алгоритма, а также монеты других алгоритмов, менее выгодных для добычи на данной видеокарте. Алгоритмы распложены по нисходящей: наверху самый выгодный, внизу самый невыгодный алгоритм. Добываемые монеты

| Алгоритмы | Монеты |

| Equihash | Zclassic, Hush, Zcash, Zencash, BitcoinGold, Komodo, BitcoinZ, Bitcoin Interest, Bitcoin Private, BitcoinZ, Zero |

| TimeTravel10 | Bitcore |

| Lyra2REv2 | Monacoin, Galactrum, Rupee, Straks, Vertcoin, Verge |

| X16R | Ravencoin |

| NeoScrypt | Crowdcoin, Dinero, Feathercoin, GoByte, Halcyon, Innova, Vivo, Trezarcoin, Orbitcoin, Phoenixcoin |

| Ethash | Ethereum, Ethereum Classic, Ellaism, Metaverse, Expanse, Krypton, Ubiq, Soilcoin, Shift, Pirl, Musicoin |

| Xevan | BitSend, Solaris |

Характеристики

| Действующие маркетинговые акции | Скидка при покупке материнской платы GIGABYTE, видеокарты GIGABYTE и процессора Intel |

| Предупреждения | |

| ПРЕДУПРЕЖДЕНИЕ о майнинге | Данные видеокарты часто используются для майнинга криптовалюты, соответственно, подвергаются «разгону» и модификации микропрограмм в ППЗУ. Поэтому напоминаем, что «разгон», как и любое другое вмешательство в нормальную работу устройства, может повлечь снятие с гарантии. |

| ПРЕДУПРЕЖДЕНИЕ | У данной видеокарты отсутствуют аналоговые видеовыходы! Подключение возможно только по цифровым интерфейсам, дешевые переходники не подойдут! Используйте конвертеры, в зависимости от того, что есть в избытке на видеокарте. конвертеры DP/DVI-D/HDMI-VGA |

| Основные характеристики | |

| Производитель | MSI |

| Модель | GTX 1080 GAMING X 8G найти похожую видеокарту |

| Подсветка видеокарты | MSI Custom LED Lighting, RGB подсветка радиаторов |

| Пропускная способность памяти | 320 Гб/сек |

| Серия | GAMING X |

| Тип оборудования | Игровая видеокарта |

| Поддержка API | DirectX 12, OpenGL 4.5 |

| Длина | 275 мм |

| Технологии | Adaptive V-Sync (адаптивная вертикальная синхронизация), DSR (динамическое суперразрешение), NVIDIA G-SYNC (плавный вывод кадров на монитор), NVIDIA GameStream-Ready (возможность трансляции игрового процесса на мобильные устройства), TXAA (временное сглаживание), VXGI (воксельная глобальная иллюминация), NVIDIA PhysX-ready (использование более слабой видеокарты в качестве вспомогательного GPU), VR Ready (поддержка виртуальной реальности), NVIDIA Ansel (создание игровых фотографий профессионального качества), Boost 3.0 (технология автоматического разгона, учитывающая энергопотребление и температуру чипа видеокарты), ShadowWorks (технология точного отображения теней), VXGI (технология отображения точного освещения), 4K (поддержка мониторов ultraHD), GeForce Experience (Утилита для автоматической оптимизации настроек игр, обновления драйверов, записи и трансляции видеоигр на популярные сервисы Twitch и Youtube), NVIDIA SLI Ready (возможность объединения нескольких видеокарт для увеличения производительности) |

| Поддержка ОС | Windows 10, Windows 8.1, Windows 8, Windows 7, Linux |

| Видео | |

| Максимальное разрешение экрана | 7680 x 4320 @60 Гц при подключении к 2-м разъемам DisplayPort |

| Поддержка SLI | Возможно объединение карт при помощи SLI HB |

| Макс. кол-во подключаемых мониторов | 4, с возможностью объединения до 3 дисплеев в 3D Vision Surround |

| Конфигурация видеокарты | |

| GPU | GeForce GTX 1080 |

| Частота GPU | 1847 МГц максимум в режиме GPU Boost, 1708 МГц- базовая (OC mode), до 1822 МГц в режиме GPU Boost, 1683 МГц — базовая (Gaming mode), до 1733 МГц в режиме GPU Boost (Silent mode) |

| Кол-во шейдерных процессоров | 2560 |

| Видеопамять | 8 Гб |

| Тип видеопамяти | GDDR5X |

| Разрядность шины видеопамяти | 256 бит |

| Частота видеопамяти | 2527 МГц (10.108 ГГц QDR) |

| Конфигурация | |

| Техпроцесс | 16 нм |

| Интерфейс, разъемы и выходы | |

| Интерфейс | PCI Express 3.0 16x (совместим с PCI Express 2.x/1.х) с возможностью объединения карт при помощи SLI. |

| Поддержка HDCP | Есть (1080p) |

| Вывод звука видеокарты | NVIDIA HDMI audio |

| Порты | 3 выхода DisplayPort, DVI-D, HDMI 2.0 конвертеры DP/DVI-D/HDMI-VGA порты |

| Прочие характеристики | |

| Поддержка PhysX | Есть |

| Поддержка вычислений общего назначения на GPU | DirectCompute 11, NVIDIA PhysX, CUDA, CUDA C++, OpenCL |

| Охлаждение | |

| Охлаждение видеокарты | Активное охлаждение (радиатор + 2 вентилятора Twin Frozr VI на лицевой стороне платы) |

| Название системы охлаждения | Twin Frozr VI |

| Управление скоростью вентилятора видеокарты | Есть, до полной остановки |

| Конструкция системы охлаждения | Двухслотовая система охлаждения |

| Питание | |

| Потребление энергии | 180 Вт |

| Совместимость | |

| Требования к системе (рекомендуемые) | Блок питания мощностью 500 Вт |

| Разъем питания | 8 pin+6 pin подходящие переходники питания |

| Логистика | |

| Размеры упаковки (измерено в НИКСе) | 34.72 x 26.91 x 8.62 см |

| Вес брутто (измерено в НИКСе) | 1.71 кг |

Сравнение Asus 1080 Rog Strix с аналоговой линейкой видеокарт

Рассмотрим разницу между другими брендами, производящими 1080, а также разницу между 8 гигабайтной версией и 11 гигабайтной версией 1080 и 1080TI.

Разница между брендами очень большая.

Asus 1080 Rog Strix сделан из высококачественных материалов. Система охлаждения также выдает отличные показатели.

Карта имеет 3 кулера, огромный массивный радиатор и множество термотрубок, что позволяет ей держать температуру при майнинге на отметке от 62-70 градусов. Даже в душном помещении этот порог не преодолевается.

Например, MSI 1080 Armor в майнинге без дополнительного охлаждения, находясь в квартире, может дойти до 85 градусов. Так же качество сборки MSI Armor будет ниже, чем у Asus Strix. Минусом, возможно, будут выступать крупные габариты видеокарты Asus 1080 Rog Strix, намного превышающие аналогичные карты других производителей.

Так же карта сильно шумит: ферма из 6 таких карт, сопоставима шуму работающего пылесоса.

Asus 1080 Rog Strix – пожалуй одна из лучших карт, семейства представителей 1080.

Разница между 1080 и 1080 TI.

Разница между 1080 и 1080 TI весьма существенная.

На Equihash 1080 будет выдавать ~550-570 Mh/s, когда 1080 TI ~730-770 Mh/s.

Разница в цене примерно 15-20 тысяч рублей (1080 TI дороже).

Многим эта разница может показаться существенной. Но если Вы собираете ферму в квартире, то рано или поздно вы упретесь в потолок потребляемой электроэнергии. Поэтому куда выгоднее поставить несколько карт 1080 TI, чем большее количество 1080, — чем меньше карт, тем меньше они будут выделять тепла и шума. К тому же, у 1080 TI будет больше хэшрейт, так как она мощнее. Вы так же можете произвести даунвольтинг карт и поставить еще несколько 1080 TI, сделав свою ферму мощнее.

Фермы из 1080 это отличный вариант, если Вы не упираетесь «в розетку».

Сравнение Asus 1080 Rog Strix с ASUS GeForce GTX1080 Advanced

Разница между этими картами только в цене. Так как главное отличие – это разгон. Advanced уже за нас разогнан на заводе и из коробки выдает — 1695 MHz Chiptakt, 1835 MHz Boost, когда ROG STRIX — 1607 MHz Chiptakt, 1733 MHz Boost. Поэтому Advanced стоит чаще всего дороже.

Есть ли смысл переплачивать за разгон с завода?

Смысл есть, если Вы не умеете разгонять видеокарту. Также такая карта работает более стабильно в майнинге. Но при этом гонится вручную намного меньше, чем Rog Strix, — оно и логично, ее разогнали за нас на заводе. Раз на раз не приходится, но все же на 5-10 Mh/s Advanced выдает больше.

Немного истории

Началом эры SLI можно считать 1998 год. Тогда компания 3dfx впервые сумела реализовать возможность объединения нескольких видеокарт для решения одной задачи. Однако развитие интерфейса AGP затормозило разработки в этом направлении, так как все материнские платы того времени оснащались только одним слотом для видеоплаты.

SLI от 3DFX — «дедушка» современной технологии

После того, как в 2001 году 3dfx были куплены компанией Nvidia, все разработки в этом направлении ожидали своего часа, который наступил только в 2004 году. Именно тогда, в 6000-й серии GeForce (первые видеокарты, разработанные специально под новейший на то время интерфейс PCI-Express) имеющиеся разработки были усовершенствованы и внедрены в продукты массового потребления.

SLI из двух GeForce 6600GT

Сперва объединить можно было две видеокарты GeForce 6600 или 6800, с выходом 7000-й серии (в которой была представлена первая полноценная двухпроцессорная плата от Nvidia, 7900GX2) появилась возможность построения четырехпроцессорной конфигурации (из 2 карт), а позже стало возможным и сочетание 3 или 4 раздельных ГП.

Assassin’s Creed: Unity и Far Cry 4 — первые отголоски «некстгена»

Что же, перейдем к нашей «вишенке на торте». Посмотрим, как поведет себя трио GeForce GTX 980 в новых играх Ubisoft.

Небольшой дисклеймер: игры вышли больно неоптимизированными, поэтому полученные результаты не могут быть на 100% релевантными. К тому же и в Assassin’s Creed: Unity, и в Far Cry 4 реализованы далеко не все заявленные графические технологии. В общем, ждем патчей. После стабилизации ситуации вокруг этих игр я всенепременно добавлю их в обновленную методику тестирования видеокарт. Надеюсь, что это произойдет в самое ближайшее время. А пока давайте проанализируем эффективность работы 3-Way SLI, так сказать, по горячим следам.

Начну с Assassin’s Creed: Unity. Незадолго до выпуска игры Ubisoft анонсировала системные требования. В минимальных значится видеокарта GeForce GTX 680 (то есть, по сути, GeForce GTX 770), что очень лихо даже по сегодняшним меркам. Естественно, меня, а также моих коллег заинтересовала эта игра. Однако что это: маркетинговый ход или же реальная необходимость в столь производительной графике? Попробуем разобраться.

Выход версии AC: Unity для игровых консолей сопровождался настоящим скандалом. Во-первых, игра запускалась в разрешении 900p. Во-вторых, наблюдались очень серьезные просадки FPS и множество багов. На данный момент ситуацию вроде как исправили, однако AC: Unity сумела пошатнуть саму идеологию игровой приставки, ведь подобный тип устройств зачастую покупают люди, которые не хотят возиться с настройками качества графики. Они хотят играть в оптимизированные игры.

Энергопотребление и даунвольтинг

Энергопотребление. Из коробки карта потребляет 180 ватт, из которых 75 ватт идет по линии PCI-e (райзеру), затем 150 ватт через коннекторы 8 и 6 Pin.

При даунвольтенге до 151 Ватт и разгоне 1886 по ядру и +499 по памяти, карта теряет всего 10 — 15 MH/s. Что эквивалентно – 540-550 Mh/s на «Equihash».

Что такое даунвольтинг?

Это средство, благодаря которому идет занижение потребляемой видеокартой энергии.

Напряжение графического ядра удалось снизить до 875mV. Снизив напряжение, мы добились температуры в 55-57° с оборотами вентиляторов не более 40%. Таким образом, сделав легкий даунвольтинг карты, мы снизили энергопотребление карты на 29 ватт и снизили температуру ядра. При этом хэшрейт остался приблизительно на прежнем уровне.

Выводы и умозаключения

С выходом NVLink, технологию CrossFire от AMD можно смело хоронить. Она и так была хуже по реализации, чем SLI, а теперь вообще не конкурент. AMD срочно нужно что-то новое придумать, так как технологии совместной работы двух и более видеокарт станут намного производительнее, что повлечет за собой их распространение. Это станет еще одним конкурентным преимуществом.

Я думаю, что параллельная работа двух и более видеокарт будет похожа по развитию на многоядерные процессоры. Технологические процессы изготовления чипов уже настолько малы, что выпускать более сложные микросхемы становиться дорого.

Сделать многоядерным графический процессор скорее всего не получиться, так как он намного сложнее центрального. Да и с отводом тепла что-то придумывать придется. Проще отладить технологию параллельных вычислений и завести ее качественную поддержку во все игры, а не как сейчас. С выходом следующего поколения видеокарт, будет реально видно, куда будет идти развитие.

На момент написания статьи положение дел такое, что устанавливать в компьютер две видеокарты имеет смысл только если у вас разрешение монитора 4k и более. Только тогда вы получите прирост скорости в играх. Для меньших разрешений целесообразно купить одну хорошую видеокарту.

В общем пока использование двух видеокарт в компьютере остается уделом богатеньких буратино, и таким останется ближайшие 2-3 года. При примерном подсчете, стоимость игровой системы с двумя современными топовыми видеокартами ушла за 300 тысяч вместе с монитором на 8k? и чуть дешевле на 4k.

Более приземленных пользователей хочу обрадовать, что сильно расстраиваться пока не о чем, так как на самые ходовые разрешения и мониторы одной среднего уровня видеокарты пока более чем достаточно. Об этом подробнее я рассказал в статье о выборе монитора и видеокарты.

Возможно ли запустить просто две карты, без режима сли и кросса. Т.е. просто тупо чтоб рабочую область расширить, т.е. мониторов подсоединить больше. А по сути, вопрос и в том, что к примеру, есть мамки где два слотка x16, и они предназначены в основном для режима SLI. Также есть и 3 слота, правда третий хоть и по размерам как 16х, работает на 4x. И вот вопрос, по сути, они все одинаковые?? Или всётаки если использовать режим сли, то нужно подсоединять их в первый и второй, а если без сли то ТОЛЬКО в первый и третий? И получается что, если у меня два слота, то я не могу запустить две карты без сли уже? Или всё таки эти два слота могут работать отдельно друг от друга?

ЗЫ. Речь идёт тока про х16 слоты. То что можно карточку воткнуть в х1 слот, или купить карточку для х1, это всё я знаю, но вопрос конкретно про слоты х16. Обрыл весь нэт, так и не нашёо ответ на свой вопрос. Интерсует ответ знающих людей, кто в курсе технологий и функций, мамок, где установлены по два слота х16.

PSS. Забыл сказать, что я не могу ни как зупустить у себя две карточки на этих двух слотах. Одна Radeon HD6*** другая Radeon X1300 на мамке ASUS P8P67 LE

По этому “Или всё таки эти два слота могут работать отдельно друг от друга”, если вы имеете ввиду работу отдельно видеокарт, то они ВСЕГДА работают отдельно, но для процессора они ВСЕГДА единый видеоускоритель. Вы можете видеокарту ставить хоть в PCI-E x1, главное что бы были драйверы, включающие ее в видеоускоритель. Crossfire/SLI – это практически и есть набор этих драйверов.

“Забыл сказать, что я не могу ни как зупустить у себя две карточки на этих двух слотах. Одна Radeon HD6*** другая Radeon X1300 на мамке ASUS P8P67 LE” – если вопрос был в том, что можно ли Radeon HD6*** и Radeon X1300 использовать совместно, то честный ответ НЕТ. Но по идеи если найдете (или напишете) драйвера связи этих видеокарт в единый видеоускоритель, то ДА