Сюрприз

В том, что у NVIDIA не будет проблем с созданием двухпроцессорного образца, мы не сомневались. Кристалл GK104 потребляет смешные для топа 190 Вт. По сравнению со SLI-связкой, GTX 690 потеряла совсем немного: базовая частота упала с 1006 до 915 МГц. При этом GPU Boost может вывести процессоры на 1019 МГц. В остальном характеристики соответствуют удвоенной GTX 680. Количество потоковых ядер — 3072 штуки, текстурнкиов — 256 TMU, блоков растеризации — 64 ROP. Памяти теперь не 2, а 4 Гб GDDR5, работающих на 6008 МГц.

Коммутация платы стандартна для двухъядерных моделей. Фактически на одном куске текстолита расположена пара независимых карт, соединенных мостом SLI (PLX). Единственное, что есть общего у установленных GPU, — десятифазная система питания. GTX 690 требует 300 Вт, обеспечиваемых двумя вилками PCIe 8-pin.

Графический процессор и память

Сердцем видеокарты GeForce GTX 760 является графический процессор GK104-225-A2. В сравнении с его топовой конфигурацией используемой в GTX 680 и GTX 770 (GK104-400-A2 и GK104-425-A2), он лишился двух SMX-блоков, что сократило его физическую вычислительную мощность с 1536 потоковых процессоров и 128 текстурных блоков до 1152 и 96 соответственно.

Это достаточно серьезное упрощение GPU, а в особенности, оно бросается в глаза сопоставляя характеристики GK104-225-A2 с протестированной ранее GTX 670 и ее графическим процессором GK104-325-A2: по сравнению с ним, чип GTX 760 был ослаблен с 1344 потоковых процессоров и 112 текстурных блоков, до 1152 и 96 соответственно. Тем не менее, «зеленый гигант» все же дотянул производительность видеоадаптера GeForce GTX 760 до GTX 670. Но исходя из серьезного урезания вычислительных блоков, инженерам NVIDIA пришлось использовать единственный оставшийся у них метод ускорения видеокарты — повышение частоты GPU и GDDR5. В итоге, как и следовало ожидать, такой подход стал не самым выгодным с точки зрения энергопотребления получившейся GTX 760: бюджетный адаптер «семисотой» серии стал ощутимо прожорливее предтопа «шестисотой» и добрался в этом плане до топовой карты GTX 680 с ее 180 ваттами.

Откровенно говоря — совершенно неясно зачем компания NVIDIA провернула этот трюк с новой, и по факту, совершенно ненужной дополнительной конфигурацией привычного GPU GK104. Ведь по сути, все что требовалось — переименовать имеющуюся на руках GTX 670 в GTX 760 и буквально на пару процентов поднять ее частоты: Поступить ровно так же, как «зеленый гигант» в итоге поступил с GTX 680 и GTX 770 (чисто физически, характеристики этих карт абсолютно идентичны, за исключением базовых частот).

Подводя итог по аппаратной части GPU видеокарты GTX 760, хотелось бы отметить, что к счастью, NVIDIA не стала урезать блоки растеризации. Чип GK104-225-A2 сохранил максимально-доступные ему 32 ROP.

Перейдем к видеобуферу GTX 760.

В качестве видеопамяти, видеокарта Zotac GeForce GTX 760 AMP! использует те же восемь 2-гигабитных (256-мегабайтных) чипов GDDR5 производства компании SK Hynix с маркировкой H5GQ2H24AFR что и протестированная ранее GeForce GTX 670:

Согласно информации с официального сайта Hynix, данная память рассчитана на эффективную частоту в 6000МГц, однако в случае представленной видеокарты, производитель решил повысить (фактически разогнать) ее до 6200МГц. Отдельно хотелось бы отметить, что чипы H5GQ2H24AFR довольно часто встречаются на картах серии GTX 600 и GTX 700 — как на 2-гигабайтных, так и на редких 4-гигабайтных версиях (за исключением GTX 770, на этой карте зачастую установлены 2-гигабитные, или 4-гигабитные чипы Samsung с частотой 7000МГц).

Базовая частота GPU равна 1111МГц, а максимально-заявленная производителем — 1176МГц. Что подтверждается в большинстве игр: частота графического процессора действительно находится на отметке в 1176МГц. Максимально-зафиксированное напряжение графического процессора в играх остановилось на отметке 1.200 вольта, что на 0.025 вольта больше чем у GTX 670.В стресс-тесте FurMark частота GPU у нашего образца GTX 760 составила 1071МГц, при напряжении 1.100 вольта. Это вполне нормально, ведь видеокарта упирается в свой лимит энергопотребления (Power Limit) установленный на 170 ватт:

А теперь сравните эти показатели с GTX 670:

В том же стресс-тесте FurMark, напряжение питания ее ядра при базовом лимите энергопотребления составило 1.037 вольта, с TDP в 151 ватт. Таким образом, более свежая GTX 760 может потреблять на 20 ватт больше электроэнергии и следовательно, сильнее нагреваться.

Тем не менее, не стоит забывать о том, что в обоих случаях мы использовали не эталонные образцы видеокарт, из-за чего их параметры напряжения и лимита энергопотребления могут несколько отличаться от установленных по умолчанию компанией NVIDIA. Поэтому, полученные результаты нельзя назвать репрезентативными для референсов GTX 670 и 760.

С другой стороны, следует принять во внимание и то, что эти самые пресловутые эталонные образцы крайне редки и буквально через месяц-полтора после своего релиза заменяются собственными разработками производителей-партнеров компании NVIDIA. Так что в целом, полагаю, полученные данные о энергопотреблении и тепловыделении, косвенно, можно проецировать и на остальные экземпляры карт GTX 670 и 760

Осталось лишь выяснить — смогут ли дополнительное напряжение и повышенные частоты помочь GeForce GTX 760 превзойти GTX 670.

Новых карт Nvidia не будет

Компания Nvidia готовится приостановить поставки флагманских видеокарт линейки GeForce RTX 3000. Об этом пишет профильный портал HardwareTimes. Это напрямую связано с резким обесцениванием криптовалют, в особенности Ethereum.

GeForce RTX 3000 – это новейшая и самая передовая линейка видеокарт Nvidia, вышедшая в 2020 г. Nvidia прекратит поставки не одной или нескольких видеокарт новой серии, а сразу всех. Точные сроки прекращения и возобновления отгрузок пока не установлены. HardwareTimes пишет, что все может вернуться в норму или в последних числах июля 2021 г., или в начале августа 2021 г.

По мнению экспертов HardwareTimes, эти меры Nvidia предпринимает с одной-единственной целью – компания стремится не допустить резкого падения цен на видеоускорители, которые уже начали дешеветь. Майнеры, поначалу скупившие все видеокарты и образовавшие их глобальный дефицит с последовавшим за ним чрезмерно резким ростом цен, теперь начали продавать эти ускорители на вторичном рынке.

Nvidia может устроить искусственный дефицит топовых ускорителей

Распродажа видеокарт, в режиме 24/7 добывавших криптовалюту майнерам, связана как раз с падением курса самых дорогих токенов. Ethereum в этом плане находится на втором месте после биткоина – по данным CoinDesk, на момент публикации материала он стоил около $1890 (133,5 тыс. руб. по курсу ЦБ на 15 июля 2021 г.). Биткоин оценивался в $31,6 тыс. (2,34 млн руб.).

Ethereum обвалился очень сильно упал в цене

В итоге топовые видеокарты на графических чипах Nvidia заполонили доски объявлений во многих странах мира, в том числе и в России. Если новые экземпляры таких карт тоже будут в большом количестве представлены в магазине, это действительно может повлечь их стремительное обесценивание, пишет портал MyDrivers.

Биткоин тоже подешевел, но все еще остается очень дорогим

Nvidia пока не подтверждает (но и не опровергает) сведения о возможном прекращении поставок GeForce RTX 3000. Между тем, компания является лидером рынка видеокарт. По данным исследовательской компании Juniper Research, в I квартале 2021 г. она удерживала 68,18-процентную долю на нем, оставив AMD (своему основному конкуренту) лишь 16,65%. Оставшиеся 15,17% заняла Intel с видеоподсистемами, встроенными в ее центральные процессоры.

Технические характеристики

| Название | ||

|---|---|---|

| Ellesmere | Baffin | |

| Процессор | ||

| Polaris 10 | Polaris 11 | |

| Tехпроцесс | ||

| 14 н.м | ||

| Потоковые процессоры | ||

| 2560 | ? | |

| Текстурные блоки | ||

| ? | ? | |

| Конвейеры растровых операций (ROP) | ||

| ? | ? | |

| Тактовая частота GPU (базовая) | ||

| 1000 МГц | 800 МГц | |

| Тактовая частота GPU (Boost) | ||

| — | — | — |

| Объeм памяти | ||

| 8ГБ | 4ГБ | |

| Тип памяти | ||

| GDDR 5 | GDDR 5 | |

| Ширина шины памяти | ||

| 256 бит | 128 бит | |

| Частота памяти | ||

| 6000МГц | 7000МГц | |

| Версия DirectX | ||

| 12,0 | ||

| Тепловой пакет | ||

| ? | ? |

Можно сказать, что наступивший 2016 год должен стать решающим как для Nvidia так и для AMD. Обе компании должны показать индустрии, что они все еще могут быть сильными конкурентами на рынках графических процессоров. Мы относимся к Polaris с осторожным оптимизмом. В том, что первые тестовые образцы ориентированы на рынок мобильных систем, есть логика, учитывая возможность вернуть утраченную долю рынка, выпустив хорошее железо раньше конкурентов. И хотя в своей демонстрации компания выбрала процессор, предназначенный для тонких и легких ноутбуков в надежде заинтересовать своих OEM- клиентов еще на этапе проектирования, представители AMD признались, что готовят «старшую» версию чипа ближе к дате премьеры первых графических процессоров, которая, предположительно, будет предназначена для энтузиастов. Сейчас рыночная доля дискретной графики AMD составляет порядка 20%, и с выпуском Polaris компания надеется усилить свои позиции на рынке графики настольных ПК. Что касается конкурента в лице Nvidia, то в июне компания представит видеокарты GTX 1080/1070, а их официальный выпуск состоится в третьем квартале. Видеокарты семейства Pascal мейнстрим уровня станут доступными в четвертом квартале.

Стоит ли использовать несколько видеокарт?

Использование нескольких видеокарт позволит увеличить скорость обучения, поэтому имеет смысл, если у вас есть на это деньги.

Для сверточных нейронных сетей можно ожидать ускорения в 1,9x/2,8x/3,5x для 2/3/4 графических процессоров.

Для рекуррентных сетей длина последовательности является наиболее важным параметром, а для распространенных проблем NLP можно ожидать аналогичного или несколько худшего ускорения, чем для сверточных сетей.

Полносвязные сети обычно имеют низкую производительность для параллелизма данных, и для ускорения необходимы более совершенные алгоритмы.

Еще одно преимущество использования нескольких GPU, даже если вы не распараллеливаете алгоритмы, заключается в том, что вы можете запускать несколько экспериментов отдельно на каждом графическом процессоре. Вы не получаете ускорения, но получаете больше информации о производительности, используя различные алгоритмы или параметры одновременно.

Это очень полезно, если ваша главная цель — как можно быстрее получить опыт обучения сети. Это полезно и для исследователей, которые хотят попробовать несколько версий нового алгоритма одновременно.

В работе

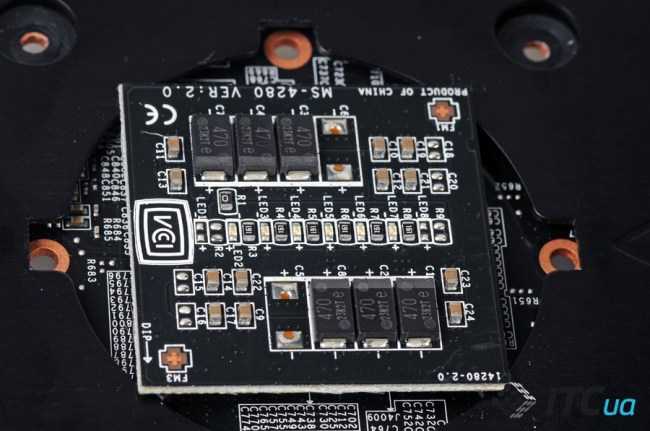

Во время работы видеокарты автоматически активируется функция Active Phase Switching, которая регулирует количество активных фаз питания для оптимизации энергопотребления. Визуально оценить работу данной технологии можно по светодиодам, установленным с обратной стороны печатной платы.

Особого внимания заслуживает система охлаждения. В режиме покоя на открытом стенде графический чип прогрелся до 28 градусов, при этом скорость вращения вентиляторов была на уровне 1000 об/мин. Под нагрузкой температура GPU возросла до 64 градусов, а обороты вентиляторов увеличились лишь до 1600 об/мин. При этом кулер работает не только ощутимо эффективнее, но и тише референсного.

Особенность системы охлаждения MSI N680GTX Lightning – заметное повышение оборотов вентиляторов во время перезагрузки ПК. Это сделано для того, чтобы предотвратить возможный перегрев видеокарты до момента запуска операционной системы и загрузки драйверов

Впрочем, при использовании видеокарты в штатном режиме такая мера предосторожности скорее избыточна

В угоду оверлокерам разработчик оснастил видеокарту функцией Triple Overvoltage. С помощью утилиты MSI Afterburner можно независимо регулировать напряжения питания графического процессора, памяти и шины. Такая возможность будет полезна при достижении предельных частот в разгоне. Кроме того видеокарта оснащена тремя термодатчиками и позволяет отслеживать температуры ядра, памяти и силовых элементов. Отметим поддержку фирменной технологии Dust Removal. Чтобы не допустить скапливания пыли на лопастях пропеллера и радиаторе, в течение 30 секунд после «холодного» старта системы вентиляторы работают в реверсном режиме.

Майнеров без видеокарт не оставят

Отобрав у криптовалютчиков игровые видеокарты GeForce, Nvidia тут же предложила им альтернативу в виде новой серии ускорителей – CMP HX. Они изначально ориентированы на майнинг и по умолчанию поставляются со специальным криптомайнинговым процессором (Crypto Mining Processor, CMP). Кроме того, у них нет внешних интерфейсов, что не позволяет использовать их ни для чего другого, кроме как для добычи виртуальных денег.

«С помощью CMP мы можем помочь майнерам построить наиболее эффективные центры обработки данных, сохранив графические процессоры GeForce RTX для геймеров», – отметили представители Nvidia.

С самого начала линейка Nvidia включает сразу четыре видеокарты, и Nvidia не исключает дальнейшего роста их количества. В серию входят ускорители CMP 30HX, CMP 40HX, CMP 50HX и CMP 90HX.

Сравнение возможностей видеокарт Nvidia для майнинга

Карта CMP HX 30НХ открывает новую серию – она поставляется 6 ГБ видеопамяти и питается от одного 8-пинового разъема, а в майнинге она способна обеспечить хешрейт на уровне 26 Мхеш/с, потребляя при этом 125 Вт. Более производительный ускоритель CMP 40HX рассчитан на 36 Мхеш/с, имеет при себе 8 ГБ памяти, один восьмиконтактный разъем питания и энергопотребление на уровне 185 Вт.

Модель CMP 50HX располагает хешрейтом в пределах 45 Мхеш/с. Здесь Nvidia расщедрилась сразу на 10 ГБ видеопамяти, но эта карта потребляет 250 Вт, и к ней нужно подключать уже два кабеля питания с 8-контактными коннекторами.

Закрывает серию CMP HX флагманская видеокарта Nvidia CMP 90HX с максимальным хэшрейтом 86 Мхеш/с. Графический ускоритель поставляется с 10 ГБ видеопамяти, двумя 8-контактными разъемами питания и расходует 320 Вт энергии.

Приехали

Для тестирования новинки мы собрали тестовый стенд на материнской плате Gigabyte GA-X58A-UD3R, воткнули в нее процессор Intel Core i7-920 и накрыли его кулером Cooler Master V6. Оперативной памяти у нас было три планки Kingston HyperX DDR3-1666 МГц по 2 Гб каждая. Операционную систему Windows 7 Ultimate 64-bit и пакет программ установили на твердотельный накопитель Kingston SSDNow объемом 64 Гб.

В качестве конкурентов взяли всю компанию флагманов: GTX 680, 580, 590 и Radeon HD 7970 c HD 6970. Сравнивали мы видеокарты в синтетических 3DMark11 и Unigine Heaven Benchmark 2.5, а также в трех играх: Aliens vs. Predator, DiRT 2, Total War: Shogun 2. С настройками не стеснялись: все на максимум, разрешение от 1680х1050, антиалиасинг — от 4x MSAA.

То, что GTX 690 окажется заметно быстрее соперников, мы понимали, но то, что в первом же бенчмарке, Unigine Heaven Benchmark 2.5, он принесет своему однокристальному брату 69%, — мягко говоря, было неожиданно. В то время как GTX 680 показывала 43,7 fps, GTX 690 выдавала ошеломляющие 74,2 fps. Следующим шоком стали результаты Aliens vs. Predator — 105,5 против 57,7 кадра в секунду. Существенно прибавила NVIDIA и в Total War: Shogun 2. В самом тяжелом режиме скорость увеличилась с 23,2 до 53,9 fps!

К сожалению, DiRT 2 не увидела двух GPU и работала с картой как с обычной GTX 680, но с пониженными частотами. Такая же ситуация у нас сложилась и с GTX 590. Как ни печально, но это особенность игры — в сочетании с определенным оборудованием она отказывается нормально загружать второй GPU.

Если с GeForce GTX 680 мы еще сомневались, называть ли NVIDIA новым королем видеокарт, то с выходом GTX 690 мы можем твердо сказать: компания выпускает самые быстрые платы в мире. Стоят они, конечно, от 35 999 рублей за штуку, но если вы не хотите стеснять себя в настройках и разрешениях, то это единственный выбор.

Производительность/стоимость

Экономическая эффективность графического процессора, вероятно, наиболее важный критерий выбора. Я провел анализ эффективности затрат, который включал пропускную способность памяти, TFLOP и Tensor Cores. Я посмотрел цены на eBay и Amazon и взвесил их 50:50, а затем посмотрел на показатели эффективности для LSTM, CNN с и без тензорных ядер. Я взял эти показатели производительности и усреднил их, чтобы получить средние оценки производительности, с помощью которых я затем рассчитал показатели производительности/стоимости. Вот результат:

Нормализованные показатели производительности/стоимости. Чем выше, тем лучше. RTX 2070 более чем в 5 раз экономичнее Tesla V100.

Нормализованные показатели производительности/стоимости. Чем выше, тем лучше. RTX 2070 более чем в 5 раз экономичнее Tesla V100.

Из этих данных видно, что RTX 2070 является более экономичным, чем RTX 2080 или RTX 2080 Ti. Почему это так? Способность выполнять 16-битные вычисления с Tensor Cores намного более ценна, чем просто наличие большого количества тензорных ядер. С RTX 2070 вы получаете эти функции по самой оптимальной цене.

Этот анализ также имеет определенные отклонения, которые следует учитывать:

- Цены колеблются. В настоящее время цены карты GTX 1080 Ti, RTX 2080 и RTX 2080 Ti кажутся завышенными, но в будущем они могут стать более разумными.

- Анализ не учитывает, сколько памяти вам нужно и сколько GPU вы можете разместить на своем компьютере. Один компьютер с 4 быстрыми GPU намного экономичнее двух компьютеров с самыми оптимальными картами.

Роскошь

Обычно мы не обсуждаем внешний вид видеокарт, но для GTX 690 придется сделать исключение. Это настоящее произведение искусства. Внутренности защищены мощным алюминиевым корпусом со множеством скосов. Центральная часть выкрашена в черный цвет, боковые — покрыты тусклым хромом и оснащены прозрачными окошками из оргстекла. Ближе к панели ввода/вывода проштамповано «GTX 690». На левой грани разместилась светящаяся зеленым надпись «GeForce GTX».

Система охлаждения по сравнению с GTX 680 усилилась. Никаких простых кулеров на тепловых трубках — взамен стоят привычные испарительные камеры, дополненные никелированными алюминиевыми радиаторами. Активный элемент один — 90-мм вертушка по центру с крыльчаткой необычной формы, понижающей уровень шума. Набор видеовыходов странный. Есть три DVI и только один Mini DisplayPort — места для HDMI не нашлось.

Технологии и софт

MSI предлагает нам достаточно много интересных, но полезных в повседневном использовании и разгоне технологий. Помимо «набивших» оскомину GPU Boost, SLI и 3D Vision, производитель предоставляет немало собственных интересных аппаратных и программных решений:

— Twin BIOS. Инженеры MSI установили на плату две микросхемы BIOS. Одна используется для повседневных задач и игр, другая — для экстремального разгона.

— Military Class 4. Компоненты устройства соответствуют стандарту качества и надежности MIL-STD-810G. Для получения данного сертификата MSI установила на карту высококачественные компоненты: транзисторы CopperMOS, конденсаторы Hi-c CAP, катушки SFC и черные твердотельные конденсаторы Dark Solid CAP.

— Triple Force. Эта технология состоит из трех элементов. TriFrozr Thermal Design отвечает за независимое управление вентиляторами. Triple Level Signals при помощи светового индикатора наглядно демонстрирует уровень загрузки видеокарты. Наконец, Pure Digital PWM Control отвечает за обеспечение более точного и стабильного напряжения в сравнении с референсным образцом видеокарты GeForce GTX 780.

— GPU Reactor. Контроллер, вынесенный на отдельную печатную плату, стабилизирует напряжение и обеспечивает стабильность работы устройства на повышенных частотах.

— Enhanced Power. Набор элементов, состоящий из 16 фаз питания GPU и 3 фаз питания видеопамяти. Кроме того производитель разместил все это на десятислойной печатной плате.

— В конструкции видеокарт применяются позолоченные контакты, которые, по заверению MSI, должны обеспечить лучшую передачу сигнала и защиту от коррозии.

Что мы узнали

При всестороннем изучении того, как линейка настольных компьютеров GeForce сочетается с мобильными, становится ясно, что даже когда два графических процессора имеют одинаковое имя, вы просто не получите производительность класса настольных ПК от ноутбука. Карты для настольных ПК на 15–35% быстрее, в зависимости от сравнения, и включение в линейку новых графических процессоров Super GPU, похоже, увеличивает разрыв.

Это означает, что каждый графический процессор ноутбука фактически обеспечивает производительность графического процессора настольного компьютера на несколько ступеней ниже в линейке. RTX 2070 для ноутбуков более близко соответствует GTX 1660 Ti для настольных компьютеров. RTX 2080 Super Max-Q соответствует RTX 2060. И так далее.

Теперь нет ничего принципиально неправильного в графических процессорах GeForce, которые вы устанавливаете на игровые ноутбуки … и они также оказались лучшими из возможных. И AMD, и Intel долгое время отсутствовали на игровом рынке мобильных ПК.

Современные игровые ноутбуки могут обеспечивать достойную производительность 1080p в дороге; хотя 1660 Ti или RTX 2060 для ноутбуков могут не очень хорошо сочетаться с картами для настольных ПК, во многих играх вы получаете не менее 60 кадров в секунду с настройками типа Ultra. В некоторых играх вы видите намного больше 100 FPS.

Учитывая, что некоторые из этих ноутбуков имеют вес менее 5 фунтов и очень портативны, предлагаемая производительность временами впечатляет, и даже скромная система среднего класса очень способна в современных играх.

Для нас главная проблема заключается в том, что Nvidia не будет дифференцировать мобильные графические процессоры и продолжает полагаться на именование, эквивалентное настольному. Возможно, утверждение, что в игровом ноутбуке за 3000 долларов есть всего лишь RTX 2060, не пойдет на пользу (настольный компьютер с таким же графическим процессором можно построить за треть цены). Если вместо этого назвать этот графический процессор RTX 2080 Super, использовать этот дорогой кремний и в конце поставить логотип «с дизайном Max-Q», это может привести к увеличению продаж.

Однако, когда вы только начинаете знакомство с игровой экосистемой для ПК, весь жаргон и названия могут сбивать с толку. Можно утверждать, что так было всегда (за исключением того, что это не так), и большую часть времени, когда графические чипы не были точно согласованы между настольными и мобильными компьютерами, графические процессоры получали разные названия или соответствующее мобильное обозначение.

На наш взгляд, компромиссом было бы вернуться к схеме именования М. RTX 2070M. RTX 2060M. Легко понять, M сразу означает для покупателей, что графический процессор не такой же, как настольная карта, но относится к тому же классу производительности, что и настольный графический процессор, по сравнению с другими в линейке.

В конечном счете, мы надеемся, что вы узнали, где будет располагаться игровой ноутбук по сравнению с настольным ПК, с которым вы, возможно, более знакомы, или наоборот. Нет правильного или неправильного ответа на вопрос, стоит ли покупать игровой ноутбук или игровой настольный компьютер, учитывая, что они обслуживают совершенно разные рынки и варианты использования, но приятно знать фактические различия в предлагаемой производительности, а не только предположения о производительности, сделанные на основе компонентов.

Хорошая компания

Архитектура Kepler очень похожа на свою предшественницу Fermi. Кристалл разбит на четыре здоровых кластера (Graphics Processing Cluster), каждый из которых несет один растеризатор и два SMX. Последние содержат 192 потоковых процессора, 16 текстурников и 32 набора специальных операций. В итоге GK104 заряжен 1536 CUDA-ядрами, 128 TMU, 8 PolyMorph Engine, отвечающих за тесселяцию, и 32 ROP. С памятью кристалл связывают четыре чипа с суммарной пропускной способностью 64 бит.

С приходим Kepler в арсенале NVIDIA появилось много интересных технологий. Самая заметная — GPU Boost, автоматически разгоняющая камень, если есть запас по TDP. Из остальных стоит отметить поддержку 3D Vision Surround на одной видеокарте, новых методов антиалиазинга, адаптивной вертикальной синхронизации и наличие дискретного чипа кодирования видео NVENC. Подробнее обо всем этом можно прочитать в прошлом номере «Игромании» №5/2012 (см. «Ответный удар»).

Дизайн и компоновка

Для охлаждения видеокарты используется хорошо зарекомендовавший себя кулер Twin Frozr IV. Сверху конструкция прикрыта алюминиевой пластиной черного цвета. При этом яркие желтые фрагменты в оформлении делают внешний облик устройства более агрессивным и запоминающимся.

С обратной стороны печатной платы также установлена металлическая пластина, но в данном случае она используется для укрепления конструкции и общей защиты PCB от повреждений.

Важной особенностью Twin Frozr IV является то, что видеокарта с данной СО занимает два слота расширения. Это является преимуществом перед трехлотовыми кулерами, особенно в тех случаях, когда планируется использовать в системе несколько таких адаптеров

Для видеокарты используется оригинальная печатная плата, а также серьезно усовершенствованная силовая подсистема. Стабилизатор напряжения содержит 12 фаз питания, для управления которыми задействован дополнительный цифровой контроллер. В цепи используются компоненты с улучшенными характеристиками, соответствующие классификации Military Class III. В качестве силовых сборок применяются чипы CopperMOS c медной корпусировкой, которые имеют улучшенные температурные и электрические показатели. Кроме того здесь задействованы ферритовые дроссели, танталовые конденсаторы, а также твердотельные емкости Dark Solid CAP с алюминиевыми сердечниками.

Для улучшения параметров силовой подсистемы в цепи питания видеокарты используется специальный модуль GPU Reactor.

Из приспособлений, которые могут заинтересовать увлеченных энтузиастов, отметим наличие коннекторов V-Check Point, позволяющих с помощью мультиметра замерить фактические напряжения питания на ядре, памяти, и шине. Для бесстрашных оверклокеров, использующих альтернативные системы охлаждения и дополнительный вольтмод, предназначен тумблер, позволяющий задействовать версию BIOS, которая фактически снимает защиту от превышения допустимых нагрузок.

Для подключения дополнительного питания вместо пары шестиконтактных разъемов применяется два восьмиконтактных коннектора. При этом производитель рекомендует использовать блок питания мощностью 650 Вт и выше, который способен обеспечить ток до 38 ампер по линии 12 вольт.

На интерфейсной панели расположены четыре разъема для подключения устройств отображения. Пара DVI, а также HDMI и DisplayPort.

Общая длина видеокарты составляет 290 мм. Это не рекордный показатель, однако, перед покупкой устройства стоит удостовериться, что в корпусе достаточно свободного места для установки адаптера.

Заключение

MSI GeForce GTX 780 Lightning является одним из лучших предложений на рынке. Прекрасный комплект поставки, обилие интересных технологий, внушительный внешний вид, качественная аппаратная составляющая — перед нами, безусловно, элитный продукт. Однако Lightning-видеокарте вполне можно подыскать достойную альтернативу за гораздо более приемлемую цену. Нас несколько огорчили показатели эффективности охлаждения, а также пусть и терпимый, но высокий уровень шума. Они могли бы быть лучше для устройства стоимостью порядка 27 000 рублей.

Подводя итог, отметим, что видеокарта MSI GeForce GTX 780 Lightning получилась достаточно специфическим продуктом, использовать полный функционал и потенциал которого будет далеко не каждый пользователь. Красиво, интересно, инновационно, но дороговато для того, чтобы установить устройство в слот PCI Express домашнего компьютера, да и забыть о нем до следующего апгрейда. «Молния» должна сверкать на открытом стенде, под жидким азотом!