Партнерство NVIDIA и CD Project Red

CD Project является самой популярной компанией по разработке игр из Польши. В начале этого года они объявили о сотрудничестве с американским гигантом Nvidia. Ведущий производитель графических процессоров не только объявил, что в Cyberpunk 2077 с момента его запуска можно будет играть даже на недорогом ноутбуке, но также представил ограниченную версию своей флагманской видеокарты, посвященной игре.

Киберпанк 2077 на рабочем ноутбуке?

Nvidia на своем официальном форуме заявили, что Cyberpunk 2077 будет доступен пользователям потоковой платформы GeForce Now с момента запуска, который состоится 19 ноября. Конечно, игру необходимо предварительно заказать в Steam, GOG или EGS.

GeForce RTX 2077

Nvidia 17 февраля представила ограниченную версию своей флагманской видеокарты для геймеров GeForce RTX 2080 Ti в версии Cyberpunk 2077 Edition. От стандартной модели она отличается, правда, исключительно ярко-желтым корпусом с большим игровым логотипом Cyberpunk. Однако был ограниченный выпуск таких видеокарт, состоящий всего из 200 моделей, которые уже были разыграны среди участников конкурса.

Первый!

Уже ни для кого не является секретом, что компания Nvidia тесно сотрудничает с корпорацией Gigabyte, поэтому и неудивительно, что игровую видеокарту на мировом рынке первым представил тайваньский производитель. Выйдя на рынок, новинка покорила сердца всех поклонников высокопроизводительных игр, ведь потенциал видеоадаптера не смог раскрыть даже четырёхъядерный процессор Core i7 (речь идёт о первом поколении кристаллов, продаваемом на момент анонса видеоплаты), а значит, ускоритель однозначно выполнен с запасом на будущее. А вот ярые поклонники тайваньского бренда особого восторга не получили от Gigabyte GeForce GTX 690.

Дело в том, что один из лучших производителей видеокарт отказался от установки на свой продукт фирменной системы охлаждения, посчитав, что в заводском исполнении адаптер и так неплохо обдувается турбированным вентилятором. По сути, взять готовый продукт, наклеить на него фирменную этикетку и упаковать в красивую коробку может каждый производитель на рынке компьютерных устройств. Технические характеристики карты не были изменены. Довольно странное решение от тайваньского производителя.

Результаты тестирования

В отсутствии реального конкурента в лице двухчиповой модели от AMD с парой GPU Tahiti XT, превосходство GeForce GTX 690 над любой видеокартой с одним графическим процессором не вызывает сомнений. Мы провели ряд практических тестов, чтобы оценить насколько велико преимущество новинки и оправдывает ли она свою цену. Специально для техногурманов также включены результаты замеров производительности связки Quad SLI.

Неудивительно, что синтетические приложения, предназначенные для оценки производительности платформ, чутко реагируют на изменение возможностей конфигураций. В обоих пакетах от Futuremark двухчиповая новинка имеет серьезное преимущество над GTX 680 – 65–75%. Использование второй GTX 690 приносит дополнительные 45% «попугаев» в 3DMark Vantage. Последняя версия пакета получше оптимизирована, возможности графической подсистемы более весомы в общем результате. Потому Quad SLI приносит 81%-ную прибавку скорости.

В Heaven Benchmark 2.5 двухголовая видеокарта, в зависимости от разрешения, имеет преимущество в 83–91% над GTX 680. Вторая видеокарта в режиме Full HD приносит дополнительные 59%, а при 2560×1440 – порядка 77%.

Если ситуация в синтетике представляет чисто академический интерес, то вот тесты в реальных играх переводят исследование в практическую плоскость. Весьма технологичных шутер Lost Planet 2 как-то без энтузиазма воспринял увеличение количества графических процессоров. И если GTX 690 еще имеет ощутимое преимущество (23–58%) над GTX 680, то использование второй двухчиповой видеокарты приносит очень и очень скромные 9–16%.

Одному из самых ненасытных пожирателей системных ресурсов – игре Metro 2033 – режимы SLI нравятся в любом виде и количестве. 56–63% – таково преимущество GTX 690 над GTX 680. Вторая двухчиповая видеокарта приносит еще 66% в режиме с высоком разрешением. Наконец-то уже можно собрать конфигурацию, которая позволит комфортно поиграть в детище 4A Games с максимальным качеством на мониторах 27–30”. В 1920×1080 количество кадров/c увеличилось на 31%. Очевидно здесь уже сказывается возможности центрального процессора.

Dirt3 заметно оживился после установки двухчиповой GeForce GTX 690 (+46-74% к результатам GTX 680), а вот с Quad SLI достойно совладать не сумел, даже в высоком разрешении (+14%). Здесь скорее сказывается особенность игрового движка, потому как в 1920х1080 полученная разница с результатами для GTX 680 была даже выше – порядка 18%, что в целом не характерно для других приложений.

Aliens vs. Predator оказалась едва ли не эталоном эффективного использования ресурсов графической подсистемы в реальных условиях. В данном случае GTX 690, графические чипы которого работают на меньшей частоте, чем у GTX 680, но их два, вместо одного, смогла на 90–92% опередить последнего. Ну, а когда две GTX 690 работают в паре, скорость отрисовки кадров возрастает еще на 74–82%. Если же сравнивать результаты платформы с Quad SLI и одной GeForce GTX 680, то их производительность отличается в 3,5 раза.

На первый взгляд не слишком притязательная к ресурсам Mafia II также с благосклонностью относится к увеличению числа GPU – GeForce GTX 690 опережает одночипового флагмана NVIDIA на 63–75%. Quad SLI приносит 56%-ную прибавку в 2560х1440, а вот в разрешении Full HD прирост уже не столь убедительный – всего 16%. С другой стороны, нужен ли он при 150 кадрах/c, вопрос риторический.

Говоря о производительности двухчиповой видеокарты, следует помнить о том, что мы имеем дело с SLI-режимом работы GPU. В этом случае скоростные показатели очень сильно зависят от программной оптимизации, как игровых движков, так и драйверов. NVIDIA активно работает с разработчиками и оперативно оптимизирует свое ПО

Энергопотребление системы с GeForce GTX 690 во время хорошей игровой нагрузки оказалось примерно на 130 Вт выше, чем у идентичной платформы c GeForce GTX 680. С одной стороны, разница ощутимая, с другой – такая конфигурация очевидно будет экономичнее ПК с парой GeForce GTX 680, работающих в SLI-режиме. Системе с разогнанным до 4,5 ГГц процессором Core i7-3770K и Quad SLI потребуется порядка 800 Вт, а если платформа собрана с щестиядерным CPU или топовыми чипами AMD, то энергопотребление будет еще выше. Это стоит учитывать при выборе БП.

В работе

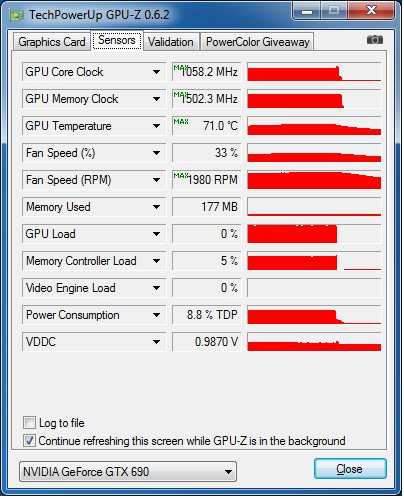

Устанавливая топовую двухчиповую видеокарту, подсознательно готовишься к тому, что сейчас все начнет шуметь и греться. На практике с GeForce GTX 690 такого не происходит.

Во время работы на открытом стенде в режиме покоя графические процессоры прогрелись всего до 28 С. Вентилятор на 1150–1200 об/мин работает очень тихо. После хорошей игровой нагрузки в нашем случае температура GPU повысилась всего до 71 градуса, а скорость вращения вентилятора приблизилась к 2000 об/мин. Шум, издаваемый системой охлаждения увеличился, но если сравнивать его с таковым, издаваемым референсным кулером GeForce GTX 680, то эти величины сопоставимы. Пара одночиповых видеокарт определенно будут несколько голосистее одной GTX 690.

Общая эффективность системы охлаждения, конечно, впечатляет. Однако условия окружающей среды на открытом стенде и в корпусе заметно отличаются

Потому еще раз акцентируем внимание на организации принудительного вывода нагретого воздуха за пределы системного блока. Как минимум, один 120-миллиметровый вентилятор на задней стенке корпуса, работающий на выдув, в данном случае точно не будет лишним

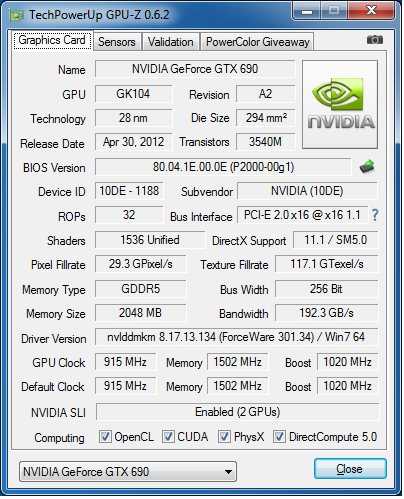

Говоря о нюансах работы видеокарты, следует отметить частотные особенности графического ядра. Алгоритм работы динамического разгона GPU Boost в данном случае весьма агрессивен. Учитывая то, что штатным значением является 915 МГц, даже при плотной нагрузке чип «выстреливал» до 1058 МГц. Заявленные же производителем 1019 МГц скорее являются неким промежуточным значением. В действительности дельта может составлять более 140 МГц, но, опять же, величина эта не постоянная и варьируется в зависимости от нагрузки, нагрева и уровня энергопотребления.

GeForce GTX 690

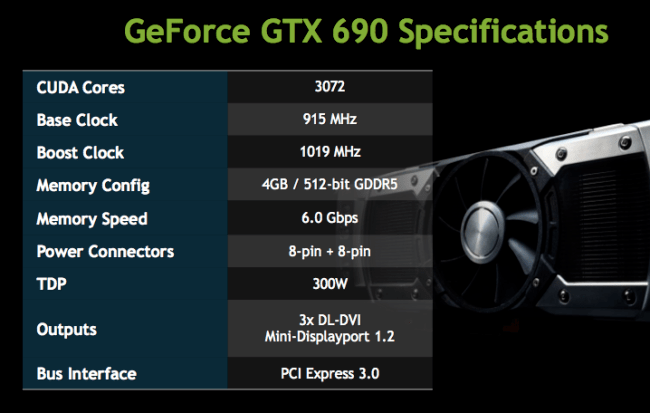

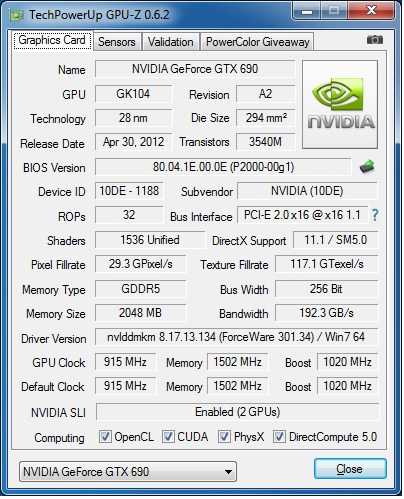

Очередной носитель архитектуры NVIDIA, основанный на двух чипах GK 104, в общей сложности имеет 3072 потоковых вычислителя CUDA. Базовая частота GPU – 915 МГц, при этом GPU Boost позволяет ядрам динамически ускоряться более чем на 100 МГц – до 1019 МГц. Отметим, что тактовые частоты графических процессоров, хотя и ниже, чем у такового для GeForce GTX 680, но отличие не столь велико, к тому же модель с двумя GPU использует более агрессивный алгоритм динамического ускорения.

Видеокарта оснащена 4 ГБ памяти GDDR5, которая работает на 6008 МГц. Каждому чипу доступны 2 ГБ, которые связаны с соответствующими процессорами 256-битовой шиной. Для подключения дополнительного питания понадобится два 8-контактных разъема. Заявленный уровень TDP сравнительно невелик, как для двухчипового решения – 300 Вт. При этом требования к мощности блока питания также довольно скромные: системе с GeForce GTX 690 будет достаточно 650-ваттного БП. Как и остальные адаптеры с чипами на Kepler, видеокарта готова к работе с PCI Express 3.0, пропускная способность которой вдвое выше, чем у шины предыдущего стандарта. Напомним, что для функционирования в режиме 3.0, новую версию интерфейса должны поддерживать процессор, в котором собственно содержится сам контроллер, материнская плата, а также видеокарта.

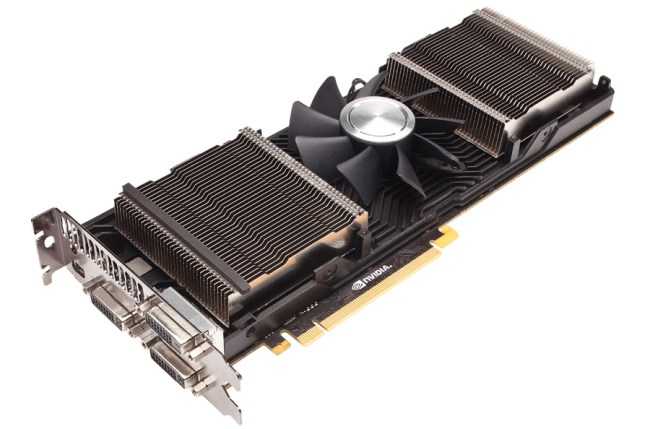

Дизайнеры отлично поработали над экстерьером видеокарты. Для верхней крышки применяется не традиционный для этого элемента пластик, а хромированный алюминий. При этом кожух адаптера не является цельным, через поликарбонатные окна можно увидеть радиаторные кассеты c набором пластин. Видеокарта выглядит очень стильно и эффектно.

С обратной стороны адаптера в защитном кожухе предусмотрена рама, также предназначенная для вывода воздуха. В этот раз он будет уже поступать внутрь системного блока, потому подумать о дополнительной вентиляции системы не помешает.

На верхней кромке нанесена надпись «GEFORCE GTX», которая подсвечивается во время работы видеокарты. В целом визуально видеокарта выглядит очень стильно и эффектно, в этом отношении разработчики отлично справились со своей задачей.

Печатная плата концептуально отчасти похожа на ту, что использовалась для двухчиповой видеокарты предыдущего поколения – GeForce GTX 590. В данном случае применяется 10-слойная PCB и низкопрофильные качественные компоненты. Силовая подсистема использует 10-фазную схему – по пять фаз для каждого GPU, а также две отдельные фазы для питания памяти. Согласование работы обоих графических ядер производится с помощью скоростного моста PLX PEX8747, имеющего пропускную способность, соответствующую спецификации PCI Express 3.0.

Результаты тестирования

В отсутствии реального конкурента в лице двухчиповой модели от AMD с парой GPU Tahiti XT, превосходство GeForce GTX 690 над любой видеокартой с одним графическим процессором не вызывает сомнений. Мы провели ряд практических тестов, чтобы оценить насколько велико преимущество новинки и оправдывает ли она свою цену. Специально для техногурманов также включены результаты замеров производительности связки Quad SLI.

Неудивительно, что синтетические приложения, предназначенные для оценки производительности платформ, чутко реагируют на изменение возможностей конфигураций. В обоих пакетах от Futuremark двухчиповая новинка имеет серьезное преимущество над GTX 680 – 65–75%. Использование второй GTX 690 приносит дополнительные 45% «попугаев» в 3DMark Vantage. Последняя версия пакета получше оптимизирована, возможности графической подсистемы более весомы в общем результате. Потому Quad SLI приносит 81%-ную прибавку скорости.

В Heaven Benchmark 2.5 двухголовая видеокарта, в зависимости от разрешения, имеет преимущество в 83–91% над GTX 680. Вторая видеокарта в режиме Full HD приносит дополнительные 59%, а при 2560×1440 – порядка 77%.

Если ситуация в синтетике представляет чисто академический интерес, то вот тесты в реальных играх переводят исследование в практическую плоскость. Весьма технологичных шутер Lost Planet 2 как-то без энтузиазма воспринял увеличение количества графических процессоров. И если GTX 690 еще имеет ощутимое преимущество (23–58%) над GTX 680, то использование второй двухчиповой видеокарты приносит очень и очень скромные 9–16%.

Одному из самых ненасытных пожирателей системных ресурсов – игре Metro 2033 – режимы SLI нравятся в любом виде и количестве. 56–63% – таково преимущество GTX 690 над GTX 680. Вторая двухчиповая видеокарта приносит еще 66% в режиме с высоком разрешением. Наконец-то уже можно собрать конфигурацию, которая позволит комфортно поиграть в детище 4A Games с максимальным качеством на мониторах 27–30”. В 1920×1080 количество кадров/c увеличилось на 31%. Очевидно здесь уже сказывается возможности центрального процессора.

Dirt3 заметно оживился после установки двухчиповой GeForce GTX 690 (+46-74% к результатам GTX 680), а вот с Quad SLI достойно совладать не сумел, даже в высоком разрешении (+14%). Здесь скорее сказывается особенность игрового движка, потому как в 1920х1080 полученная разница с результатами для GTX 680 была даже выше – порядка 18%, что в целом не характерно для других приложений.

Aliens vs. Predator оказалась едва ли не эталоном эффективного использования ресурсов графической подсистемы в реальных условиях. В данном случае GTX 690, графические чипы которого работают на меньшей частоте, чем у GTX 680, но их два, вместо одного, смогла на 90–92% опередить последнего. Ну, а когда две GTX 690 работают в паре, скорость отрисовки кадров возрастает еще на 74–82%. Если же сравнивать результаты платформы с Quad SLI и одной GeForce GTX 680, то их производительность отличается в 3,5 раза.

На первый взгляд не слишком притязательная к ресурсам Mafia II также с благосклонностью относится к увеличению числа GPU – GeForce GTX 690 опережает одночипового флагмана NVIDIA на 63–75%. Quad SLI приносит 56%-ную прибавку в 2560х1440, а вот в разрешении Full HD прирост уже не столь убедительный – всего 16%. С другой стороны, нужен ли он при 150 кадрах/c, вопрос риторический.

Говоря о производительности двухчиповой видеокарты, следует помнить о том, что мы имеем дело с SLI-режимом работы GPU. В этом случае скоростные показатели очень сильно зависят от программной оптимизации, как игровых движков, так и драйверов. NVIDIA активно работает с разработчиками и оперативно оптимизирует свое ПО

Энергопотребление системы с GeForce GTX 690 во время хорошей игровой нагрузки оказалось примерно на 130 Вт выше, чем у идентичной платформы c GeForce GTX 680. С одной стороны, разница ощутимая, с другой – такая конфигурация очевидно будет экономичнее ПК с парой GeForce GTX 680, работающих в SLI-режиме. Системе с разогнанным до 4,5 ГГц процессором Core i7-3770K и Quad SLI потребуется порядка 800 Вт, а если платформа собрана с щестиядерным CPU или топовыми чипами AMD, то энергопотребление будет еще выше. Это стоит учитывать при выборе БП.

Сравнение технических характеристик RTX и GTX видеокарт без учета трассировки лучей

Во время запуска карт серии GeForce RTX, Nvidia практически ни слова не посвятила сравнению их игровой производительности с предыдущим поколением

Основное внимание было сосредоточено только на трассировке, полностью игнорируя вещи, которые вызывают наибольший интерес у игроков. Это вызвало волну слухов, будто Nvidia не было чем похвастаться

Позже появилась утечка с презентации, которую Nvidia, вероятно, подготовили для СМИ. Там была приведена диаграмма, в которой производительность последней карты – GeForce RTX 2080 сравнивалась с GeForce GTX 1080. Из диаграммы следовало, что новая видеокарта будет примерно на 50 % эффективнее, чем ее предшественник. Все зависит, конечно, от конкретной игры, в которой проводится сравнение. Однако есть один факт, этот график касался разрешения 4K.

ZOTAC GeForce GTX 690 (ZT-60701-10P)

Zotac GeForce GTX690 ZT-60701-10P

Видеокарты на

Уведомить о появлении в продаже

Референсный дизайн GeForce GTX 690 на начальном этапе будет использоваться для всех сдвоенных видеокарт, потому не удивительно, что первая коробочная версия адаптера от ZOTAC является полной копией тестового семпла от NVIDIA. Отличие заключается в имеющейся на нижней грани наклейке, позволяющей определить принадлежность устройства к определенному бренду.

Тактовые частоты графических процессоров и ОЗУ соответствуют рекомендуемым – 915/1019 МГц для GPU и 6008 МГЦ для 4 ГБ (2×2 ГБ) память GDDR5.

Конфигурация тестового стенда

| Процессор | Intel Core i7-3770K @ 4,5 ГГц | Intel, www.intel.ua |

| Кулер | Thermalright Archon Rev.A | «1-Инком», www.1-incom.com.ua |

| Материнская плата | MSI Z77A-GD65 (Intel Z77 Express) | MSI, ua.msi.com |

| Оперативная память | Team Xtreem TXD38192M2133HC9KDC-L (2×4 ГБ DDR3-2133) | DC-Link, www.dclink.com.ua |

| Накопитель | WD WD1001FALS (1 ТБ, 7200 об/мин) | WD, www.wdc.com |

| Блок питания | Thermaltake Toughpower Grand TPG-1200M (1200 Вт) | Thermaltake, www.thermaltakeusa.com |

Лучшая для бюджетных компьютеров: Zotac GeForce GTX 1650 Super Twin Fan

Видеокарта Zotac явно лучше по сравнению с GTX 1650 без Super и представляет собой современную версию популярного графического процессора. Она предназначается для экономных пользователей с мониторами 1080p и выглядит более привлекательным вариантом по сравнению с картами AMD в этой ценовой категории.

Плюсы

- Намного быстрее по сравнению с оригинальной GeForce GTX 1650 без Super в играх на разрешении 1080p и 1440p.

- Тихо работает.

- Конкурентная цена.

- Впечатляюще маленькая.

Минусы

- Слаба в некоторых играх.

- Горячее по сравнению с GTX 1650 без Super.

Стоимость на Яндекс.Маркет

Zotac GeForce GTX 1650 Super Twin Fan

В работе

Устанавливая топовую двухчиповую видеокарту, подсознательно готовишься к тому, что сейчас все начнет шуметь и греться. На практике с GeForce GTX 690 такого не происходит.

Во время работы на открытом стенде в режиме покоя графические процессоры прогрелись всего до 28 С. Вентилятор на 1150–1200 об/мин работает очень тихо. После хорошей игровой нагрузки в нашем случае температура GPU повысилась всего до 71 градуса, а скорость вращения вентилятора приблизилась к 2000 об/мин. Шум, издаваемый системой охлаждения увеличился, но если сравнивать его с таковым, издаваемым референсным кулером GeForce GTX 680, то эти величины сопоставимы. Пара одночиповых видеокарт определенно будут несколько голосистее одной GTX 690.

Общая эффективность системы охлаждения, конечно, впечатляет. Однако условия окружающей среды на открытом стенде и в корпусе заметно отличаются

Потому еще раз акцентируем внимание на организации принудительного вывода нагретого воздуха за пределы системного блока. Как минимум, один 120-миллиметровый вентилятор на задней стенке корпуса, работающий на выдув, в данном случае точно не будет лишним

Говоря о нюансах работы видеокарты, следует отметить частотные особенности графического ядра. Алгоритм работы динамического разгона GPU Boost в данном случае весьма агрессивен. Учитывая то, что штатным значением является 915 МГц, даже при плотной нагрузке чип «выстреливал» до 1058 МГц. Заявленные же производителем 1019 МГц скорее являются неким промежуточным значением. В действительности дельта может составлять более 140 МГц, но, опять же, величина эта не постоянная и варьируется в зависимости от нагрузки, нагрева и уровня энергопотребления.

Строение GTX 690

Уж не знаю, что побудило NVIDIA выпустить двойной тандем в столь короткие сроки: верхние позиции отвоеваны силами GTX 680, скорых анонсов более быстрых решений у конкурента не предвидится. Вот бы ещё в средний сектор подбавить решений на базе свежей архитектуры — судя по прогрессу, достигнутому NVIDIA при разработке Kepler, его обрезанные решения с ещё более «холодным нравом» и замечательной производительностью могли бы потеснить семитысячные решения в наиболее интересующем пользователей среднем ценовом сегменте.

А тут — 690-я, которая сама по себе является сложным (а значит, дорогим) решением, и предназначается для хардкорных геймеров. Тем более, что в прошлом подобные решения давались компании не без труда. Чего только стоит переход с двухплатного решения на одноплатное, которое случилось уже на закате линейки 2хх. Правда, 590-я была удачнее предшественницы, однако холодной её назвать язык не поворачивался. Многие из тех, кому довелось опробовать эти карты в деле, заговаривали о пользе жидкостного охлаждения для таких решений. У «красных» проблемы были примерно те же — значительное энергопотребление, высокие рабочие температуры… В общем, при проектировании таких решений перед производителями встает непростая задача: ужать до размеров одной платы в два раза больше элементов, организовать отвод и рассеивание огромного количества тепла, сделать это решение конкурентоспособным и доступным для покупателя. Видимо, окрыленная успехом GTX 680 (который, кстати, отличался вполне умеренными аппетитами), NVIDIA рискнула представить решение с двумя графическими процессорами.

Обращайте внимание на питание

Ещё одним фактором при сборке компактного компьютера является прокладка кабелей от блока питания. Многие карты обладают силовыми коннекторами наверху, многие компактные корпуса и Mini-ITX поддерживают подобный дизайн, но некоторые предпочитают контакты на задней стороне карты.

При этом нужно знать, что многие компактные видеокарты обходятся без подключения кабеля от блока питания. Моделям вроде Zotac GeForce GTX 1650 OC хватает питания от слота PCI Express, куда они установлены.

У этих видеокарт ограниченная производительность и разгонный потенциал, поскольку они получают меньше энергии. Если это вас не беспокоит, вы можете выбрать подобную видеокарту и избежать проблем с прокладкой кабеля.

GeForce GTX 690 в режиме Quad SLI

Если не учитывать финансовую сторону вопроса, создать конфигурацию Quad SLI с GeForce GTX 690 проще простого. Для системы с четырьмя графическими процессорами необходима пара таких видеокарт. Имея на руках две GeForce GTX 690, мы не могли упустить возможность ощутить мощь четырех GK104, работающих в одной упряжке.

Помимо видеокарт, для сборки системы понадобится материнская плата с двумя слотами PCI Express x16, позволяющая использовать два графических адаптера в SLI-режиме. В нашем случае использовалась модель на чипсете Intel Z77, вполне удовлетворяющая эти требования. После установки видеокарт и объединения их мостиком-переходником система готова к работе.

С программной настройкой тоже никаких проблем не возникло. NVIDIA Control Panel рапортует об активации режиме Quad SLI.

Создавая подобную систему, особое внимание стоит уделить блоку питания. Для конфигурации с одной GeForce GTX 690 разработчик рекомендует использовать 650-ваттный БП

Используя две такие видеокарты, стоит подумать о хорошей модели мощностью 1000–1200 Вт.

Выводы и прогнозы

Если собрать все эти элементы вместе, можно сказать, что для многих RTX трассировка лучей стала скорее разочарованием. На данный момент выпущено не так много игр, чтобы играть с RTX на постоянной основе. Новое развитие производительности и эффектов визуально впечатляет, но они все еще находятся в зачаточном состоянии.

Возможно, ситуацию было бы легче «проглотить», если бы Nvidia продавала RTX по-другому. Но они продолжают продвигать ray tracing в качестве главной функции, как основную причину покупать эти новые графические процессоры и платить больше, особенно при старте продаж. Вместо этого Nvidia могла бы сосредоточиться на традиционной игровой производительности.

Однако далеко не все оказались разочарованы новой технологией, ведь в ней есть большой потенциал. Разработчикам игр нравится трассировка лучей, и постепенно все больше студий планируют добавлять RTX в новые игры.

Итоги

На сегодняшний день GeForce GTX 690 – самая быстрая видеокарта в мире. О целесообразности покупки графического адаптера за $1000 можно дискутировать довольно долго. Конечно, ценник с тремя нулями серьезно ограничивает круг потенциальных владельцев GeForce GTX 690, но в том, что она найдет своего покупателя, нет никаких сомнений. Прежде всего, это достаточно обеспеченные энтузиасты, которым нужна максимально возможная производительность. Вряд ли откажутся от подобной видеокарты и владельцы конфигураций с несколькими крупноформатными мониторами. Сдвоенная модель приносит серьезный прирост производительности, который возрастает с увеличением разрешения и улучшением настроек качества картинки. Никаким разгоном видеокарты с одним GK104 добиться таких же результатов не удастся.

Итоги

На сегодняшний день GeForce GTX 690 – самая быстрая видеокарта в мире. О целесообразности покупки графического адаптера за $1000 можно дискутировать довольно долго. Конечно, ценник с тремя нулями серьезно ограничивает круг потенциальных владельцев GeForce GTX 690, но в том, что она найдет своего покупателя, нет никаких сомнений. Прежде всего, это достаточно обеспеченные энтузиасты, которым нужна максимально возможная производительность. Вряд ли откажутся от подобной видеокарты и владельцы конфигураций с несколькими крупноформатными мониторами. Сдвоенная модель приносит серьезный прирост производительности, который возрастает с увеличением разрешения и улучшением настроек качества картинки. Никаким разгоном видеокарты с одним GK104 добиться таких же результатов не удастся.