Обзор видеокарты KFA2 GeForce GTX 550 Ti LTD OC (55NGH8HP6AXJ)

20.03.2011 19:00

Slayer Moon

| Оглавление |

|---|

| Обзор видеокарты KFA2 GeForce GTX 550 Ti LTD OC (55NGH8HP6AXJ) |

| Энергопотребление/температурный режим/уровень шума |

| Конфигурация тестового стенда и используемые игры |

| DX9: Call of Duty: Modern Warfare 2 |

| DX10: Far Cry 2 |

| DX10: Anno 1404 — Dawn of Discovery |

| DX10: Crysis WARHEAD |

| DX10: 3DMark Vantage |

| DX11: Metro 2033 |

| DX11: Colin McRae Dirt 2 |

| DX11: Battlefield Bad Company 2 |

| DX11: 3DMark 11 |

| Результаты разгона видеокарты KFA2 GeForce GTX 550 Ti LTD OC (55NGH8HP6AXJ) |

| Выводы |

Энергопотребление/температурный режим/уровень шума

Не думаю, чтобы вышеназванные показатели сильно различались у карточек GTX 550 Ti между собой, но… лучше проверить, дабы не осталось сомнений.

Энергопотребление видеокарты KFA2 GeForce GTX 550 Ti LTD OC (55NGH8HP6AXJ)

1. Система в режиме простоя потребляет = 171 ватт

2. Система с видеокартой в режиме полной нагрузки кушает = 294 ватта

3. Получившаяся разница = 129 ватт

4. Добавим среднее энергопотребление карты в режиме простоя ~ 19 ватт

5. И получаем энергопотребление в нагрузке = ~ 142 ватта

Энергопотребление всего на 2 ватта выше, чем у карточки от MSI, обзор которой Вы могли прочесть не так давно.

На фоне потребления электроэнергии HD 6990 в CFX или GTX 580 в 3-way SLI вся эта «мелочь» семейства 550 Ti смотрится просто замечательно Для KFA2 GeForce GTX 550 Ti LTD OC, Guru3D рекомендуют приобрести БП мощностью не менее 400-450 ватт.

Уровень шума, издаваемый системой охлаждения видеокарты KFA2 GeForce GTX 550 Ti LTD OC (55NGH8HP6AXJ)

Первый график показывает, тихо ли работает система охлаждения новинки от KFA2, а второй рассказывает нам ту же историю, но в нагрузке.

В простое карточка издаёт 37 децибел шума, ровно столько же, как рассмотренный недавно GTX 550 Ti от MSI.

Вновь идентичный результат с тем, что показала карта MSI GeForce GTX 550 Ti Cyclone 2. Может и по рабочим температурам продукты одинаковы?

Температурный режим

Тут всё, как всегда — сначала производится мониторинг температур в простое, потом — в нагрузке игровым приложением.

Тут уже и без моих комментариев видно положение карточки KFA2, относительно творения MSI на том же графическом ядре.

Отличный результат, пусть t° немного выше, чем у видяхи от MSI, но это не так важно, ведь прочие видеокарты намного горячее. >

<< Предыдущая — Следующая >>

| Последние материалы на сайте: |

|

Шаг 6. Проблемы при разгоне

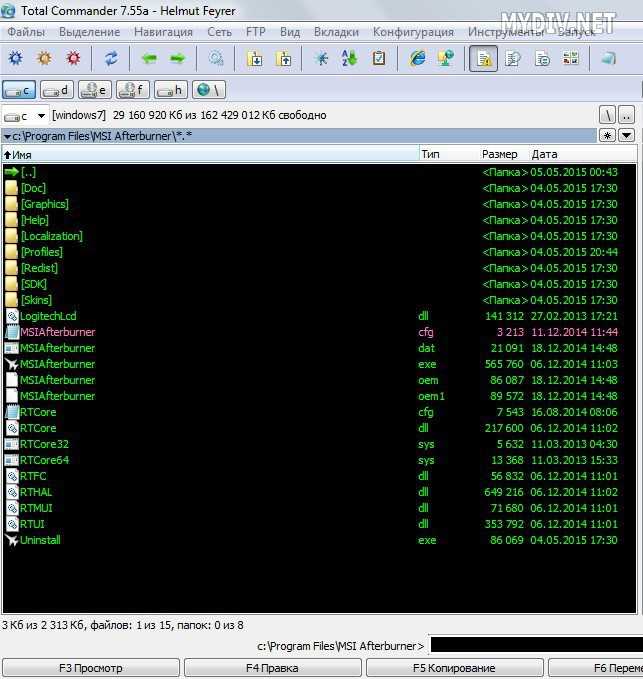

У некоторых видеокарт может быть ограничена или вовсе заблокирована опция разгона. Исправить это можно следующим образом: в папке с программой (C:\Program File\MSI Afterburner) ищем файл MSIAfterburner.cfg. Откройте его с помощью блокнота.

Ищем строчку UnofficialOverclockingEULA и пишем после знака «равно» предложение, указанное на картинке. То есть, мы соглашаемся со всеми рисками, которые последуют после снятия ограничения, а также с тем, что компания MSI не несет никакой ответственности за наши действия.

В UnofficialOverclockingMode ставим значение 1.

Учтите, что далеко не у всех карточек можно снять блокировку лимита разгона или включить управление напряжением и энергопотреблением без перепрошивки. Также бывает, что разгон удается только на старой версии драйверов.

У некоторых видеокарт может спокойно разгоняться частота ядра, но увеличение частоты памяти вызывает серьезные проблемы. И наоборот. А на очень старых картах рост производительности может быть очень низким, и разгон вовсе не имеет смысла.

источник

Тестирование

Энергосберегающие технологии CPU во всех тестах отключены. Тестирование производительности видеокарт было проведено в закрытом корпусе системного блока на системе следующей конфигурации:

Тестовая конфигурация

- Процессор: Intel Pentium G 4560 3500 МГц

- Материнская плата: MSI B250M Bazooka

- ОЗУ: 16 ГБ DDR 4 -2400 МГц

- Хранение данных: WD Hard Drive 1 ТБ 5400 об\мин

- ОС: Windows 64 bit

Синтетические тесты

Для оценки производительности в синтетике использовалcя тест 3DMark Fire Strike и Fire Strike Extreme. Futuremark 3DMark позволяет сравнивать разные устройства, от смартфонов до high-end ПК. В настройках Fire Strike можно выбрать метод и качество текстурной фильтрации, тип полноэкранного сглаживания и количество выборок мультисэмплинга, коэффициент разбиения примитивов для объектов, к которым применяется тесселяция, максимально возможный коэффициент разбиения, разрешение и количество выборок из карт теней, качество объемного освещения (шаг выборок в алгоритме «ray marching» при расчете объемного освещения — важный параметр, большие значения которого снижают производительность), количество выборок на пиксель при расчете непрямого освещения в алгоритме ambient occlusion, а также качество одного из видов постобработки — имитации эффекта глубины резкости depth of field. Этот параметр регулирует размер текстуры боке (bokeh), используемой при постобработке для объектов сцены, а настройка Color saturation изменяет только цветовую насыщенность итогового изображения, не влияя на производительность.

Futuremark 3DMark Fire Strike

MSI Radeon RX 550 AERO ITX 2G OC

3869

MSI Radeon RX 550 AERO ITX 2G OC

1801

NVIDIA GeForce GTX 970

9568

NVIDIA GeForce GTX 970

5231

NVIDIA GeForce GTX 1050 Ti

6845

NVIDIA GeForce GTX 1050 Ti

3389

AMD Radeon RX 470 4ГБ

9740

AMD Radeon RX 470 4ГБ

5142

Игровые тесты

The Witcher 3: Wild Hunt — мультиплатформенная компьютерная ролевая игра, разработанная польской студией CD Projekt RED по мотивам серии романов «Ведьмак» польского писателя Анджея Сапковского, продолжение компьютерных игр «Ведьмак» и «Ведьмак 2: Убийцы королей». Заключительная часть трилогии. По заявлениям разработчиков, третья часть серии будет сочетать в себе нелинейный сюжет и мультирегиональный открытый игровой мир, который будет в тридцать раз больше, чем мир Ведьмака 2: Убийцы королей. Для передвижения можно будет использовать различный транспорт, например лошадь или корабль. Прохождение основной сюжетной линии будет занимать порядка 50 часов игры. Побочные задания займут примерно столько же. Ведьмак 3: Дикая Охота разрабатывался на игровом движке RedEngine 3, который ориентирован на платформы будущего поколения и в конечном счете разрушат границы между игровой графикой и CGI-роликами. Принципиальная разница RedEngine 3 по сравнению со своим предшественником заключается в том, что REDengine 3 создан для поддержки игр с открытым миром. RED Engine 3 фокусируется не только на графике и физике, но и на построении нелинейной системы квестов, позволяя сделать игровой процесс еще более приближённый к реальной жизни. RED Engine поддерживает динамические тени, normal mapping и parallax. The Witcher 3: Wild Hunt имеет как базовые, так и расширенные графические установки. Любой пользователь сможет настроить игру по своему усмотрению, опираясь на производительность имеющийся системы.

Настройки графики: (1080p) High -FPS

NVIDIA GeForce GTX 1050

35

MSI Radeon RX 550 AERO ITX 2G OC

29

AMD Radeon RX 460 2ГБ

32

⇡#Прогноз на будущее

Подрядчики по выпуску микросхем, с которыми сотрудничают AMD и NVIDIA, — TSMC и GlobalFoundries — обещают безболезненный переход от нормы 14/16 нм FinFET к следующему узлу, 12 нм. Пользуясь официальными заявлениями производителей, равно как и неподтвержденными слухами, можно с уверенностью утверждать, что в 2018 году оба разработчика дискретных GPU обновят ассортимент игровых видеокарт за счет чипов нового поколения.

AMD озвучила свои намерения предельно ясно — на базе технологии 12 нм FinFET грядет обновление флагманского графического процессора Vega 10. Действительно, несколько серверных ускорителей с GPU Vega 20 и объемом памяти 16 либо 32 Гбайт уже зарегистрированы в базе устройств Евразийской экономической комиссии. Ходит довольно много слухов о GPU под названием Vega 11 с памятью HBM2, а соответствующую видеокарту прочат в соперники GeForce GTX 1060. AMD поспешила заявить, что Vega 11 является не дискретным чипом, но составной частью грядущих APU с процессорным ядром Zen, однако база ЕЭК содержит данные и о двух потребительских устройствах на основе двух конфигураций данного GPU — Vega 11 XT и Vega 11 PRO. Там же фигурирует и следующий по старшинству графический процессор, Vega 12.

Совершенно ничего не известно о модельном ряде графических процессоров Navi — следующей после Vega итерации GCN. Неофициальные источники поместили грядущий анонс новой архитектуры AMD на август 2018 года. Говорят, что чипы Navi будут производиться по норме 7 нм, и уже в этом поколении AMD может отказаться от выпуска монолитных GPU высшей категории производительности в пользу модульных конструкций из нескольких ядер, объединенных кремниевой подложкой.

В планах NVIDIA официальным наследником архитектуры Pascal является Volta, и недавний выход TITAN V указывает на то, что Volta повторит траекторию развития семейства Pascal: сначала компания выпустит флагманский игровой ускоритель на основе GPU второго эшелона, затем Volta проникнет в среднюю и начальную ценовую категории, и наконец появится видеокарта с большим GPU, которым станет либо GV100, либо его аналог, лишенный специфических вычислительных функций.

На текущий момент Volta является последней вехой в обнародованном NVIDIA манифесте развития GPU, но интернет полнится слухами о новой архитектуре под названием Ampere. А вот что именно скрывается под этим именем, пока совершенно неизвестно. У NVIDIA есть два пути — либо Ampere станет следующей универсальной платформой после Volta, которая найдет применение и в ускорителях вычислений, и в игровых видеокартах, либо NVIDIA планирует зарезервировать Volta для профессиональных продуктов, а грядущее поколение GeForce будет сформировано именно процессорами Ampere. В качестве возможного атрибута GPU Ampere называют оперативную память типа GDDR6, которая отличается скоростью передачи данных вплоть до 16 Гбит/с на контакт и повышенной энергоэффективностью по сравнению с GDDR5X.

Кроме того, NVIDIA тоже изучает перспективы GPU, собранных из нескольких дискретных ядер на кремниевой подложке. Похоже, что это неизбежный путь развития для графических процессоров, но коммерческой стадии многочиповые GPU вряд ли достигнут раньше следующего, 2019 года.

Сравнительная таблица графических плат Nvidia и AMD на 2021 год

Если же нет четкого понимания в вопросах выбора графической карты, то имеет смысл ознакомиться с показателями производительности наиболее свежих моделей. И сегодня речь идет о продукции AMD и Nvidia 2021 года выпуска, характеристики которой приведены в следующей вспомогательной таблице данных:

| Модель видеокарта | Индекс быстродействия | Частота GPU, МГц | Память размер, МБ | Частота, МГц | Ширина шины, бит | ссылка |

| NVIDIA GeForce RTX 2080 Super | 54235 | 1650-1815 | 8192 | 15496 | 256 | Посмотреть на AliExpress |

| AMD Radeon VII | 48992 | 1400-1800 | 16384 | 2000 | 4096 | Посмотреть на AliExpress |

| NVIDIA GeForce RTX 2070 Super | 47062 | 1605-1770 | 8192 | 14000 | 256 | Посмотреть на AliExpress |

| AMD Radeon RX 5700 XT | 45077 | 1605-1755 | 8192 | 14000 | 256 | Посмотреть на AliExpress |

| NVIDIA GeForce RTX 2060 Super | 42020 | 1470-1650 | 8192 | 14000 | 256 | Посмотреть на AliExpress |

| NVIDIA GeForce RTX 2060 | 39010 | 1365-1680 | 6144 | 14000 | 192 | Посмотреть на AliExpress |

| NVIDIA GeForce GTX 1660 Ti | 32756 | 1500-1770 | 6144 | 12000 | 192 | Посмотреть на AliExpress |

| NVIDIA GeForce GTX 1660 Super | 30873 | 1530-1785 | 6144 | 14000 | 192 | Посмотреть на AliExpress |

| NVIDIA GeForce GTX 1660 | 28825 | 1530-1785 | 6144 | 8000 | 192 | Посмотреть на AliExpress |

| NVIDIA GeForce GTX 1650 Super | 25364 | 1530-1725 | 4096 | 12000 | 128 | Посмотреть на AliExpress |

Эта табличка поможет не только определиться с выбором нового устройства, но и оценить по достоинству характеристики уже установленной на ПК видеокарты, а также понять перспективность обновления. Стоит отметить, что апгрейд видеокарты является не самым лучшим решением, поэтому лучше сразу приобретать устройство с качественной аппаратной составляющей или быть готовым к ее замене. В последнем случае имеет смысл менять карту только в том случае, если новая модель окажется хотя бы на пять уровней выше текущей, иначе – игра не стоит свеч.

MSI GeForce GTX 550 Ti разгон

На сколько ты их повышаешь? Поднял частоты на +30(ядро, шейдеры) и +50(память) , применил, протестировал (запустил тяжёлую игрушку) , если всё ок — поднимай дальше, но уже с меньшим шагом и т. д. Фпс падает скорее всего из за того, что вы сильно повышаете частоты и они сбрасываются на дефолт. А вообще, разгон 550ой особо ничего не даст, так что можешь не заморачиваться.

\\Не трогай напряжение. Для начала научись работать с остальным и прочитай мануалы по разгону, иначе спалишь карту к чёрту! Хотя, если хочешь — могу сказать как его разблокировать, мне то, собственно, по барабану. Setting-Основные-Разблокировать управление напряжением, разблокировать мониторинг напряжения (ставишь галочки) , затем apply(применить) и всё.

Не хватает напряжения скорей всего, надо вольтаж поднять

\\\А как его поднять он установлен на минимуме и не сдвигается с места? \\\

Там в настройках есть разблокировать управление напряжением. .Не слушай трусишек. там стоит ограничение в биосе. высоко задрать не получится, так что все так же относительно безопасно как и обычный разгон

источник

Что лучше для ноутбука – Nvidia или AMD

Если же говорить не о стационарном, а о мобильном ПК, то выбор оптимального решения по видеографике будет напрямую зависеть от тех задач, которые стоят на ежедневной повестке перед пользователем. И если речь идет о работе в Office-ных приложениях, то можно ограничиться самыми примитивными моделями интегрированных карт от Intel.

Что касается продукции AMD, то для того, чтобы потянуть тяжелый гейминг, пользователю придется раскошеливаться на ПК с графикой серии Vega и RX, а это не менее 100 тысяч российских рублей. Примечательно, что модели подешевле являются откровенно слабыми, и если уж и тратиться, то на устройства с топовыми видеокартами от NVIDIA, которые делают железо по-настоящему мощным.

Подводя общую черту, стоит отметить, что многие разработчики склоняются именно к линейке GeForce от Nvidia, однако это не означает, что AMD значительно хуже. А все потому, что решающую роль в вопросах выбора будет играть не только конкретная модель GPU, но и ее компоновка с CPU и RAM (от производительных характеристик последних напрямую зависит качество работы видеокарты).

На что способна видеокарта 2011 года: Видео

Здравствуйте!

99% вопросов по поводу производительности видеокарты задают любители игр. Именно в играх, если видеокарта устарела и не тянет, вы начнете замечать притормаживания, картинка дергается, идет рывками, и играть становится очень не комфортно.

Чтобы увеличить количество FPS (это кол-во кадров в секунду, чем выше этот параметр — тем лучше!), выдаваемое видеокартой, можно прибегнуть к разным способам: разогнать видеокарту, уменьшить качество графики в настройках игры, задать оптимальные параметры драйвера видеокарты (с прицелом на производительность ). Вот о тонкой настройки видеокарты, я и напишу пару строк в этой статье…

Какие игры тянет видеокарта Nvidia Geforce GTX 550 Ti

Рассматриваемый видеоадаптер обладает вполне приемлемыми характеристиками для увлечения видеоиграми, о чем говорит и частота ядра, и количество памяти, и прочие показатели. Рассмотрим подробнее, какие игры пойдут с Nvidia Geforce GTX 550 Ti. Карточка способна поддерживать и предоставлять вполне комфортные условия в следующих играх на разрешении 1680х1050 dpi:

- Mafia 2 – занимает 2 позицию из тестируемых карт, находится между GTX 460 768MB и GTS 450 1024MB.

- Bulletstorm – находится на 3 месте и обеспечивает вполне нормальные условия на максимальных настройках графики.

- Crysis: Warhead – карта находится уже на 4-й позиции после Radeon HD 5770, выдает 28,1 fps.

Также неплохой показывает тест карта GTX 550 Ti в играх: Just Cause 2, Two Worlds 2, Colin McRae: DiRT 2, Aliens vs. Predator.

Какая видеокарта будет более производительной в играх

Сегодня продукция AMD считается представителем бюджетного сегмента, тогда как Nvidia относится к среднему и высшему классу. И если подбирать оптимальный вариант видеокарты на игровых ПК, то лучше все-таки отдать предпочтение линейке GeForce, хотя не последнюю роль в этом вопросе будет играть тип гейминга. В целом же, все актуальные сегодня GPU можно разделить на три подкатегории:

- Low-end. Идеальное бюджетное решение для тех, кто не требует от графики многого. Преимущественно речь идет об AMD, хотя эти видеокарты неплохо справляются и с некоторыми средними игрушками.

- Middle-end. В этом сегменте встречается не только AMD, но и Nvidia, которых вполне хватит на запуск игр в высоком режиме FHD без серьезных провисаний по ФПС. А вот для 4K такого потенциала будет маловато, иначе придется пожертвовать отсутствием багов по ФПС.

- Hi-end. Безусловное царство топовых Nvidia, которым уж точно будет нипочем 4K. Другое дело, что обойдутся такие флагманы в копеечку, будучи по карману далеко не каждому геймеру.

Такая градация дает четко понять, что отвечать завышенным требованиям сможет только графика от Nvidia, тогда как для не самого мощного игрового контента подойдет AMD. И если пользователь не планирует задействовать на всю катушку потенциал дорогого оснащения, то не стоит и переплачивать, тем более что разница действительно существенная.

Технические характеристики видеокарты

Чтобы понять возможности видеокарты от Nvidia, необходимо изучить основные характеристики GTX 550 Ti:

- Имеет мощное графическое ядро GF116-400-A1.

- Имеет 192 шейдерных процесса.

- Поддерживает системы DirectX 11 (Shader Model 5.0) и OpenGL 4.1.

- Обладает возможностью работы с фирменными технологиями: SLI, CUDA, PureVideo HD, PhysX, 3D Vision.

- Процессор работает на 900 МГц, а шейдерный блок – на 1800 МГц.

- Память работает на 1025 МГц, в пиковых режимах она может увеличиться до 4100 МГц.

- Карта оснащена памятью типа GDDR5 объемом 1024 МБ.

- Битность шины составляет 192.

- Имеет обычный стандарт для подключения – PCI-E1 х16.

- Поддерживает 2560 х 1600 dpi в режиме Dual-link DVI, 1920х1080 dpi в режиме HDMI, 2048 х 1536 dpi в режиме VGA.

- Оснащена 3-мя типами интерфейсов: 1 xDVI-I, VGA и HDMI. Поддерживает форматы MPEG-2, MPEG-4, DivX, WMV9, VC-1 и H.264/AVC, есть HDCP.

- Для стабильного питания карты требуется блок питания мощностью не менее 400 Вт.

Характеристики Nvidia Geforce GTX 550 Ti говорят о среднем классе карты, свидетельством чего является объем встроенной памяти GDDR5 на 1 Гб. Плата отлично себя зарекомендовала в качестве игрового процессора.

⇡#NVIDIA TITAN Xp и TITAN V

Появление GeForce GTX 1080 Ti полностью обесценило TITAN X — ведь эти видеокарты практически равны по быстродействию, поэтому выход обновленной версии просьмерского ускорителя, TITAN Xp, оставался лишь вопросом времени. Однако, пусть TITAN Xp обладает полностью функциональным графическим процессором GP102, прирост быстродействия сравнительно с GeForce GTX 1080 Ti за счет разблокированных вычислительных блоков и дополнительного гигабайта оперативной памяти оказался довольно скромным.

Впрочем, и TITAN Xp с недавних пор и не претендует на эксклюзивный статус, которым некогда наслаждался TITAN X. Спустя всего лишь год после первого «Титана» на основе архитектуры Pascal увидел свет TITAN V, в котором уже применяется GPU семейства Volta. Особенность ситуации в том, что TITAN V получил старший и пока единственный чип Volta — GV100, в то время как Pascal высшего эшелона (GP100) так и не дошел до просьюмерских видеокарт, не говоря уже об игровых.

NVIDIA TITAN V

GV100 представляет собой чрезвычайно амбициозный проект. Кристалл характеризуется рекордной площадью и количеством транзисторов (21,1 млрд). Фактически это микросхема с наибольшим транзисторным бюджетом среди всех когда-либо выпущенных на сегодняшний день, считая гигантские FPGA и многокристальные процессоры AMD EPIC/Threadripper. Этому достижению поспособствовал техпроцесс 12 нм FinFET, на который NVIDIA переключилась с проверенного 16 нм FinFET.

Хотя GPU в составе TITAN V не является полностью функциональным (часть вычислительных блоков и одна из сборок памяти HBM2 была отключена), все равно TITAN V располагает на 33% большим набором шейдерных ALU по сравнению с TITAN Xp. Но игры и 3D-рендеринг как таковой не являются основной сферой применения TITAN V. Главное нововведение архитектуры Volta — специализированные ядра для тензорных операций (произведение матриц А и B складывается с матрицей C), которые используются главным образом в обработке данных сетями машинного обучения (inference). Кроме того, NVIDIA существенно модифицировала организацию стандартных ядер CUDA с целью разместить на площади GPU как можно больше вычислительных ресурсов.

Графический процессор NVIDIA V100 на плате Tesla V100

В расчетных задачах TITAN V полностью оправдывает свою беспрецедентно высокую цену — $3 000. С другой стороны, в рендеринге (в частности, в играх) возможности GV100 пока под вопросом: по сравнению с TITAN Xp прирост производительности с текущей версией драйвера явно не соответствует как технологической, так и ценовой разнице двух видеокарт.

⇡#NVIDIA GeForce GTX 1080 Ti

Дебют семейства Vega от AMD ничуть не поколебал позиции в качестве лидера высокопроизводительных игровых ускорителей. Учитывая тот факт, что Vega с момента обнародования спецификаций GPU не претендовала на большее быстродействие в рендеринге графики, чем GeForce GTX 1080, у NVIDIA даже не было острой необходимости обновлять модельный ряд серии GeForce 10 столь рано, но в итоге новый флагман, GTX 1080 Ti, увидел свет уже в марте прошедшего года.

Перед тем как попасть на потребительский рынок, графический процессор GP102 заявил о себе в составе «счетных» ускорителей Tesla и просьюмерской видеокарты TITAN X. Это стандартная тактика NVIDIA: верхнюю позицию в новой линейке геймерских видеокарт какое-то время занимает устройство на чипе второго эшелона (в данном случае это GeForce GTX 1080), а флагманский GPU сперва снимает сливки в профессиональной категории и лишь затем, с потерями вычислительных блоков и функций, доходит и до игровых устройств.

NVIDIA GeForce GTX 1080 Ti Founders Edition

GeForce GTX 1080 Ti фактически представляет собой TITAN X со скидкой. По сравнению с «Титаном» игровая видеокарта недосчиталась всего лишь одного контроллера RAM, восьми ROP и 1 Гбайт локальной памяти. В играх эти потери полностью компенсированы повышенными частотами GPU и RAM. Даже расчетные возможности GP102 в GTX 1080 Ti сохранились в полной мере: видеокарта может агрегировать четыре операции над данными int8 за один такт 32-битного CUDA-ядра — точно так же, как и TITAN X, который позиционируется в качестве ускорителя задач глубинного обучения.

Выпустив GeFoce GTX 1080 Ti, NVIDIA завершила переход от GPU эпохи 28 нм к новому поколению, т. к. разница в игровом быстродействии между новым флагманом и его предшественником, GeForce GTX 980 Ti, составляет убедительные 54–67%. GTX 1080 Ti стала первой среди потребительских видеокарт, которая безоговорочно подходит для игры в разрешении 4К. На это достижение претендовали еще GeForce GTX 780 Ti и Radeon R9 290X, но до появления GTX 1080 Ti задача была по силам только TITAN X или паре GTX 1070/1080 в режиме SLI.

Тестирование

Nvidia GeForce RTX 3050 TGP 75 Вт

4802

Nvidia GeForce GTX 1650 TGP 50 Вт

3080

Более 60FPS

Высокий Фреймрейт

Shadow of the Tomb Raider. Действие игры Shadow of the Tomb Raider происходит после событий, изображенных в RISE OF THE TOMB RAIDER. На этот раз мисс Крофт отправляется в Латинскую Америку, где она путешествует по развалинам древней цивилизации (включая пирамиды майя и ацтеков), обнаруживает тайны Ордена Троицы и узнает больше об исследованиях, проведенных ее отцом. История более зрелая, чем в предыдущих играх. Чтобы изобразить Лару как более продвинутого авантюриста, разработчики намеревались заставить ее столкнуться с последствиями решений, которые она приняла. Для Rise of the Shadow of the Tomb Raider использует новый игровой движок под названием Foundation Engine. Shadow of the Tomb Raider включает улучшенное подповерхностное рассеивание на Ларе, объемное освещение и лучи света, пробивающиеся через листву. Также новая игра использует продвинутое сглаживание — TAA, вместо SMAA. Кроме того улучшились эффекты воды и волны от движения теперь имеют трехмерную форму, да и в целом взаимодействие с водой лучше. Тесселяция присутствует в обеих играх, однако используется для разных целей.

Настройки: дисплей 1920 x1080 пикселей, детализация: High Preset

тестовый уровень 60 FPS

NVIDIA GeForce RTX 3050 TGP 75Вт Laptop

69FPS100%

NVIDIA GeForce GTX 1650 TGP 50Вт Laptop

55FPS91%

Настройки: дисплей 1920 × 1080 пикселей, детализация: Highest Preset

тестовый уровень 60 FPS

NVIDIA GeForce RTX 3050 TGP 75Вт Laptop

46FPS76%

NVIDIA GeForce GTX 1650 TGP 50Вт Laptop

35FPS58%

Таблица сравнения производителей

Представленная карта выпускается разными производителями. Для облегчения выбора адаптера сделаем небольшой сравнительный анализ в виде таблицы.

| Производитель | Palit | Asus | Gigabyte | Msi | Inno3D |

|---|---|---|---|---|---|

| Ядро | GF116 | GF116 | GF116 | GF116 | GF116 |

| Охлаждение | Активное | Активное | Активное | Активное | Активное |

| Техпроцесс, (мкм) | 0.04 | 0.04 | 0.04 | 0.04 | 0.04 |

| Число транзисторов | 1170 | 1950 | 1170 | 1170 | 1170 |

| Частота работы ядра, МГц | 900 | 975 | 900 | 900 | 920 |

| Количество шейдерных блоков | 192 | 192 | 192 | 190 | 192 |

| Тактовая частота шейдерного домена | 1800 | 1950 | 1800 | 1800 | 1840 |

| Объем видеопамяти | 1024 | 1024 | 1024 | 1024 | 1024 |

| Тип видеопамяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

| Предельная температура процессора, °С | 100 | 100 | 100 | 100 | 100 |

| DirectX | 11.0 | 11.0 | 11.0 | 11.0 | 11.0 |

| Ширина шины | 192-bit | 192-bit | 192-bit | 192-bit | 192-bit |

| Эффективная частота памяти | 4104 | 4104 | 4100 | 4104 | 4100 |

| Пропускная способность, (Гбайт/с) | 98.4 | 98.4 | 98.4 | 98.4 | 98.4 |

| Цена, $ | 120 | 116 | 114 | 117 | 120 |

Как видно, разница между производителями видеокарт совсем небольшая. Цена на Nv >Последние драйвера

Скачать драйвер для видеокарты Nvidia Geforce GTX 550 Ti рекомендуется с официального сайта производителя. Это можно сделать двумя способами:

- Вручную, указав все параметры самостоятельно (тип продукта, серию, семейство, ОС и язык).

- Автоматически. В этом случае необходимо учесть, что служба NVIDIA Smart Scan требует последней версии ПО Java.

Также рекомендуется установить специальное приложение GeForce Experience, которое будет автоматически уведомлять пользователя о том, когда необходимо обновить драйвера видеокарты Nv >

Для Windows 10

| 32-bit | 64-bit |

Размер файла:

400.00 МБВерсия драйвера: 391.35 (WHQL) от 27.03.2018;Язык: РусскийОперационная система: Windows 10 32/64-bit, Windows 7 32/64-bit, Windows 8.1 32/64-bit, Windows 8 32/64-bit, Windows Vista