какая видеокарта лучше? 1)NVidia GeForce GT220 2)NVidia GeForce GTS450

Gts 450 1gb равна gts 250 только немного производительней GT220 — где то слабее 9800гт — а та в свою очередь немного слабее — gts 250 Итого — gts 450 1.5 раза производительней ()естественно с заводским или домашним разгоном) + дх11 и новый тех. процессор который жрет меньше энергии Ответ напрашивается сам, по всем категориям лучше gts Но я бы советовал бы gtx 550 1gb — она стоит так же но, кое где лучшке ибо — учтены все проблемы и ошибки что были — в гтс 450 Видеокарта NVIDIA GeForce GTX 550 Ti 1024M ASUS GTX 550 Ti ENGTX550 Ti DC/DI/1GD5 — 4 468 руб Видеокарта NVIDIA GeForce GTS 450 1024M ASUS GTS450 ENGTS 450 DirectCU/DI/1GD5 — 4 022 руб

Альтернативный вариант 1. NVIDIA GeForce GTX 690 по цене 35 000 руб.

| NVIDIA GeForce GTX 690 2x 2048MB | |

|---|---|

| Ссылка на тест и обзор | «Тест и обзор: NVIDIA GeForce GTX 690» |

| Кодовое название | 2x GK104 Kepler |

| Техпроцесс | 28 нм |

| Потоковые процессоры | 2x 1536 |

| Текстурные блоки | 2x 128 |

| Конвейеры растровых операций (ROP) | 2x 32 |

| Ширина шины памяти | 2x 256 бит |

| Частота GPU | 915 МГц/1019 МГц Boost |

| Частота памяти | 1502 МГц (6008 МГц эффективная) |

| Модель DirectX/Shader | DX 11.1/SM 5.0 |

| Тепловой пакет | 300 Вт |

Если вы не хотите мучаться со сборкой конфигурации SLI на двух NVIDIA GeForce GTX 680, то смело приобретайте GeForce GTX 690. Перед нами самая быстрая видеокарта с двумя GPU в мире, за неё не стыдно и заплатить больше $1000.

Подходит для разрешений 5760 x 1080/1200 и выше.

| NVIDIA GeForce GTX 690 2x 2048MB | |

|---|---|

| Ссылка на тест и обзор | «Тест и обзор: NVIDIA GeForce GTX 690»«Тест и обзор: 2x GeForce GTX 690 в Quad SLI» |

| Кодовое название | 4x GK104 Kepler |

| Техпроцесс | 28 нм |

| Потоковые процессоры | 4x 1536 |

| Текстурные блоки | 4x 128 |

| Конвейеры растровых операций (ROP) | 4x 32 |

| Ширина шины памяти | 4x 256 бит |

| Частота GPU | 915 МГц/1019 МГц Boost |

| Частота памяти | 1502 МГц (6008 МГц эффективная) |

| Модель DirectX/Shader | DX 11.1/SM 5.0 |

| Тепловой пакет | 2x 300 Вт |

Нужна экстремальная производительность для экстремальных разрешений? Тогда почему бы не приобрести две NVIDIA GeForce GTX 690 в конфигурации 4-way SLI? Конечно, потребуется мощная система с новеньким процессором Ivy Bridge, но разве это помеха для хардкорного геймера или энтузиаста?

На что способна подобная конфигурация? Об этом вы сможете прочитать в обзоре «Тест и обзор: 2x GeForce GTX 690 в Quad SLI».

Сравнительная таблица производительности видеокарт

На сайте Tom’s Hardware Guide вы можете ознакомиться с таблицей относительной производительности видеокарт. Мы рекомендуем выполнять апгрейд, только если новая видеокарта на три-четыре позиции обгоняет старую. Иначе обновление вряд ли скажется на производительности.

Таблица сбалансированных пар GPU + CPU

Вместе с нашим читателем с ником dblourier мы предлагаем таблицу рекомендованных пар GPU+CPU. Мы также рекомендуем ознакомиться с отдельным руководством по выбору CPU для разных ценовых бюджетов.

В таблице ниже приведены сбалансированные пары, мы не рекомендуем брать видеокарты из более производительной ступеньки — процессор просто их «не потянет», частота кадров будет упираться в CPU. Опять же, мощный процессор при слабой видеокарте будет простаивать — частота кадров в играх будет ограничиваться видеокартой.

| Семейство процессоров | Видеокарты |

|---|---|

| Intel Core i5-2500K, i5-3570K и выше | AMD Radeon HD 7950, HD 7970 (GHz Edition), HD 7870, Nvidia GeForce GTX 580, GTX 690, GTX 680, GTX 670 |

| Intel Core i5-2xxx, i5-3xxx, i5-750/i5-760 | AMD Radeon HD 7850, HD 6950 2 GB, HD 6970, Nvidia GeForce GTX 560 Ti 448 Cores, GTX 570, GTX 660 Ti |

| Intel Core i3-32xx, i3-21xx | AMD Radeon HD 68×0, HD 6930, HD 6950 (1 GB), Nvidia GeForce GTX 560, GTX 560 Ti, GTX 660 |

| Intel Celeron G, Pentium G и ниже | AMD Radeon HD x750, HD x770, Nvidia GeForce GTX 550 Ti, GT 640 |

| AMD FX-81xx | Radeon HD 6950 2 GB, Nvidia GTX 560 Ti 448 Cores |

|---|---|

| AMD FX-61xx, FX-4170 | Radeon HD 6930, HD 6950 1 GB, Nvidia GeForce GTX 560Ti, GTX 660 |

| AMD FX-41xx, 4-ядерные Phenom | Radeon HD 68×0, HD 7750, HD 7770, Nvidia GeForce GTX 560, GT 640 |

Анонс GeForce GTX 660 и 650

Видеокарта GeForce GTX 660 Ti (тест и обзор) номинально относится к среднему классу, но она базируется на high-end GPU GK104, как видеокарты GTX 670 и GTX 680. А видеокарты среднего уровня на основе процессоров GK106 и GK107 до сих пор ещё не появились. Конечно же, мы имеем в виду модели GeForce GTX 660 и GTX 650, которые почти что готовы побороться за кошельки покупателей. Выход новинок ожидается совсем скоро, поэтому ниже мы приведём суммарную информацию, которая имеется у нас на данный момент.

Базовые спецификации конкурентов AMD Radeon HD 7800 и HD 7700 стали известны довольно давно. В GeForce GTX 650 используется GPU GK107, который уже знаком нам по GeForce GT 640. То есть мы получим 384 потоковых процессоров CUDA и 128-битный интерфейс памяти. Основное отличие от GT 640, похоже, будет заключаться в памяти: вместо DDR3 будет использоваться 1 Гбайт более скоростной памяти GDDR5. Недавно появилась и фотография GeForce GTX 650, на которой можно видеть печатную плату очень схожего с GT 640 дизайна, но, по крайней мере, дополнительный 6-контактный разъём питания PCIe отличается от GeForce GT 640. Энергопотребление, между тем, заявлено на уровне всего 65 Вт, а ориентировочная цена — $149.

GeForce GTX 660 будет совершенно иной. Видеокарта базируется на новой архитектуре GK106, она использует целых 960 потоковых процессоров CUDA. 2 Гбайт памяти GDDR5 будут подключаться по 192-битному интерфейсу. На первых фотографиях GK106 можно видеть, что 28-нм GPU имеет примерно такой же размер, что и старый GF116. Ожидается работа на 980 МГц для GPU (1033 МГц в режиме Boost) и 1500 МГц для памяти. Тепловой пакет должен составлять 140 Вт, энергия помимо слота PCIe будет подаваться через 6-контактный разъём дополнительного питания PCIe. У моделей с заводским разгоном можно ожидать двух 6-контактных гнёзд PCIe.

Подробнее о новых видеокартах можно прочитать в новости Hardwareluxx. Появились и первые результаты тестов GTX 660.

Как разогнать Nvidia Geforce GTX 670

Видеоадаптеры GTX 670 оснащены двумя дополнительными 6-типиновыми разъемами питания. Это значит, что видеокарты отлично поддаются ручному разгону до более высоких частот. Особенно резонно промышлять этим, когда на руках имеется вариация видеокарты с двумя вертушками.

Отметим, что видеокарта сама по себе использует технологию авторазгона. Подобное решение используется во всех чипах на архитектуре Kepler. Так, частоты в зависимости от нагрузки на адаптер могут подниматься со стандартных 915 МГц до 980 без вмешательства пользователя. Опытным оверклокерам получится выжать из чипа более 1100 МГц при определенных навыках.

Разгон GTX 670 может принести пользователю прирост в производительности примерно на 13-14%, что достаточно существенно. При этом карта будет греться в среднем на 5 градусов сильнее. Это относительно большое значение, но температура остается комфортной.

- Скачать программу для Overclocking’а. К примеру, народного любимца – MSI Afterburner.

- Помнить, что разгон – это лотерея. Не стоит выжимать из графического адаптера все соки, если пользователь не уверен в своих возможностях или это его первый разгон.

- Скачав и установив программу для разгона, пользователь должен ее запустить.

- В открывшемся окне обычно отображается вся информация о видеоадаптере, вплоть до версии драйвера.

- Пользователя интересует только два параметра: Core Clock и Memory Clock – частота ядра и частота памяти соответственно.

- Оба значения нужно понемногу повышать. В среднем, шаг составляет 20-25 единиц (после каждого передвижения ползунка нажимать «Apply»). Все манипуляции стоит проводить с запущенной в фоне игрой, желательно в оконном режиме.

- Игра в фоне открыта не просто так – это индикатор того, что разгон проходит нормально. После каждого шага необходимо запускать игру и проверять, не появляются ли на мониторе «артефакты».

- Так можно достичь оптимального результата при разгоне и не сжечь видеокарту.

- Скорость вращения вентилятора на видеокарте зачастую можно не трогать – она увеличивается пропорционально вашим действиям по увеличению частот памяти и ядра.

- Сохранив прогресс, можно переходить к работе.

Последнее, что хотелось бы отметить по разгону видеоадаптера – стремитесь к частоте по ядру в примерно 1070-1100 МГц, памяти – 1620 МГц.

Как определить установлена ли в ноутбуке видеокарта NVIDIA GeForce GT 630M?

попробуйте поискать в софте который идет на дисках к ноуту возможно там есть принудительное переключение, или выключить Интел НД Графикс в диспетчере устройств (правда если при этом система не перейдет на 630м то будет чёрный экран, скорее всего, и возможно придется сносить винду но я так не делал не знаю)) Так сделано с целью энергосбережения и не зря, в винде НД графикс хватает, а при запуске игр система переходит на 630м, хотя 630м откровенно слабая карта и пихать её в ноут с интегрированной в проц графикой интел толку немного так-как она не намного шустрее, но это уже на совести маркетологов Делл

Производительность

Результаты тестирования можно найти в интернете, я же сведу в таблицу некоторые значения, чтобы была видна «картина» того, на что способны эти процессоры.

| Параметр | i3 | i5 | i7 | |||

| Модель | 6100U | 7100U | 6200U | 7200U | 6500U | 7500U |

| 64 Bit Geekbench Single Core | 2861.00 | — | 3554.00 | 3626.00 | 3872.00 | 4108.00 |

| 64 Bit Geekbench Multi Core | 5320.00 | — | 6641.00 | 6789.00 | 7303.00 | 7798 |

| 64 Bit Cinebench R11.5 Single Core | 1.11 | — | 1.32 | 1.47 | 1.46 | 1.66 |

| 64 Bit Cinebench R11.5 Multi Core | 2.75 | — | 3.20 | 3.67 | 3.52 | 3.78 |

| 64 Bit Cinebench R15 Single Core | 97.00 | 90.00 | 115.00 | 128.00 | 128.00 | 144.00 |

| 64 Bit Cinebench R15 Multi Core | 247.00 | 257.00 | 289.00 | 327.00 | 316.00 | 338.50 |

| 3DMark06 CPU | 3241.50 | — | 3787.00 | 4356.00 | 4231 | 4587 |

В данном случае абсолютные цифры не столь важны, а важнее тенденция изменения показателей при смене поколения процессора и его версии.

Производители

Кроме референсной модели GTX 980, обладающей стандартными параметрами, присутствуют версии видеокарты от других производителей. В таких графических чипах будет отличаться система охлаждения, элементы питания и заводской разгон. В большинстве случаев сторонние версии GTX 980 превосходят референсную, но это происходит не всегда.

Asus GeForce GTX 980 STRIX

Версия GTX 980, выпускаемая компанией Asus, выделяется кастомным охлаждением, умеющей отключать вентиляторы в периоды низкой загрузки, а также небольшим заводским разгоном. В целом Asus выпускает хорошие видеокарты и данный экземпляр не стал исключением.

Gigabyte GeForce GTX 980

Версия видеокарты от Gigabyte – настоящий монстр среди остальных GTX 980. Первое, что бросается в глаза, это монструозный радиатор с тремя внушительными кулерами, что обеспечивает превосходное охлаждение графическому чипу. Вторая важная особенность — внушительный заводской разгон, благодаря чему видеокарта приближается по производительности к GTX 980ti.

MSI GeForce GTX 980 Gaming

Серия Gaming, производимая компанией MSI, отличается неплохим заводским разгоном. Данный экземпляр не стал нарушать традиции, его частоты значительно выше, нежели у референсной модели. Не смотря на разгон, специалисты компании MSI не стали городить монструозную систему охлаждения, установив небольшой радиатор с двумя кулерами.

дрова под XP для nvidia geforce gt 630m

ЕСЛИ ВЫ НЕ ЗНАЕТЕ ГДЕ СКАЧАТЬ ДРАЙВЕРА НА ВАШ КОМПЬЮТЕР ИЛИ НОУТБУК!!! 1.для начала откройте диспечер устройств и посмотрите каких драйверов нехватает. 2.Вместе с компом и ноутбуком должен всегда продоватся диск с драйверами НИКОГДА ПО ВОЗМОЖНОСТИ НЕ устанавливайте с него, т.к. они устаревают, и некоторые программы, особенно игры, особенно, если это видео дрова, могут некорректно показывать картинку. 3.если диска нет то помощь В ТОМ, КАК ПОСТАВИТЬ НЕВЕДОМУЮ ХЕРНЮ, ОСОБЕННО КАСАЕТСЯ НОУТБУКОВ, окажет вот эта программа DriverPack Solution — программа для установки и обновления драйверов сама ищет обновляет и устанавливат драйвера на любой компьютер и ноутбук. Вот видеоурок как пользоватся этой программой как качать все драйвера с интернета через торрент. НИКОГДА НЕ ПОЛЬЗУЙТЕСЬ ПОДОБНЫМ СОФТОМ! 4.ВСЕ драйвера СЛЕДУЕТ ИСКАТЬ ТОЛЬКО на сайтах производителя вашей апаратуры. ТАМ ВСЕ БЕСПЛАТНО, БЕЗ ВИРУСОВ И СМС. ДЛЯ НОУТБУКОВ ДРАЙВЕРА СЛЕДУЕТ КАЧАТЬ ТОЛЬКО С САЙТА ПРОИЗВОДИТЕЛЯ НОУТБУКА, Т.К. В БОЛЬШИНСТВЕ СЛУЧАЕВ, ПРОИЗВОДИТЕЛИ НОУТБУКОВ ИЗМЕНЯЮТ ОРИГИНАЛЬНЫЕ ДРАЙВЕРА ПОД КОНКРЕТНУЮ МОДЕЛЬ. 5.помните что под каждую операционую систему нужны свои драйвера.

Технические характеристики видеокарты

Чтобы понять возможности видеокарты от Nvidia, необходимо изучить основные характеристики GTX 550 Ti:

- Имеет мощное графическое ядро GF116-400-A1.

- Имеет 192 шейдерных процесса.

- Поддерживает системы DirectX 11 (Shader Model 5.0) и OpenGL 4.1.

- Обладает возможностью работы с фирменными технологиями: SLI, CUDA, PureVideo HD, PhysX, 3D Vision.

- Процессор работает на 900 МГц, а шейдерный блок – на 1800 МГц.

- Память работает на 1025 МГц, в пиковых режимах она может увеличиться до 4100 МГц.

- Карта оснащена памятью типа GDDR5 объемом 1024 МБ.

- Битность шины составляет 192.

- Имеет обычный стандарт для подключения – PCI-E1 х16.

- Поддерживает 2560 х 1600 dpi в режиме Dual-link DVI, 1920х1080 dpi в режиме HDMI, 2048 х 1536 dpi в режиме VGA.

- Оснащена 3-мя типами интерфейсов: 1 xDVI-I, VGA и HDMI. Поддерживает форматы MPEG-2, MPEG-4, DivX, WMV9, VC-1 и H.264/AVC, есть HDCP.

- Для стабильного питания карты требуется блок питания мощностью не менее 400 Вт.

Характеристики Nv >Обзор GTX 550 Ti

Рабочая температура видеокарты Nvidia GTX 550 Ti при максимальной нагрузке составляет 79 градусов. Данные были сняты при помощи утилиты FurMark.

Если при стресс-тесте температура все же поднимается выше 90 градусов, для ее понижения можно выполнить следующие манипуляции:

- увеличить обороты кулера;

- улучшить продуваемость корпуса;

- поменять термопасту;

- установить дополнительную систему охлаждения.

Рекомендуется также скачать специальную программу RivaTuner, которая разработана для настройки и разгона видеокарт.

Какой блок питания нужен для GTX 550 Ti

Для стабильной и бесперебойной работы адаптера требуется блок питания мощностью не менее 400 Вт, потому что у самой карты GTX 550 Ti энергопотребление составляет почти 115 Вт, что весьма существенно для видеокарт такого уровня.

Тестирование

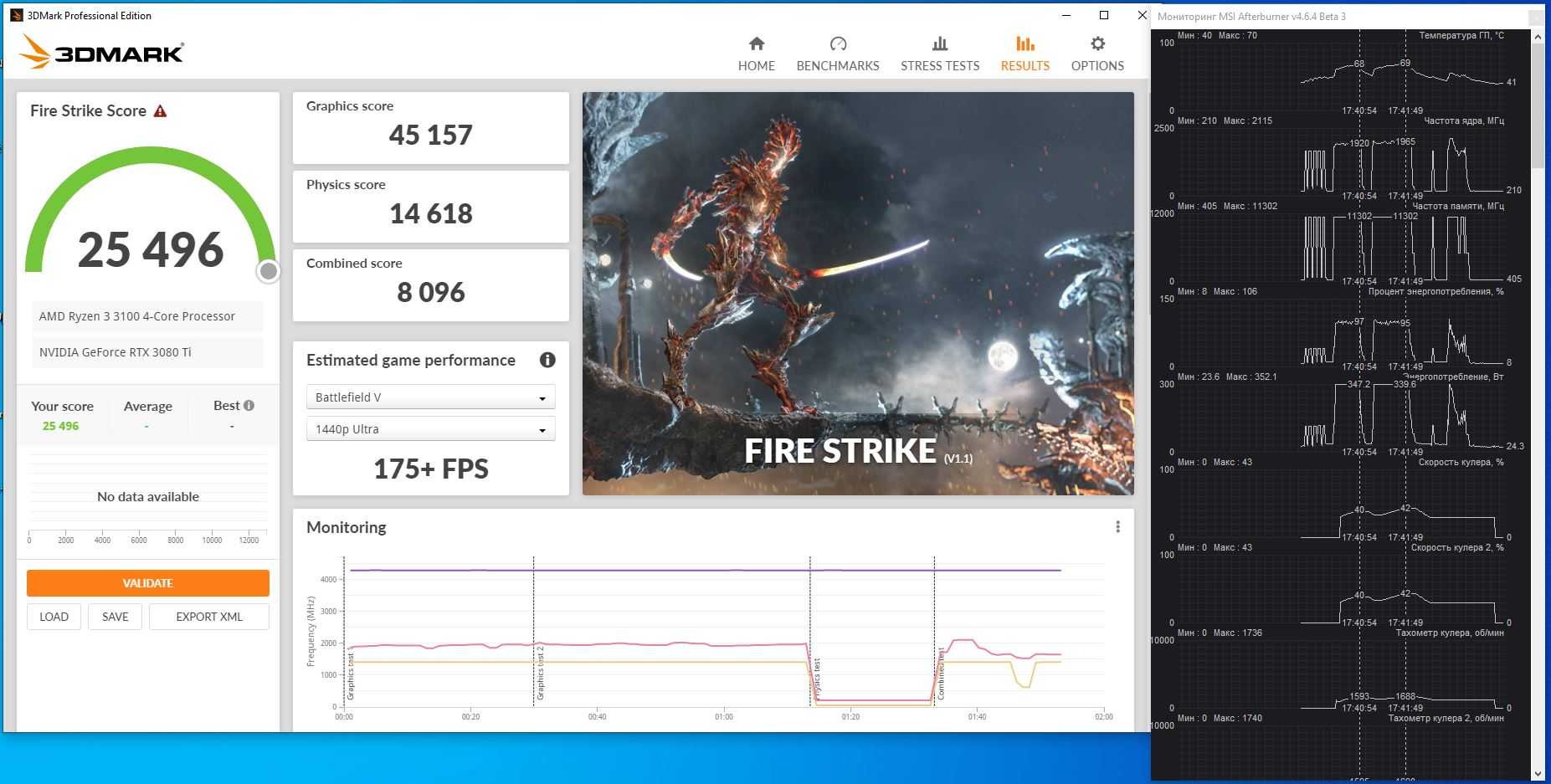

Для GeForce RTX 3080 Ti NVIDIA установила рекомендованные частоты работы 1365-1665 МГц и уровень TDP 350 Вт, и это очень странно. Странно на фоне того, что у RTX 3090 лимит мощности такой же, а у GPU активно больше блоков, частоты больше (да, всего на 30 МГц, но по факту) и плюс чипов видеопамяти вдвое больше. По фундаментальному закону сохранения энергии мощность не может уйти в никуда, и тут либо NVIDIA для RTX 3080 Ti отбирает чипы ужасающего качества с плохим КПД, либо реальные частоты RTX 3080 Ti будут существенно выше.

К нам на Тест’О’дром заехала версия без заводского разгона, функционирующая при стоковых частотах с стоковым 350-ваттным лимитом мощности. К удивлению, OC-версии RTX 3080 Ti GamingPro вообще не существует, хотя в ассортименте есть разогнанные RTX 3090 и RTX 3080 GamingPro, а также разогнанные RTX 3080 Ti в исполнении GameRock.

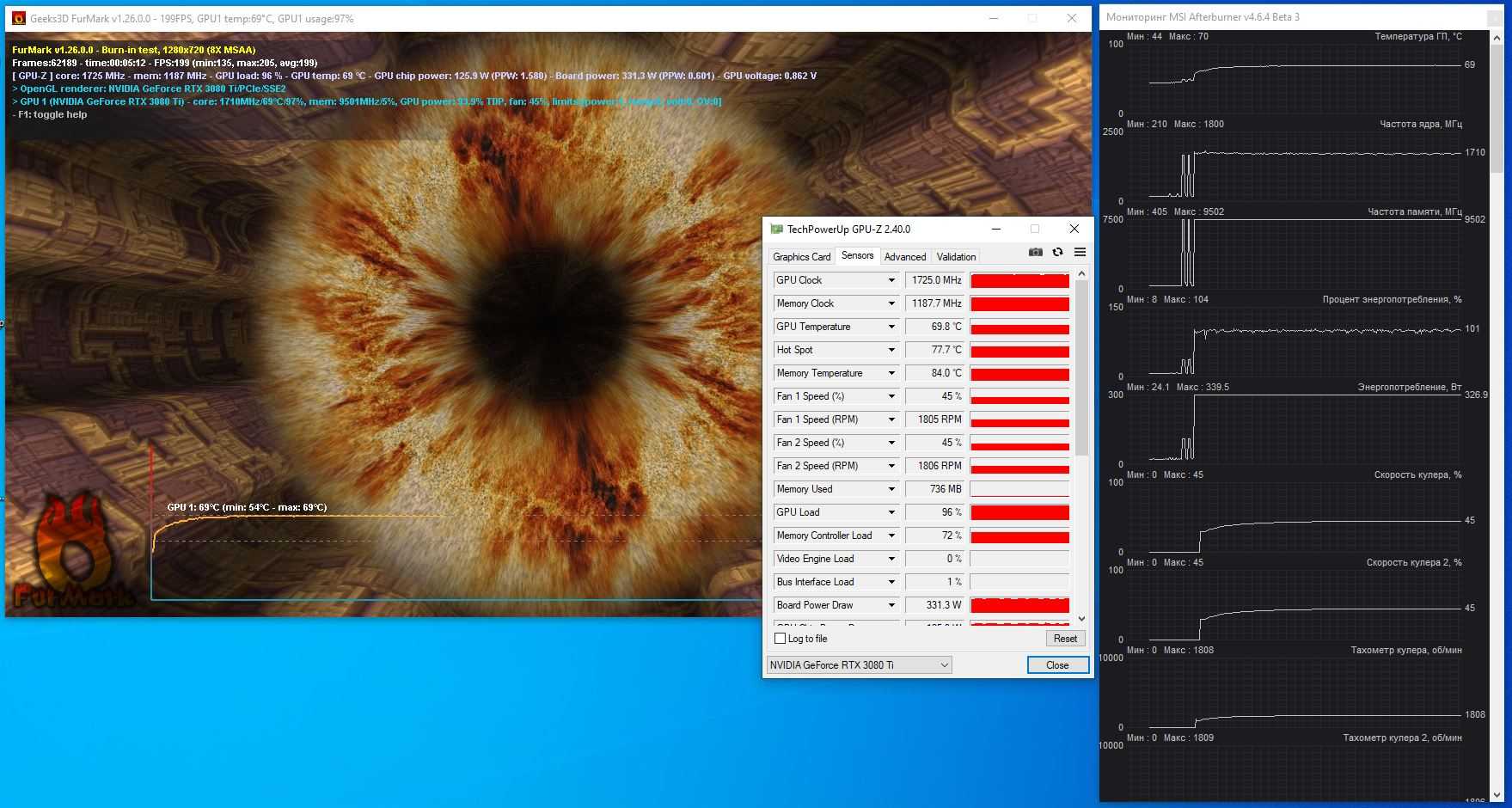

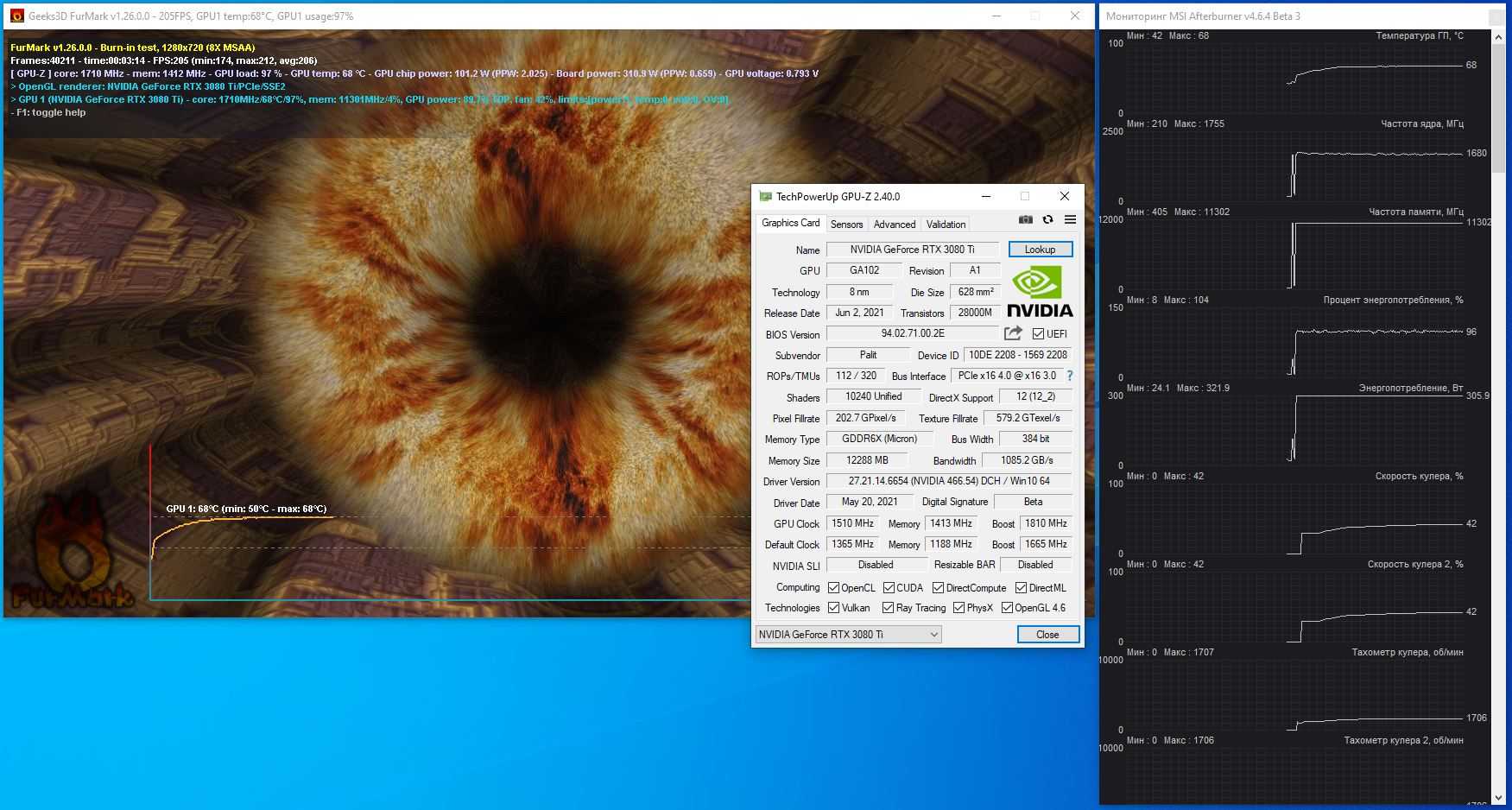

Как обычно начинаем с полного стока и изучения работы системы охлаждения, и сразу же скажу, что я сильно удивлён. Я ожидал температурных показателей печальных – около или чуть меньше уровня RTX 3090, но получилось иначе. При стрессовой нагрузке в FurMark ядро как максимум прогрелось до 70 градусов, при этом потенциал системы охлаждения был задействован всего на 45% (около 1800 об/мин) – просто изумительный показатель! Память прогрелась до 84 градусов (для GDDR6X плохо, когда 100+ °C). Частота GPU постоянно колебалась в пределах 1710-1725 МГц.

Жаль, что нет температурного датчика на VRM-узле. Как Palit вообще это сделала? Там же прямо в DrMOS-сборки датчик встроен. Скорее всего он по факту есть, но его показания нельзя посмотреть «народными» утилитами. Со снятым бэкплейтом в самой горячей точке мы намеряли 82 градуса пирометром.

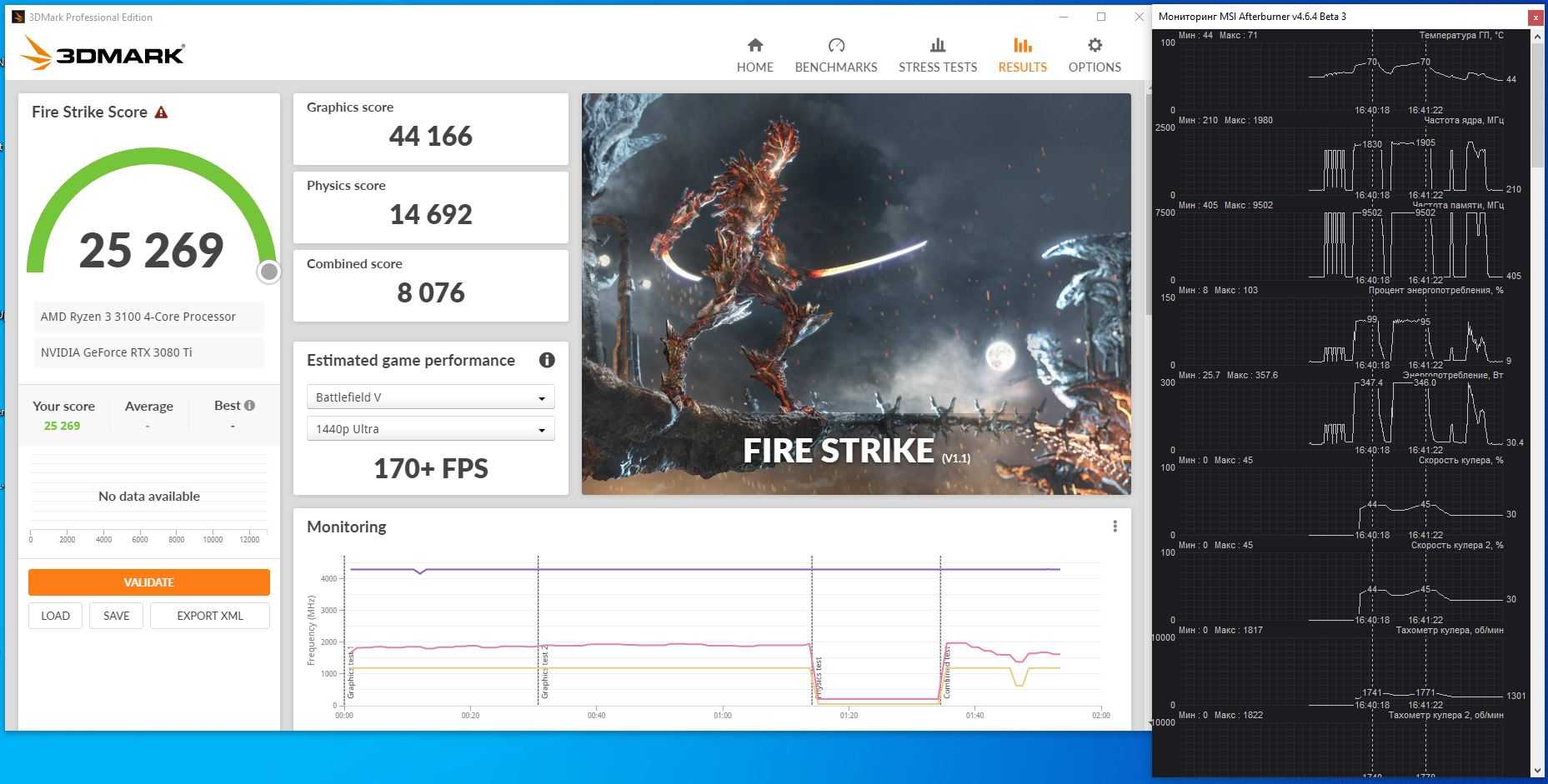

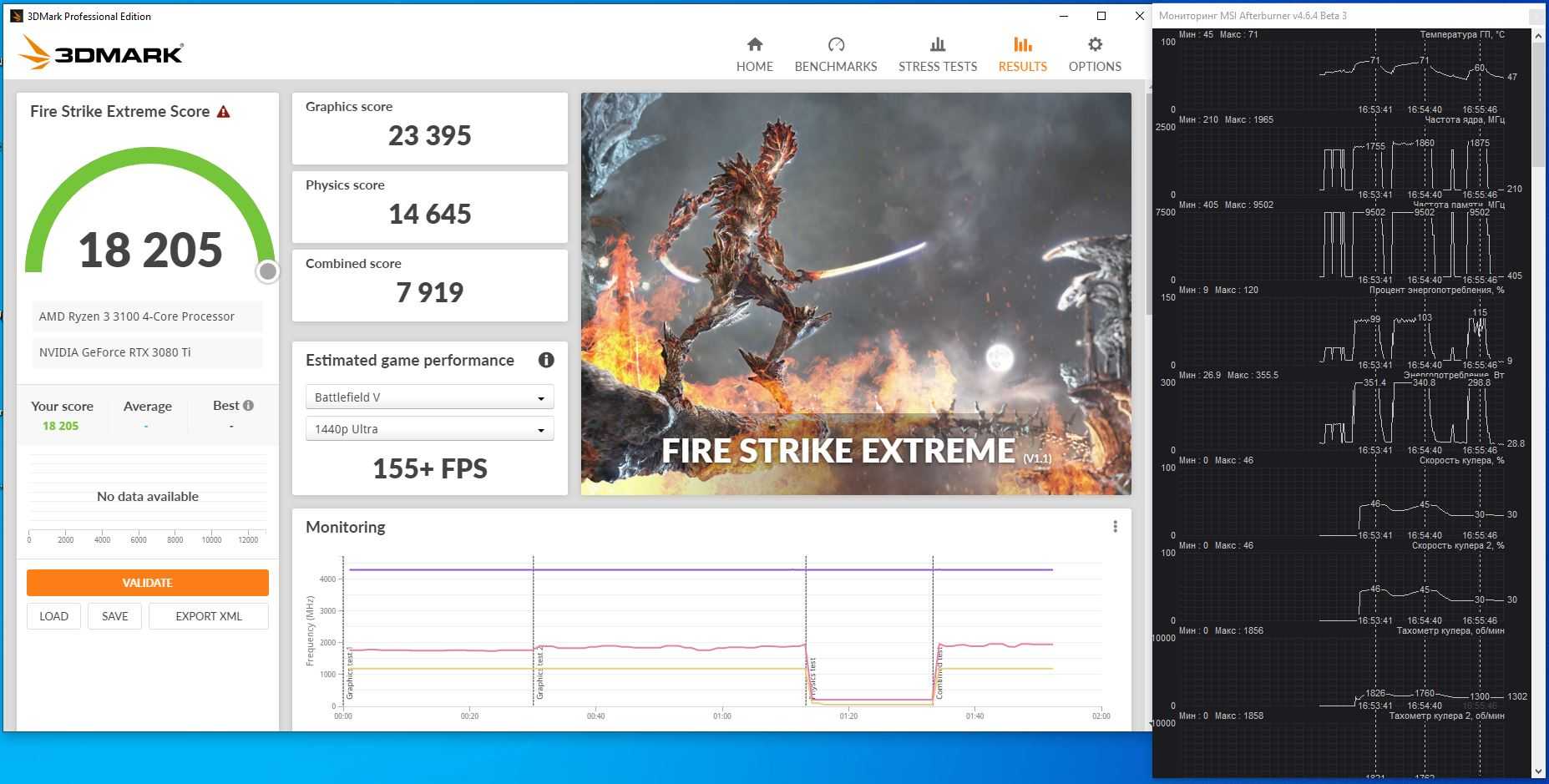

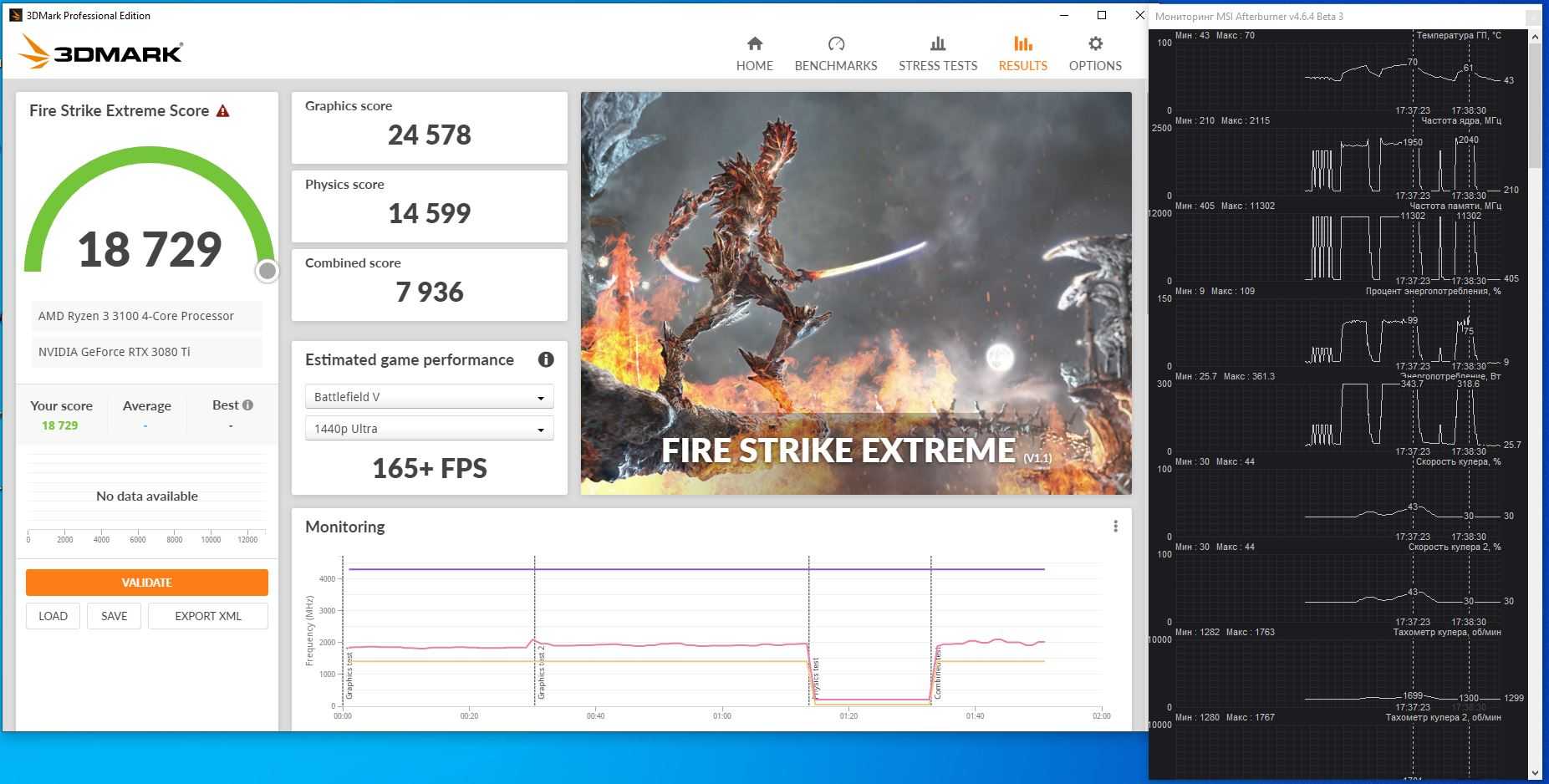

В имитирующих игровую нагрузку 3DMark Fire Strike и Fire Strike Extreme температурные показатели были аналогичны, как в общем-то и обороты пропеллеров. Частоты «простреливали» до 1965-1980 МГц, но зачастую держались на отметке около 1900 МГц. По оценке графики карта набрала 44 166 баллов в обычной и 23 395 в Extreme-версии.

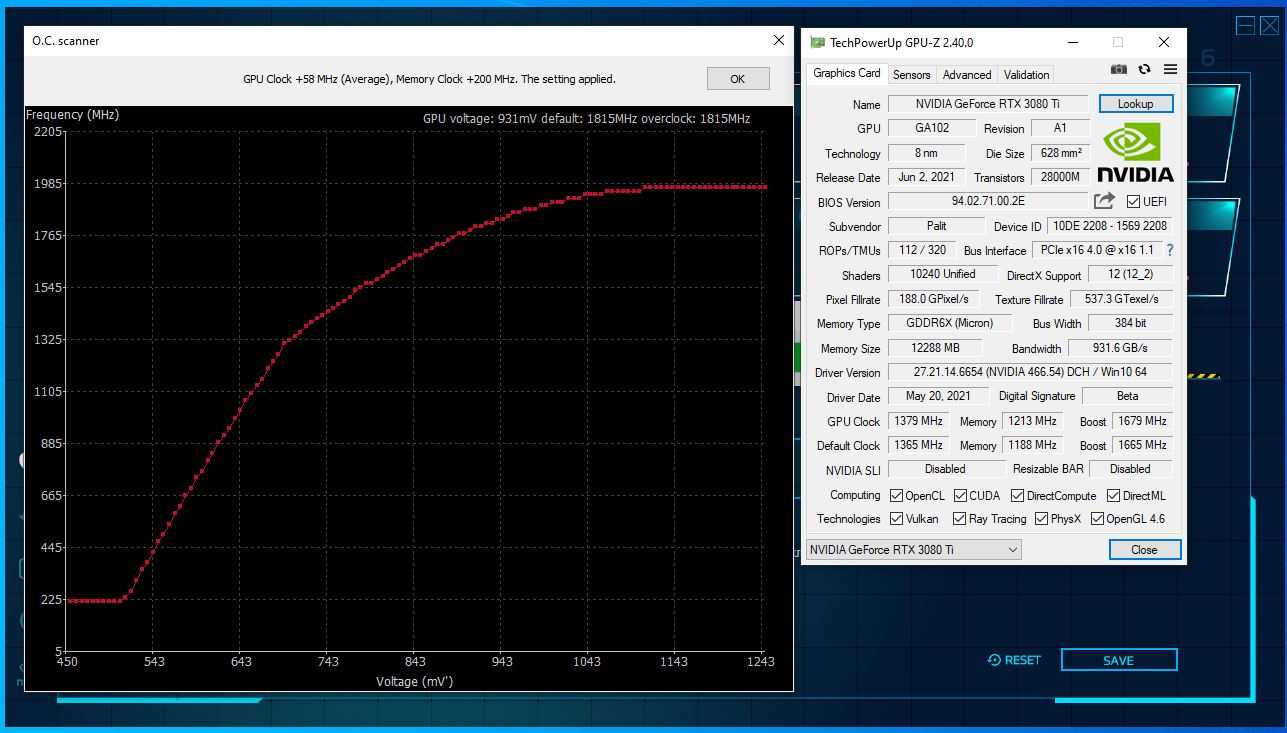

Изучение разгонного потенциала и работы охлаждения в более суровых условиях стартует с OC Scanner – инструмента для автоматического определения наличия дополнительных мегагерц. С недавних пор он научился ещё и пытаться (слово подходящее) разгонять видеопамять.

Впечатляющим прирост не назвать. +48 МГц по ядру и жалкие 400 МГц (стало 19,4 ГГц GDDR6X-эффективных). Такой уж он OC Scanner – ближайший родственник «Средства устранения неполадок Windows».

В ручном режиме пошло намного веселее. Номинальная частота графического процессора выросла на 145 МГц, а частота памяти… вот тут я натурально оху был обескуражен. До этого у нас на обзоре побывали несколько RTX 3080 и RTX 3090, и все они толкались +- на 20-21 ГГц. То ли дело в RTX 3080 Ti, то ли нам попался небывало удачный образец, но с 19 ГГц память ушла на 22,6 ГГц.

Вместе с тем общая пропускная способность памяти выросла с 912 ГБ/с до 1085 ГБ/с – абсолютно рекордный показатель среди игровых/околоигровых видеокарт. Это даже больше, чем у Radeon VII (1024 ГБ/с).

Что правда, на производительности это сказалось по-разному. Результат в Fire Strike вырос с 44 166 до 45 157 баллов (+2%), а в Fire Strike Extreme – с 23 395 до 24 578 (+5%). Дело в том, что изначальная пропускная способность памяти и без того с огромным запасом, упор идёт в графический процессор. Конечно, разгон памяти свою лепту внёс, но львиная доля прироста – это заслуга GPU.

Добавочные частоты абсолютно не сказались на поведении системы охлаждения. Те же около 70 °C при около 45% оборотов «карлсонов».

Остаётся лишь добавить, что писк дросселей и какие-либо другие посторонние шумы от Palit GeForce RTX 3080 Ti GamingPro полностью отсутствуют.

Разгон

Перед началом процедуры разгона необходимо установить драйвера последней версии, которые доступны на официальном сайте производителя. Для проверки параметров используется утилита GPU Z (применяется для оценки ASIC Quality). Увеличение частоты работы микропроцессора производится путем регулирования напряжения питания, для проверки работоспособности используются игровые приложения. Проведенные тесты показали, что наращивание частоты микропроцессора и памяти позволяет увеличить производительность адаптера на 12-15%.

MSI N650 PE 1GD5 OC

MSI N650 PE 1GD5 OC

Пиковая частота зависит от производителя карты, который отбирал микропроцессоры по характеристикам. Например, изделия от компании Asus способны устойчиво работать при частоте до 1333 МГц, при этом адаптер MSI N650 PE 1GD5/OC невозможно разогнать выше 1240 МГц (из-за появления артефактов на дисплее и нарушения стабильности работы). Увеличение тактовой частоты памяти затруднительно из-за особенностей системы питания, максимальная частота не превышает 6,21 ГГц.

Тесты в играх

Для тестирования возможностей карт GeForce GTX 650 в играх применялся стенд на базе процессора Intel Core i7-3960X. В конструкции компьютера использовалось 8 Гб оперативной памяти и жесткие диски Barra Cuda 7200 14 3 Тб и WD Caviar Blue WD10EZEX 1 Тб. Станция работала под управлением 64-битной операционной системы Windows 7 с DirectX 11. Использовались комплекты Drivers для AMD Catalyst 12.11beta и nVidia версии 306.97. Обзор сводных результатов представлен в виде таблицы.

650

Metro 2033 13.3 fps

Aliens vs Predator 3 8.5 fps

Battlefield III 20.5 fps

The Witcher 2: Assassins of Kings 25.4 fps

Sniper Elite V2 9.0 fps

Metro 2033 (год выпуска — 2010) при разрешении 1080р и включенном сглаживании запускается с частотой 13,3 FPS, недостаточной для игрового процесса. Аналогичная картина наблюдается и в приложении Aliens vs Predator 3 (2010 г.). Достаточной производительностью из рассматриваемых адаптеров обладает только изделие на основе GTX 680. Игра Battlefield III (2011 г.) отличается пониженными требованиями к графике и адаптирована для карт производства nVidia, что позволяет довести частоту смены кадров на 650 чипе до 20,5 кадров в секунду.

Приложение The Witcher 2: Assassins of Kings (вышло в 2011 г.) может пойти с частотой 25,4 кадра в секунду, что в 3,5 раза ниже, чем при использовании видеокарты на базе GTX 680. Игра Sniper Elite V2 (разработка 2012 г.) запускается на 650 микропроцессоре в виде последовательности кадров (9 FPS). Конкуренты от AMD показывают сопоставимые результаты.

Потенциал архитектуры Kepler позволил разработчикам компании NVidia создать серию вычислительных систем Tesla (объем памяти — до 12 Гб). Но появление новых конструктивных решений и выход улучшенных игровых приложений привели к устареванию оборудования — уже в начале 2014 г. свет увидели графические карты на основе чипов поколения Maxwell. При запуске игровых приложений, разработанных после 2012 г., необходимо снижать настройки и разрешение до минимума, что ухудшает качество изображения.

Если владелец использует компьютер с видеокартой на базе стандартного чипа 650 серии, то оборудование подойдет для решения офисных задач или просмотра фильмов. При необходимости станция может использоваться и для запуска игровых приложений. В этом случае владельцу необходимо знать, какие игры пойдут на адаптере без критической потери качества графики и заморозки изображения. По отзывам пользователей, без нареканий запускаются приложения Euro Truck Simulator 2 и SIMS 3 (2012 и 2009 гг.).

Упаковка, комплектация

Palit GeForce RTX 3080 Ti GamingPro поставляется в стандартной Palit-овской коробке последних лет. Несмотря на впечатляющий рост качества продукции Palit в последнюю пятилетку, их коробкам по-прежнему не достаёт индивидуальности и фирменного стиля что ли. Вместо описания собственных «фишек» и того, почему именно их видеокарты лучше каких-то других, компания перечисляет фирменные технологии NVIDIA. При этом GamingPro – исполнение не самое простецкое, где есть, про что рассказать.

С другой стороны, покупающий видеокарту за $1200 рекомендованных с большой вероятностью и так знает, что покупает.

С 3000-ой серией видеокарт Palit перестала на коробке давать рекомендации по мощности блока питания, но они приведены на официальной странице. Вполне ожидаемого на фоне идентичного с RTX 3090 350-ваттного TDP, к RTX 3080 Ti также рекомендуется блок мощностью 750 ватт. Указано с перестраховкой на спать поспокойнее, так-то и качественного 650-ваттника хватит за глаза.

Устройство коробки максимально стандартное: внешне цветастая оболочка из тонкого картона, внутри ещё одна коробка из толстого картона, внутри которой видеокарта уложена в мягкую форму и антистатический пакет.

В комплекте поставки нет драйвера на диске – здравое решение, учитывая отсутствие DVD-привода в современных ПК и того факта, что версия драйвера успевает устареть ещё до записи на диск.

Из интересного есть календарик, переходник питания с двух PCI-E Power 6-pin на один 8-контактный (так и вижу, как есть на видеокарту за очень много, но нет на блок питания за хотя бы $60) и SAG Holder – кронштейн-поддержка для видеокарты. Многие современные корпуса предусматривают подпорку, но далеко не всё. А вещь совсем не лишняя! С учётом длины адаптера под 300 мм, немаленькой массы под полтора кило и постоянного воздействия температуры, появление изгиба без подпорки – лишь дело времени, пусть Palit и постарались предать конструкции максимальную жёсткость, про что уже в следующем разделе.

К сожалению, к моделям серии GamingPro в комплекте не полагается кабель, позволяющий синхронизировать подсветку видеокарты с материнской платой. Подсветка у Palit GeForce RTX 3080 Ti GamingPro в целом есть, но синхронизация остаётся прерогативой более «богатых» исполнений JetStream и GameRock.

За что приходится платить

Сравнение процессоров даже на основании приведенных результатов тестов позволяет заметить, что разница между i3 и i5 больше, чем между i5 и i7. Это не есть откровение, и результат вполне ожидаем, учитывая, что i3 лишен режима «Turbo Boost». Напомню, это технология, автоматически увеличивающая частоту работы процессора под нагрузкой.

В то же время разница между i7 и i5 сводится к большей (у i7) на 200 МГц базовой частоте, увеличенному на 1 МБ объему кэша и чуть большей (на 50 МГц) частоте видеокарты. При этом, если между i3 и i5 разница в производительности варьируется в пределах 10-20% в пользу i5, то при сравнении i5 и i7 эта разница не превышает 10%, а в большинстве случаев эти CPU отличаются всего на несколько процентов.

И вот тут появляется еще одно отличие – цена. Сравнение процессоров, предназначенных для установки в ноутбук, напрямую довольно затруднено, т. к. мы получаем их уже в составе компьютера. Значит, придется обратиться к конкретным моделям ноутбуков (а я люблю конкретику), чтобы посмотреть, сколько придется заплатить за тот или иной CPU при условии, что все остальные характеристики совпадают.

Итак. Ноутбук ASUS K501UW в модификации DM026T имеет Core i5 6200U, а в модификации DM014T — Core i7 6500U при всех прочих равных характеристиках. Разница в цене составляет примерно 5000 руб.

Lenovo IdeaPad 300-15 (в модификации 80Q701JERK) имеет «на борту» Core i3 6100U, а Lenovo IdeaPad 300-15 (модификация 80Q701JSRK) – Core i5 6200U, при идентичных всех остальных параметрах. Разница в цене составляет примерно те же 5000 руб.

При этом, если увеличение стоимости (примерно на 5000 руб.) при переходе от i3 к i5 хоть как-то может быть объяснена (хотя бы наличием Turbo Boost) за счет пусть и не радикальной, но заметной разницы в производительности, то те же 5000 руб. за несколько процентов быстродействия между i5 и i7 кроме как маркетинговыми уловками объяснить довольно сложно.

Отсюда возникает вопрос, а так ли надо переплачивать за i7 в версии «U»? Насколько оправдана разница в цене? На мой взгляд, не очень оправдана, мягко говоря. Эти деньги вполне можно сэкономить.

Если все же бюджет покупки «надо освоить», то не лучше ли пустить эту сумму на видеокарту повыше классом, экран разрешением побольше или выполненный по технологии IPS, а не TN, или на SSD в дополнение к обычному винчестеру? Система, запускающаяся с твердотельного диска, гораздо заметнее добавит «прыти» ноутбуку, чем дополнительные 200 МГц тактовой частоты процессора при замене i5 на i7.

Если же каждый мегагерц на счету, есть надобность в оцифровке видео, в работе с «тяжелыми» программами или играми, то речь о процессорах версии «U» вообще не должна идти

Не лучше обратить внимание на модели ноутбуков с полноценными, не урезанными «камнями» версии «HQ»? Например, ноутбуки Acer Aspire F5-573G-77VW с 8 ГБ памяти, процессором Core i7 6500U, GeForce GTX 950M 4096 МБ и Acer Aspire V5-591G-59Y9, у которого Core i5 6300HQ, 12 ГБ памяти(!), 8 Гб SSD (!!) при той же видеокарте стоят практически одинаково (разница в пару сотен рублей) при том, что во втором и памяти больше, и кэширующий SSD есть и процессор 4-ядерный