Температура и разгон

Для разгона использовалась утилита MSI Afterburner, разгон осуществлялся с поднятием напряжения:

- Частоту GPU удалось повысить на 190 МГц, что в итоговом варианте составило 1304 МГц. При этом значение динамической частоты достигло показателя 1443 МГц.

- Частота памяти была увеличена на 465 МГц и значение составило 1985 МГц (7.94 ГГц QDR).

Несмотря на заводской разгон графического ядра на 64 МГц, в ходе ручного изменения параметров удалось достичь гораздо более впечатляющих результатов. Столь значимое повышение частоты GPU и MEM окажет заметное влияние на уровень производительности.

Тестирование происходило в открытом корпусе при комнатной температуре в 26 градусов. В режиме бездействия частота GPU и памяти снижается до 135/324 МГц, это напрямую влияет на энергоэффективность и улучшает температурные показатели.

Система охлаждения отлично справляется со своей прямой задачей и даже под нагрузкой температура не выходит за 62 градуса, это просто великолепный показатель даже с учетом невысокого потребления чипа.

Скорость вентилятора варьируется в зависимости от загруженности видеокарты (от 1529 до 1927 об/мин.). Несмотря на кажущиеся высокие значения тахометра, вентиляторы работают очень тихо и в простое и под нагрузкой. В данном случае нет никакого компромисса, низкая температура под нагрузкой и при этом тихая работа системы охлаждения вызывает лишь положительные эмоции.

Обзор GTX 260

Внешний вид графического адаптера, независимо от его производителя, остаётся впечатляющим, напоминая современные карты. Среди возможностей карты отмечают:

- поддержку технологий PhysX для получения игровых эффектов, универсальных вычислений CUDA, DirectX и OpenCL, благодаря которым карта подходит и для кодирования или монтажа видео;

- возможность объединения с 1 или 2 такими же адаптерами при их установке на специальной SLI-совместимой материнской плате;

определённый запас прочности для работы с 3D-изображениями при наличии совместимого монитора.

К минусам относят и энергопотребление GTX 260, достигающее 182 Вт – из-за него система охлаждения видеоадаптера работает довольно шумно, а для нормальной работы понадобится мощный блок питания.

Ещё один серьёзный недостаток – отсутствие поддержки DirectX 11, из-за чего некоторые новые игры могут просто не запуститься, даже если карта будет соответствовать их минимальным требованиям.

Как повысить производительность видеокарты NVIDIA в играх // ускорение NVIDIA (GeForce)!

Можно ли как-то повысить производительность видеокарты NVIDIA (GeForce), то бишь увеличить FPS? Видеокарта у меня уже довольно старая, а запустить парочку игр — желание не преодолимое .

99% вопросов по поводу производительности видеокарты задают любители игр. Именно в играх, если видеокарта устарела и не тянет, вы начнете замечать притормаживания, картинка дергается, идет рывками, и играть становится очень не комфортно.

Чтобы увеличить количество FPS (это кол-во кадров в секунду, чем выше этот параметр — тем лучше!), выдаваемое видеокартой, можно прибегнуть к разным способам: разогнать видеокарту, уменьшить качество графики в настройках игры, задать оптимальные параметры драйвера видеокарты (с прицелом на производительность ). Вот о тонкой настройки видеокарты, я и напишу пару строк в этой статье.

Как обновить драйвера NVIDIA GeForce GTX 260

Необходимость скачать драйвера для NVIDIA GeForce GTX 260 может появиться при появлении проблем с уже установленным программным обеспечением на компьютере. Придётся заняться поиском управляющих программ для видеокарты и при переустановке Windows (или другой поддерживаемой операционной системы).

Для скачивания драйвера рекомендуется воспользоваться официальным сайтом компании NVIDIA. Здесь на одной из страниц можно скачать утилиту GeForce Experience, позволяющую не только оптимизировать работу карты, но и улучшить её функциональность в играх.

Для Windows 10

290.00 МБВерсия драйвера: 342.01 (WHQL) от 14.12.2016;Язык: РусскийОперационная система: Windows 10 32/64-bit, Windows 7 32/64-bit, Windows 8.1 32/64-bit, Windows 8 32/64-bit, Windows Vista

Не стоит делать это с помощью специальных программ или из ненадёжных источников из-за риска установки устаревшего драйвера, а также из-за возможности заражения компьютера вирусом.

Дальнейшее развитие параллельного соединения GPU

С выходом нового поколения видеокарт GeForce RTX, NVIDIA анонсировала и новый интерфейс (мост) NVLink для соединения двух графических процессоров для совместной работы. Соединяются они при помощи NVLink Bridge. Скорость передачи данных по новому интерфейсу по сравнению со SLI выросла в 10 раз. С 10 Гбайт/с до 100 Гбайт/с. NVLink поддерживают только GeForce RTX 2080 и RTX 2080 Ti, модели 2070 и 2060 его лишены.

Судя по моему анализу различных игровых тестов, проведенных с двумя видеокартами последних поколений (2080Ti), новый интерфейс практически во всех современных играх в разрешении 8k (7680 × 4320 точек) дает минимум 40% прирост производительности по сравнению с работай SLI режима на двух 1080Ti. Ниже на изображении я привел результаты одного из таких тестов.

Мониторы 8k сейчас еще очень дороги и практическая польза такого теста минимальна, но он хорошо показывает перспективы возможного увеличения применения двух видеокарт в недалеком будущем.

Стоит обратить внимание на результаты тестирования двух RTX 2080. Они значительно хуже его старшего собрата

В игре Rise of the Tomb Raider две 2080Ti в 8k выдают 50fps, а 2080 только 37fps. Это сильное падение производительности. Не думаю, что это связано с недостатком видеопамяти.

Скорее всего, драйвера для распараллеливания графических данных лучше оптимизированы под 2080Ti, так как по своим характеристикам она близка к профессиональным решениям NVIDIA для параллельных вычислений, под которые изначально и разрабатывался новый интерфейс. Более поздние версии драйверов я надеюсь доведут до ума и они будут оптимизированы значительно лучше.

В будущем нам придется очень грамотно планировать покупку компьютера. Если разница в потреблении энергии между 2-мя и 4-мя планками оперативной памяти не значительна, то при установке 2 видеокарт или более нам необходимо будет учитывать их суммарную потребляемую мощность.

На материнской плате должны быть слоты для установки двух видеокарт и с обязательной поддержкой их совместной работы. Чтобы узнать, поддерживает ли материнская плата две видеокарты, перейдите на официальную страницу производителя системной платы и проверьте спецификации. Так же это можно определить по наличию на коробке логотипа Crossfire, SLI или NVLink.

Блок питания также должен обладать достаточной мощностью, чтобы тянуть все железо компа+2 видеокарты. Сейчас для этого необходимо около 900 Вт.

При использовании двух видеокарт, игры становятся процессорозависимыми. Чем выше разрешение вы используете и чем больше даете нагрузку на видеокарту(ы), тем меньше это проявляется. При уменьшении разрешения монитора и уменьшении нагрузки на видеокарт(у)ы, этот эффект уменьшается до его полного исчезновения, так как узким местом становиться видяха, а не центральный процессор.

Для работы с двумя топовыми видеокартами, вам придется раскошелиться и на максимально мощный процессор, иначе все это не имеет смысла.

Должно быть организовано качественное охлаждение всех ваших комплектующих системного блока, так как тепловыделение очень высокое.

Связывайте NVLink только видеокарты выполненные на однотипном графическом процессоре. Производитель не важен, но важна частота работы GPU, так как при объединении обе видяхи будут работать на меньшей частоте. Например у нас одна карточка, которая имеет рабочую частоту 1695 Мгц, а другая 1770 Mгц, то в совместном режиме они обе будут работать на 1695 Мгц. Блин, все точно как у оперативной памяти.

Пара графических карт требует компьютерного корпуса, вместимости которого будет достаточно для установки их и дополнительного оборудования.

В панели управления драйвером графического процессора, должна быть включена функция NVLink, SLI или Crossfire.

Немного истории

Началом эры SLI можно считать 1998 год. Тогда компания 3dfx впервые сумела реализовать возможность объединения нескольких видеокарт для решения одной задачи. Однако развитие интерфейса AGP затормозило разработки в этом направлении, так как все материнские платы того времени оснащались только одним слотом для видеоплаты.

SLI от 3DFX — «дедушка» современной технологии

После того, как в 2001 году 3dfx были куплены компанией Nvidia, все разработки в этом направлении ожидали своего часа, который наступил только в 2004 году. Именно тогда, в 6000-й серии GeForce (первые видеокарты, разработанные специально под новейший на то время интерфейс PCI-Express) имеющиеся разработки были усовершенствованы и внедрены в продукты массового потребления.

SLI из двух GeForce 6600GT

Сперва объединить можно было две видеокарты GeForce 6600 или 6800, с выходом 7000-й серии (в которой была представлена первая полноценная двухпроцессорная плата от Nvidia, 7900GX2) появилась возможность построения четырехпроцессорной конфигурации (из 2 карт), а позже стало возможным и сочетание 3 или 4 раздельных ГП.

Как подключить две видеокарты к одному ПК

Если вы собрали очень мощную игровую или рабочую систему и хотите сделать ее еще мощнее, то в этом поможет приобретение второй видеокарты. Кроме этого две модели из среднего ценового сегмента могут работать лучше и быстрее, чем одна топовая, при этом стоить в разы меньше

Но для того, чтобы сделать это, необходимо обратить внимание на несколько моментов. Давайте подробнее разберем их

Что нужно знать перед подключением двух GPU к одному ПК

Если вы только собираетесь приобретать второй графический адаптер и еще не знаете всех нюансов, которые требуется соблюдать, то мы их детально опишем.Таким образом, при сборе у вас не возникнет различных проблем и поломок комплектующих.

- Убедитесь в том, что ваш блок питания имеет достаточную мощность. Если на сайте производителя видеокарты написано, что она требует 150 Ватт, то для двух моделей потребуется уже 300 Ватт. Мы же рекомендуем брать БП с запасом мощности. Например, если сейчас имеете блок в 600 Ватт, а для функционирования карт необходим на 750, то не экономьте на этой покупке и купите блок на 1 киловатт, так вы будете уверены, что все будет работать корректно даже при максимальных нагрузках.

Вторым обязательным моментом является поддержка вашей материнской платой связки из двух графических адаптеров. То есть, на программном уровне она должна позволить работать двум картам одновременно. Практически все системные платы позволяют включить Crossfire, однако с SLI все сложнее. А для видеокарт NVIDIA нужно лицензирование самой компанией, чтобы материнская плата на программном уровне разрешила включение технологии SLI.

Ну и конечно, обязательно на материнской плате должны присутствовать два разъема PCI-E. Один из них должен быть шестнадцатилинейным, то есть PCI-E x16, а второй PCI-E x8. Когда 2 видеокарты вступят в связку, то они будут работать в режиме x8.

Видеокарты должны быть одинаковы, желательно, одной и той же компании. Стоит обратить внимание, что NVIDIA и AMD занимаются лишь разработкой GPU, а сами графические чипы делают другие компании. Кроме этого можно купить одну и ту же карту в разогнанном состоянии и в стоковом. Ни в коем случае нельзя смешивать, например, 1050TI и 1080TI, модели должны быть одинаковы. Ведь более мощная карта опустится до частот слабой, тем самым вы просто потеряете свои деньги, не получив при этом достаточный прирост производительности.

И последним критерием является наличие у вашей видеокарты разъема под мост SLI или Crossfire. Обратите внимание, если в комплекте с вашей материнской платой идет этот мост, то она 100% поддерживает данные технологии.

Мы рассмотрели все нюансы и критерии, связанные с установкой двух графических адаптеров в один компьютер, теперь давайте перейдем к самому процессу установки.

Подключение двух видеокарт к одному компьютеру

В подключении нет ничего сложного, от пользователя требуется только следовать инструкции и соблюдать осторожность, чтобы случайно не повредить комплектующие компьютера. Чтобы установить две видеокарты вам потребуется:

- Откройте боковую панель корпуса или положите материнскую плату на стол. Вставьте две карты в соответствующие разъемы PCI-e x16 и PCI-e x8. Проверьте надежность крепления и прикрутите их с помощью соответствующих винтов к корпусу.

Обязательно подключите питание двух карт с помощью соответствующих проводов.

Соедините два графических адаптера с помощью моста, который идет в комплекте с материнской платой. Осуществляется подключение через специальный разъем, упомянутый выше.

На этом установка окончена, осталось только собрать все в корпус, подключить блок питания и монитор. Осталось в самой Windows настроить все на программном уровне.

В случае с видеокартами NVIDIA перейдите в «Панель управления NVIDIA», откройте раздел «Configure SLI», установите точку напротив «Maximise 3D performance» и «Auto-Select» возле «Processor». Не забудьте применить настройки.

В программном обеспечении от AMD технология Crossfire включается автоматически, поэтому дополнительных действий выполнять не нужно.

Перед тем, как покупать две видеокарты, хорошо подумайте над тем, какие это будут модели, ведь даже топовая система не всегда способна вытянуть работу двух карт одновременно. Поэтому рекомендуем внимательно изучить характеристики процессора и оперативной памяти перед сборкой такой системы.

Довольно распространено мнение, что установка двух видеокарт на компьютер даёт возможность повысить производительность системы, сэкономив при этом средства . Однако не все и не всегда так однозначно.

Технические характеристики NVIDIA GeForce GTX 260

Получив от производителя не самые плохие на тот момент характеристики, GTX 260 позволяла использовать компьютер, на котором была установлена, в следующих целях:

- для запуска игр и других графических приложений, поддерживающих технологию DirectX 10.0 или OpenGL 2.1;

- для просмотра видео в формате FullHD через вход TV-Out;

- для передачи изображения в качестве 2048х1536 и 2560×1600 при подключении к мониторам через переходники на VGA и HDMI, соответственно (притом, что на карте располагались только DVI-I).

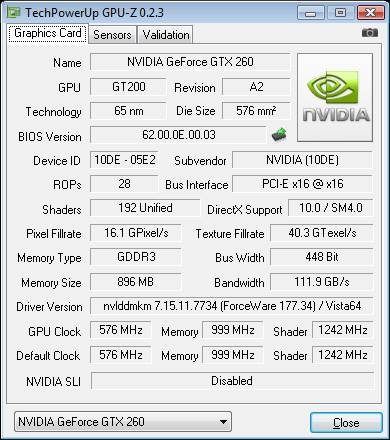

Наличие у карты 896 Mb видеопамяти GDDR3 и частоты 999 (1998) МГц не впечатляет даже на фоне конкурентов в 2008-м году. Однако разрядность шины в 448 бит сделала видеоадаптер более производительным, чем некоторые более современные, но офисные модели на 1 или 2 Гб типа GT 610 или GT 720. В тестах он соответствует параметрам интегрированной карты Intel HD 630.

Неплохие на момент выхода модели параметры привели к её высокой стоимости. Средняя цена GTX 260 на рынке начиналась с $400. Сейчас, через 10 лет, желающие приобрести графический адаптер могут сделать это с намного меньшими затратами. На вторичном рынке стоимость видеокарты NVIDIA GeForce GTX 260 в рублях начинается с полутора тысяч.

Как разогнать видеокарту NVIDIA GeForce GTX 260

Для повышения производительности графики можно выполнить разгон GTX 260, используя для этого утилиты типа FireStorm или RivaTuner. Пользуются для улучшения характеристик и специальным программным обеспечением от производителей (например, Zotac или Palit).

Принимая во внимание высокое энергопотребление и сравнительно невысокую скорость работы видеоадаптера, добывать с его помощью криптовалюту не стоит. Даже после разгона майнинг GTX 260 приносит прибыль, сравнимую с оплатой счетов за электричество

Поэтому майнинг-ферму из таких графических процессоров собирать не рекомендуется. Для этого лучше подойдут более современные версии с меньшим расходом электроэнергии и большим объёмом и частотой памяти.

Nvidia geforce gtx 260 разгон, научите как

Вобщем имеется данная видеокарта «Palit geforce gtx 260»Не могу разогнать.. посмотрел много видео, почитал мануалы, делаю все по инструкции но.. вот в чем проблема:

nvidia inspector — скачал, установил, поставил галочку «запуск от администратора», даже тыкаю правной кнопкой по ярлыку, там выбираю тоже меню запуск от админа.. вобщем вольтаж полоска серым цветом, и ползунок нельзя перемещать.. ну думаю ладно, меняю чистоты при нажатии кнопки «Apply» тобишь подтвердить настройки, они прыгают назад на стандартные значения. Опробовал несколько версий.. что могу сделать только поменять скорость вращения куллера.

MSI Afterburner — также скачал, установил, как на видео настроил мониторинг, и поставил галочку чтоб можно было менять вольтаж, но он тут опять же серым цветом и поменять его никак. при этом меняются и сохраняются значения Memory cloch и Shader clock, ну этого я так понимаю не достаточно.

источник

Как разогнать видеокарту NVIDIA GeForce GTX 260

Для повышения производительности графики можно выполнить разгон GTX 260, используя для этого утилиты типа FireStorm или RivaTuner. Пользуются для улучшения характеристик и специальным программным обеспечением от производителей (например, Zotac или Palit).

Принимая во внимание высокое энергопотребление и сравнительно невысокую скорость работы видеоадаптера, добывать с его помощью криптовалюту не стоит. Даже после разгона майнинг GTX 260 приносит прибыль, сравнимую с оплатой счетов за электричество

Поэтому майнинг-ферму из таких графических процессоров собирать не рекомендуется. Для этого лучше подойдут более современные версии с меньшим расходом электроэнергии и большим объёмом и частотой памяти.

Выводы и умозаключения

С выходом NVLink, технологию CrossFire от AMD можно смело хоронить. Она и так была хуже по реализации, чем SLI, а теперь вообще не конкурент. AMD срочно нужно что-то новое придумать, так как технологии совместной работы двух и более видеокарт станут намного производительнее, что повлечет за собой их распространение. Это станет еще одним конкурентным преимуществом.

Я думаю, что параллельная работа двух и более видеокарт будет похожа по развитию на многоядерные процессоры. Технологические процессы изготовления чипов уже настолько малы, что выпускать более сложные микросхемы становиться дорого.

Сделать многоядерным графический процессор скорее всего не получиться, так как он намного сложнее центрального. Да и с отводом тепла что-то придумывать придется. Проще отладить технологию параллельных вычислений и завести ее качественную поддержку во все игры, а не как сейчас. С выходом следующего поколения видеокарт, будет реально видно, куда будет идти развитие.

На момент написания статьи положение дел такое, что устанавливать в компьютер две видеокарты имеет смысл только если у вас разрешение монитора 4k и более. Только тогда вы получите прирост скорости в играх. Для меньших разрешений целесообразно купить одну хорошую видеокарту.

В общем пока использование двух видеокарт в компьютере остается уделом богатеньких буратино, и таким останется ближайшие 2-3 года. При примерном подсчете, стоимость игровой системы с двумя современными топовыми видеокартами ушла за 300 тысяч вместе с монитором на 8k? и чуть дешевле на 4k.

Более приземленных пользователей хочу обрадовать, что сильно расстраиваться пока не о чем, так как на самые ходовые разрешения и мониторы одной среднего уровня видеокарты пока более чем достаточно. Об этом подробнее я рассказал в статье о выборе монитора и видеокарты.

Возможно ли запустить просто две карты, без режима сли и кросса. Т.е. просто тупо чтоб рабочую область расширить, т.е. мониторов подсоединить больше. А по сути, вопрос и в том, что к примеру, есть мамки где два слотка x16, и они предназначены в основном для режима SLI. Также есть и 3 слота, правда третий хоть и по размерам как 16х, работает на 4x. И вот вопрос, по сути, они все одинаковые?? Или всётаки если использовать режим сли, то нужно подсоединять их в первый и второй, а если без сли то ТОЛЬКО в первый и третий? И получается что, если у меня два слота, то я не могу запустить две карты без сли уже? Или всё таки эти два слота могут работать отдельно друг от друга?

ЗЫ. Речь идёт тока про х16 слоты. То что можно карточку воткнуть в х1 слот, или купить карточку для х1, это всё я знаю, но вопрос конкретно про слоты х16. Обрыл весь нэт, так и не нашёо ответ на свой вопрос. Интерсует ответ знающих людей, кто в курсе технологий и функций, мамок, где установлены по два слота х16.

PSS. Забыл сказать, что я не могу ни как зупустить у себя две карточки на этих двух слотах. Одна Radeon HD6*** другая Radeon X1300 на мамке ASUS P8P67 LE

По этому “Или всё таки эти два слота могут работать отдельно друг от друга”, если вы имеете ввиду работу отдельно видеокарт, то они ВСЕГДА работают отдельно, но для процессора они ВСЕГДА единый видеоускоритель. Вы можете видеокарту ставить хоть в PCI-E x1, главное что бы были драйверы, включающие ее в видеоускоритель. Crossfire/SLI – это практически и есть набор этих драйверов.

“Забыл сказать, что я не могу ни как зупустить у себя две карточки на этих двух слотах. Одна Radeon HD6*** другая Radeon X1300 на мамке ASUS P8P67 LE” – если вопрос был в том, что можно ли Radeon HD6*** и Radeon X1300 использовать совместно, то честный ответ НЕТ. Но по идеи если найдете (или напишете) драйвера связи этих видеокарт в единый видеоускоритель, то ДА