Обзор видеокарты

Небольшой обзор GTX 560 позволит сделать правильный выбор. Эта модель видеокарты пришла на смену GTX 460. При этом графическое ядро GF 104 было оптимизировано. Модель подходит для всевозможных игр с оптимальными настройками.

Компания NVIDIA предлагает модель в трех вариациях:

- Стандартная разгонная с дополнением Ti.

- Урезанный вариант – 560 SE.

- Для применения в ноутбуках – GTX 560M.

Сокращенная вариация стоит дешевле полноценной. Чтобы не было убытков при производстве, часть шейдерных блоков была заблокирована.

Улучшенная конфигурация видеокарты стоит на 40% выше, чем урезанная конфигурация. Но ее показатели мало отличаются от GTX 460. Поэтому, если выбирать видеокарту нового образца, то лучше приобрести сразу полноценный вариант.

Другие компании также выпустили вариации GTX 560. Например, модель от Manli отличается от оригинальной версии большей частотой – на 4 мегагерца.

Производитель Gigabyte повысил частоту до 830 МГц у видеопроцессора, что даже еще больше, чем у модификации с префиксом Ti.

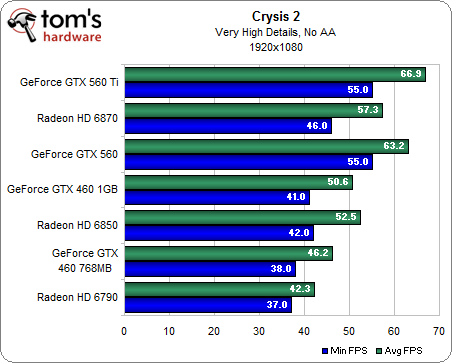

Компания AMD также выпустила аналог – Radeon. Модель от компании NVIDIA выигрывает в сравнительной характеристике, так как у нее гораздо меньше риск возникновения перегрева и меньше шум вентиляторов.

Какой блок питания нужен GTX 560

Для этой модели требуется блок питания не менее 500 Ватт. Оптимальный вариант – 600 Ватт. При этом имеет значение, сколько винчестеров на устройстве и есть ли DVD-Rom.

Чаще всего блок питания подходит, если в наличии есть 2 разъема 6-pin для видеокарты. Если их вдруг нет, то лучше выбрать блок с показателем 600-700 Вт.

Кратко о принципе разгона видеокарт

Подготовительным этапом, если не меняете охлаждение, можно считать:

- подробное ознакомление с архитектурой своей графики, разгонным потенциалом модели;

- очистку системного блока от пыли, особенно радиаторов, термотрубок, лопастей вентиляторов, плат;

- замену термопасты на видеочипе;

- обновление графического драйвера до последней версии;

- загрузку необходимого программного обеспечения для оверклокера: утилиты для разгона, мониторинга, тестирования графического ускорителя – FurMark или MSI Kombustor на его основе.

С чего начинается разгон?

Серьёзный разгон начинается с повышения лимита энергопотребления, ограниченного в BIOS графического ускорителя. Если нужен прирост плюс пару процентов, Power Limit не трогайте: многие модели и экземпляры разгоняются без затрагивания предела потребляемой мощности. Насколько не повышайте частоты с напряжением, свыше пикового значения электроэнергии устройство не съест. При достижении лимита видеокарта сбрасывает частоты, дабы удержать термопакет в заданных программой рамках.

Повышаем тактовую частоту ядра

Сначала поднимается тактовая частота одного компонента (мы начнём с графического ядра Core Clock) на десяток-второй МГц или пару процентов, применяются настройки и устройство тестируется. Рекомендуется не менее 30 минут в FurMark, только мало кто следует советам, но минут 10 стресс-тесту уделите, наблюдая за температурой графической подсистемы. Если она превышает 80-85°, позаботьтесь об охлаждении или убавляйте разгон.

Процесс повторяйте до достижения нужного значения либо появления проблем (изрядный нагрев, троттлинг, ошибки). После обнаружения проблем, скидывания установленных частот понизьте значения на одну-две ступени (10-20 МГц, смотря на сколько повышали)

Увеличиваем частоту шины памяти

Затем аналогично разгоняется графическая память Memory Clock с последующим тестированием, но с шагом 50 МГц (чем выше номинальная, тем больше значение).

Для поддержания частот иногда приходится повышать подаваемое на видеоядро напряжение, с ним (не всегда) – энергопотребление карты в целом Power Limit. А с ростом аппетита видеокарта сильнее греется и шумит. Здесь придётся опытным путём подбирать оптимальные цифры, приблизительные значения которых мы приведём для каждой модели ниже.

Как разогнать видеокарту Nvidia Geforce GTX 560

Чтобы увеличить производительность, можно произвести разгон GTX 560, в результате которого параметр частоты ядра может достичь 950 МГц, шейдерные процессоры – 1900. Увеличивается и показатель частоты памяти – до 4800 МГц.

Не все знают, что разгон видеокарты Nvidia Geforce GTX 560 может выполняться утилитой Afterburner. После осуществления процедуры становится намного лучше производительность в серьезных программах, а также увеличивается fps. Майнинг на GTX 560 имеет более высокую производительность.

Вот как выполняется разгон с помощью программы Afterburner:

- С официального сайта скачивается программа, а затем устанавливается и запускается.

- Выставляются необходимые параметры памяти и ядра. Нельзя повышать шаг разгона более, чем на 100 МГц.

- Затем нужно нажать Apply и провести тестирование в бенчмарках, играх и различных 3D приложениях.

- Если все хорошо, то можно и дальше повышать значения. Если же нет, то нажимается Reset и проставляются меньшие значения.

Для GTX 560 максимальная частота для ядра при разгоне составляет 925 МГц.

Стресс-тест

Компьютерные игры дают видеокарте реальную нагрузку, но полностью загрузить её работой, тем более разноплановой, неспособны. В одних игрушках графическая подсистема стабильна, демонстрирует рост производительности без перегрева, во других – вылетает, сбрасывает частоты, перегревается.

MSI Kombustor – бенчмарк для проверки стабильности графического ускорителя. Предлагает свыше 20 тестов – видов нагрузок на устройство. Задействует все вычислительные блоки, в том числе шейдерные. Для запуска теста выберите алгоритм в первом выпадающем списке (желательно оставить «Plasma (1M-particle)» с задействованием частиц), укажите разрешение своего дисплея в меню «Resolution» и жмите «Start stress test». Сглаживание (antialiasing) лучше не включать, если в корпусе установлена не мощная геймерская модель видеокарты, выпущенная в последние пару лет.

Тестовая конфигурация

- Материнская плата: Gigabyte EX58-UD4 (BIOS v. F10);

- Процессор: Intel Core i7-930 (степпинг D0, 200х20=4000 МГц);

- Система охлаждения процессора: Noctua NH-D14 (2 x Scythe Slip Stream SY1225SL12SH;

950-1800 об/мин);

Оперативная память: Corsair TR3X6G1600C7 (DDR3-1600, 8-8-8-24, 3×2 Гбайта, трехканальный режим);

Видеокарты: NVIDIA GeForce GTX 580, NVIDIA GeForce GTX 570, NVIDIA GeForce GTX 560 Ti, Leadtek GeForce GTX 480 (reference), Point of View GeForce GTX 470, ASUS Radeon HD 5870;

Жесткий диск: Western Digital WD1001FALS (1000 Гбайт);

Блок питания: Cooler Master Real Power M1000 (1 кВт);

Корпус: открытый стенд.

Разгон GeForce 600 Series

Линейка презентовала 28-нм графическое ядро с технологией динамического управления частотой GPU Boost – изменение характеристики в соответствии с нагрузкой без превышения TDP. В чипах реализовано улучшение картинки TXAA – очищает сцены от мерцаний, сглаживает движения. Появилась возможность подключения четырёх дисплеев к одному графическому ускорителю – явная ориентация на геймерскую аудиторию, и блок NVENC – аппаратное кодирование видео.

Драйверами реализовано динамическое сверхвысокое разрешение для адаптации разделительной способности контента под экраны (обычно снижение разрешение высококачественной картинки под экраны с малым разрешением).

| Параметр \ Модель карты | GTX 670 | GTX 680 | GTX 690 | GTX 650 | GTX 650 Ti | GTX 660 | GTX 650 Ti Boost | GTX 660 Ti |

| Core Voltage, В | 1.175 | 1.075 | 1.125 | 1.010 | 1.037 | 1.1750 | 1.070 | 1.162 |

| Power Limit | 106% | 125% | 135% | — | — | 107.5% | — | 123% |

| Core Clock, МГц | 1061 | 1280 | 1172 | 1240 | 1176 | 1180 | + 400 | 1071 |

| Memory Clock, МГц | 1615 | 1800 | 1700 | 1552 | 1575 | 1652 | — | 1765 |

Технические характеристики

Особенно важны технические характеристики GTX 560. О производительности свидетельствуют количественные параметры, а также результаты тестовых игр и бенчмаркеров. Если говорить о первой составляющей, то здесь следующие показатели:

- Частота ядра – 810 МГц.

- Количество транзисторов – 1,95 млн.

- Шейдерные процессы – 336.

- Энергопотребление – 150 Вт.

- Скорость текстурирования – 45,4.

Характеристики видеокарты Nvidia Geforce GTX 560 включают совместимость и размеры. Они указывают на возможность совместимости с другими устройствами. Для обычных компьютеров для совместимости материнской платы и блока необходимо знать физические размеры, а также важны дополнительные разъемы питания и шина подключения.

Если видеокарта для ноутбука не распаивается на материнской плате, а подсоединяется через разъем, то значение имеет разъем подключения, шина и размер. Что касается этого варианта, то шина – 16*PCI-E2.0, толщина – 2 слота, длина – 21 см, высота – 11.1 см.

Память также имеет параметры: объем, тип, пропускную способность и частотность. При встроенном в процессор варианте, когда нет собственной памяти, применяется часть оперативной. Наибольшее значение – 1 Гб, 4000 МГц – показатель частоты и 128 Гб/с является важным параметром пропускной способности.

Для десктопных видеокарт актуальны разъемы. Используются стандартные видеоразъемы. Если предусмотрена возможность применения нескольких экранов, то применяется HDCP, а также HDMI.

Видеокарта поддерживает определенные технологические решения:

- 3D Gaming;

- 3D Vision;

- CUDA;

- SLI.

Важным показателем являются тесты в бенчмарках. Они демонстрируют производительность в неигровых бенчмарках. Стандартно был проставляется от 0 и до 100, при этом 100 – значение самой быстрой видеокарты. Средняя производительность Nvidia Geforce GTX 560 – 18,9.

В связи с повышенным вниманием к крипвалютам, имеет значение и производительность в майнинге. Результат измеряется количеством миллионов решений, которые способна видеокарта сгенерировать за секунду

В этом случае показатель равен 80 Mh/s.

Обзор видеокарты

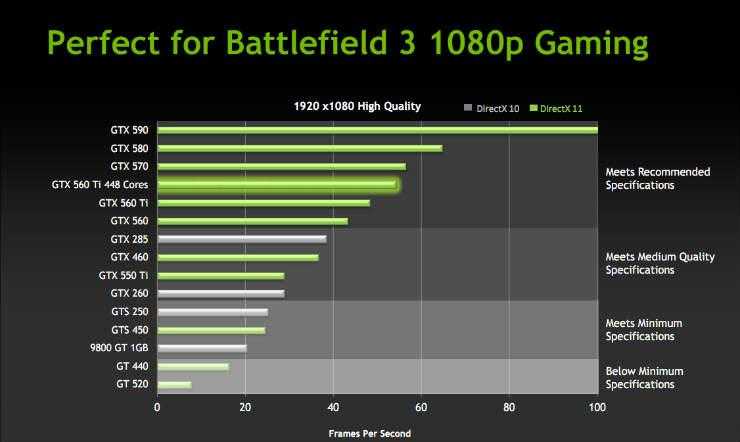

За раскрытие мощностей видеокарты отвечает процессор. Для модели GTX 560 Ti отличным вариантом являются чипы от компании Intel. Видеоускоритель в связке с процессором Intel core i3 и выше будет работать на 100% своих возможностей в современных играх и программах.

Энергопотребление видеокарты – 170 Вт. Из этого следует вывод, что оптимальным выбором блока питания будут варианты с мощностью от 300 Вт и выше. Этой мощности будет достаточно даже при работе с большим количеством оперативной памяти и мощным процессором.

Что же касается нагрева видеоускорителя, то рабочая температура видеокарты Nvidia GTX 560 Ti составляет 80-85 градусов. В редких случаях она может достигать 100 градусов. При увеличении этого показателя стоит всерьез задуматься над заменой заводской термопасты на новую.

Улучшение производительности

Если стандартных мощностей видеокарты кажется вам недостаточно, то стоит обратить внимание на разгон GTX 560 Ti. Он позволит увеличить производительность

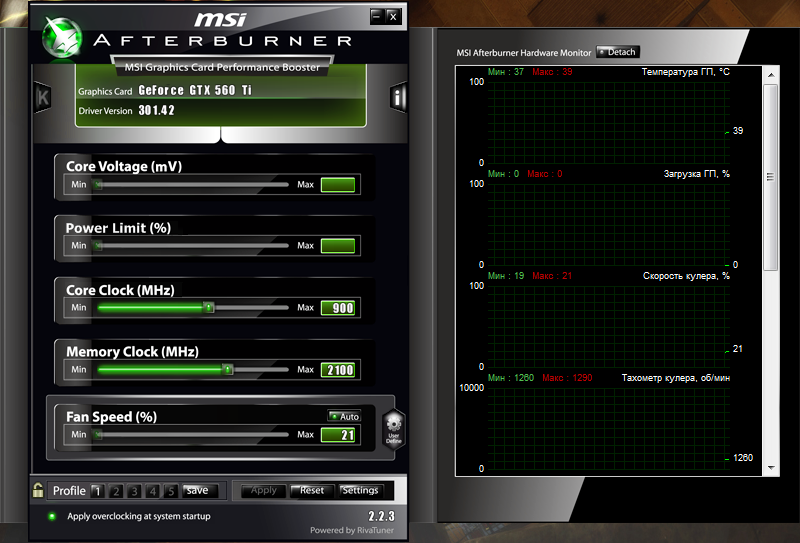

Для осуществления разгона понадобится программа MSI Afterburner. После ее запуска можно наблюдать интерфейс со следующими показателями:

- Core Voltage – отвечает за напряжение ядра.

- Power Limit – предел энергопотребления.

- Core Clock – частота ядра графического процессора.

- Memory Clock – частота памяти графического процессора.

- Fan speed – скорость кулера.

Из всех пунктов нам нужно будет увеличить два показателя: Core Clock и Memory Clock. Частоту ядра ГП увеличиваем до 900 MHz. Частоту памяти поднимаем до 2100 MHz.

После того как разгон видеокарты Nvidia Geforce GTX 560 Ti завершен, нужно произвести стресс-тест при помощи утилиты Funmark. Он позволит выявить неполадки в работе, если они имеются. В случае обнаружения неисправностей, увеличенные в MSI Afterburner показатели нужно уменьшить.

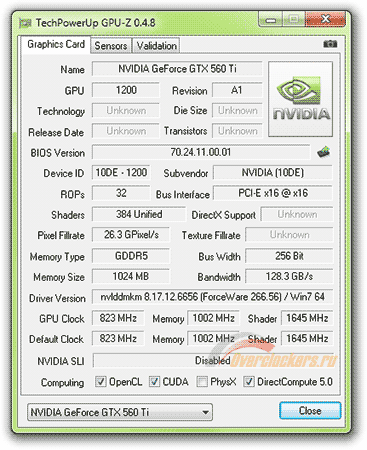

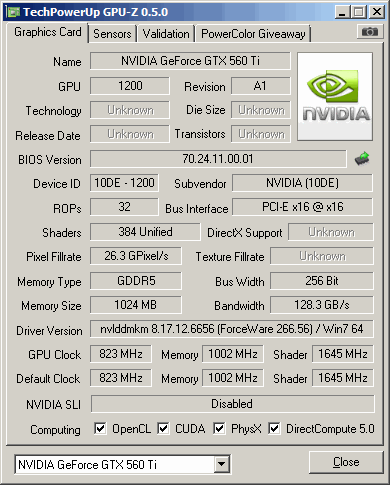

Финальный результат разгона можно посмотреть при помощи программы GPU-Z. Она позволяет производить мониторинг всех показателей видеоускорителя.

Аккуратный разгон видеокарты ASUS GTX560 Ti

Когда-то давно пользовался для разгона видеокарты (вроде бы GeForce Ti 4200) программой RivaTuner, сейчас же на первый план вышла MSI Afterburner, как ответвление первой. Ей и воспользуемся.

1. Заходим и скачиваем MSI Afterburner с официального сайта.

2. Устанавливаем и запускаем:

Здесь мы видим основные настройки (подробнее см. в мануале на английском):Core Voltage (mV) — Напряжение ядраPower Limit (%) — Предел энергопотребления (для слабых блоков питания)Core Clock (MHz) — частота ядра ГП (графического процессора)Memory Clock (MHz) — частота памяти ГПFan Speed (%) — скорость кулера

По-умолчанию были выставлены следующие частоты:

Ядро: 830 MhzПамять: 2004 Mhz

3. В спецификациях к видеокартах ASUS на том же чипе GeForce GTX560, но с заводским разгоном были найдены параметры:

Ядро: 900 MhzПамять: 2100 Mhz (1050 x 2 — чтобы получить номинальную частоту умножили ее на 2)

На OverClockers пишут, что повышение напряжение для таких частот у данной модели необязательно, т.к. выставлено с запасом, поэтому пропускаем этот шаг.

Вбиваем в зеленые поля значения:Core Clock (MHz) — 900Memory Clock (MHz) — 2100

При отсутствии тестов разгона вашей модели видеокарты, существует упрощенное правило:Не повышать частоты больше, чем на 100 МГц.

4. Жмем Apply и тестируем в играх, бенчмарках и других 3D-приложениях. Смотрим нет ли перегрева и артефактов картинки (шум, зависание, вытягивание полигонов).

5. Если все OK, то жамкаем по «Apply overclocking at system startup«. Если нет, то по «Reset» и пытаемся поставить меньшие значения.

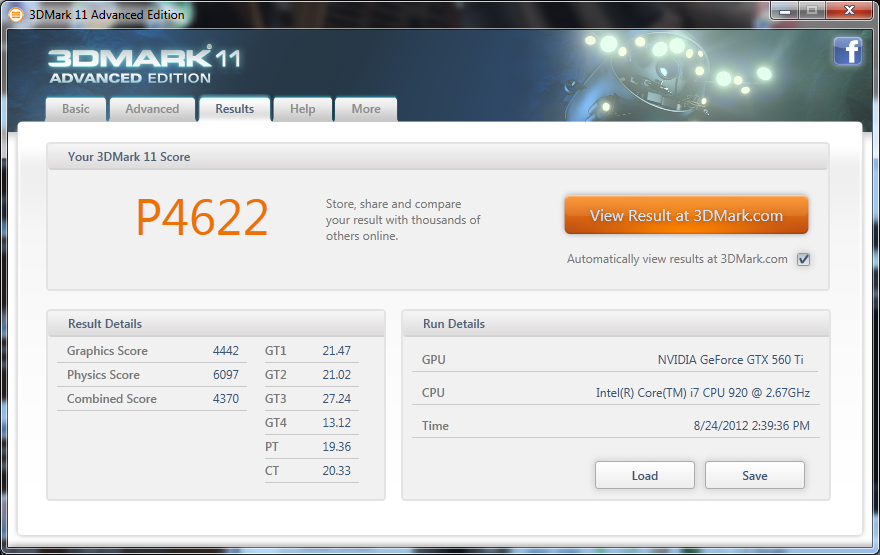

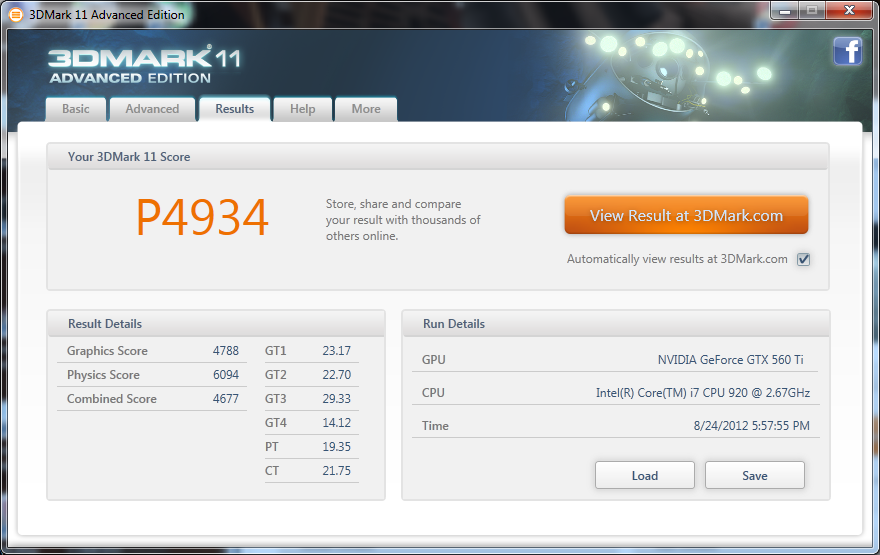

У меня получился прирост в среднем на 2 FPS и 300 попугаев в популярном бенчмарке 3DMark11, не затронув тест «физики» в режиме Performance.

В общем, в разгоне нет ничего сложного, если подходить с умом.Для GeForce GTX560 наивысшей частотой заводского разгона является 925 МГц для ядра, поэтому еще есть куда развернуться, но без повышения вольтажа здесь уже не обойтись.

источник

Разгон

Итак, рассмотрим, как правильно выполнить разгон видеокарты на ноутбуке или ПК.

Запускаем MSI Afterburner. Нас интересует три показателя, регулируемые ползунками:

- Core Clock (частота GPU).

- Memory Clock (память).

- Power Limit.

Core Voltage, как уже говорилось ранее, лучше не трогать. Особенности утилиты таковы, что лимит энергопотребления можно увеличивать до максимума при условии наличия БП с соответствующим запасом по мощности. Увеличение частоты видеопамяти – параметр спорный: на многих современных моделях карт эта операция практически бесполезна. Но ядро разгонять стоит.

Чтобы застраховаться от разгона разогнанного чипа, жмём кнопку Reset, после чего можно передвинуть ползунок Core Clock вправо (максимум на 100 единиц). Жмём Apply и запускаем бенчмарк для сравнения производительности. Если вы перестарались, тестовая утилита слетит, и тогда уменьшаем частоту где-то на десять единиц. В противном случае пробуйте снова увеличивать Core Clock – такими итерациями вы найдёте предельное значение стабильной работы разогнанной карты.

Правда, лучше тестировать стабильность на реальных играх, погоняв их не менее получаса. Если фризов и искажений не наблюдалось – ядро разогнано оптимальным образом, иначе – снова сбавляйте частоту. Следите за температурой чипа, она не должна превышать 80°С.

Теперь можно поиграть с видеопамятью, предварительно сбросив разгон ядра кнопкой Reset. Процедура практически идентичная: добавляем около 300 МГц и далее выполняем итерации по увеличению/уменьшению частоты, в зависимости от результата.

Теперь нужно вернуть оптимальную разгонную частоту ядра и проверит работу подсистемы с двумя увеличенными параметрами. Если бенчмарк сваливается, уменьшайте частоту памяти на 10 единиц, пока не добьётесь стабильной работы.

Как разогнать встроенную видеокарту

В большинстве случаев такая операция бессмысленна из-за невысокой производительности интегрированной графической подсистемы, небольшой процент прироста производительности будет попросту незаметным. Но если сильно хочется, используйте утилиту GMABooster, принцип действия которой схож с MSI Afterburner, но эта программа ориентирована именно на интеловскую встроенную графику.

Обзор видеокарты

Небольшой обзор GTX 560 позволит сделать правильный выбор. Эта модель видеокарты пришла на смену GTX 460. При этом графическое ядро GF 104 было оптимизировано. Модель подходит для всевозможных игр с оптимальными настройками.

Компания NVIDIA предлагает модель в трех вариациях:

- Стандартная разгонная с дополнением Ti.

- Урезанный вариант – 560 SE.

- Для применения в ноутбуках – GTX 560M.

Сокращенная вариация стоит дешевле полноценной. Чтобы не было убытков при производстве, часть шейдерных блоков была заблокирована.

Улучшенная конфигурация видеокарты стоит на 40% выше, чем урезанная конфигурация. Но ее показатели мало отличаются от GTX 460. Поэтому, если выбирать видеокарту нового образца, то лучше приобрести сразу полноценный вариант.

Другие компании также выпустили вариации GTX 560. Например, модель от Manli отличается от оригинальной версии большей частотой – на 4 мегагерца.

Производитель Gigabyte повысил частоту до 830 МГц у видеопроцессора, что даже еще больше, чем у модификации с префиксом Ti.

Компания AMD также выпустила аналог – Radeon. Модель от компании NV >Какой блок питания нужен GTX 560

Для этой модели требуется блок питания не менее 500 Ватт. Оптимальный вариант – 600 Ватт. При этом имеет значение, сколько винчестеров на устройстве и есть ли DVD-Rom.

Чаще всего блок питания подходит, если в наличии есть 2 разъема 6-pin для видеокарты. Если их вдруг нет, то лучше выбрать блок с показателем 600-700 Вт.

Где взять драйвера

Для получения максимальной производительности нужно скачать последние драйвера Nvidia Geforce GTX 560 Ti с официального сайта. Компания-производитель старается выпускать новые версии драйверов как можно чаще. Они направлены на улучшение работы устройства в современных играх.

Чтобы не пропускать выход новых версий драйверов, можно скачать программу Geforce Experience. С ее помощью пользователи получает оповещения о необходимости установки обновлений.

Для Windows 10

| 32-bit | 64-bit |

Размер файла:

400.00 МБВерсия драйвера: 391.35 (WHQL) от 27.03.2018;Язык: РусскийОперационная система: Windows 10 32/64-bit, Windows 7 32/64-bit, Windows 8.1 32/64-bit, Windows 8 32/64-bit, Windows Vista

Запрограммированная на успех: обзор NVIDIA GeForce GTX 560 Ti (страница 2)

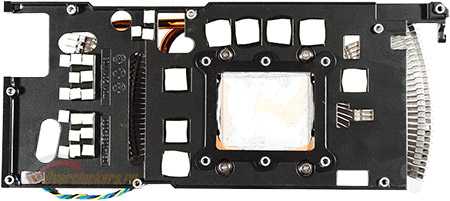

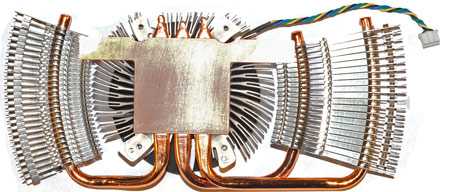

Обратите внимание, что радиатор с вентилятором закреплены на черной металлической рамке-подложке, которая накрывает почти всю поверхность платы. Данная рамка «собирает» тепло с микросхем памяти и элементов преобразователей питания

После отделения системы охлаждения от видеокарты можно осмотреть ее обратную сторону. Теплопередача осуществляется при помощи термопрокладок.

Подпружиненные винты в данном случае расположены именно на рамке, и основание может немного сдвигаться относительно нее. Саму рамку и печатаную плату стягивают самые обычные винты без пружин.

На фото вы наверняка заметили, какой толстенный слой термопласты нанесен на основание. Обычно я провожу разборку ускорителя после всех тестов, но сейчас сделал это немного раньше, из-за того, что видеокарта показывала слишком слабые результаты в температурном тестировании.

Решив, что причиной всему избыточность нанесенного слоя, я перемазал пасту очень тонко. Проверка отпечатка показала, что контакт наблюдается только по краям и маленькими «кляксами» в центре. Удивившись такой кривизне, я нанес приблизительно вдвое больше пасты (хотя и в этом случае слой был гораздо тоньше, чем «родной»). Хороший контакт получился только в нижней части основания, верхняя часть квадрата была едва задета. Аккуратно нарастив слой только в этой «проблемной области» для достижения хоть какого-то контакта я продолжил тесты.

Удивительно, что выделенный на растерзание журналистам образец оказался с таким дефектом. Видимо, видеокарта не очень тщательно проверялась. Вы будете удивлены, но на этом дефекты не закончились, еще одним проблемным местом оказался вентилятор, о чем я расскажу в соответствующем разделе.

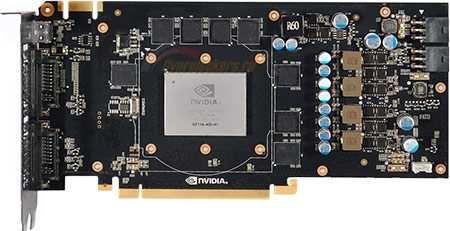

Вокруг GPU c прямоугольной крышкой (маркировка GF114-400-A1) размещены восемь микросхем видеопамяти. Такая же компоновка применялась на GeForce GTX 460 1024 Мбайт. В данном случае микросхемы маркированы как Samsung K4G10325FE-HC04, что указывает на номинальную частоту 1250 МГц (эффективная частота 5000 МГц QDR). Такая же память стоит на очень многих видеокартах, например на флагманах прошлого поколения GeForce GTX 480 и Radeon HD 5870. На «референсе» GeForce GTX 460 также применялись микросхемы Samsung, но с маркировкой K4G10325FE-HC05, их номинальная частота составляет 1000 (4000 МГц).

Отмечаю, что на данном ускорителе потенциал микросхем используется не полностью, их частота составляет только 1002 (4008 МГц). Недобор почти в 20%! Раньше я в таких случаях писал, что мол «эту несправедливость легко исправить разгоном», но на практике оказалось, что далеко не всегда микросхемы берут даже номинальную частоту. Очевидно, производители частенько занижают напряжение питания, чтобы уменьшить энергопотребление и тепловыделение.

В целом, конструкция видеокарты соответствует занимаемой ценовой нише. Никаких инженерных изысков я не увидел, но и придраться не к чему. Единственное «НО» — явный брак, допущенный при изготовлении основания системы охлаждения, в дальнейшем это может помешать проведению тестов и разгону ускорителя. Впрочем, зачем откладывать, самое время проверить видеокарту в действии, но сначала приведу вспомогательные данные по методике.

Технические характеристики

Для получения полной картины о том, что именно из себя представляет видеокарта, нужно более подробно рассмотреть характеристики GTX 560 Ti:

- В качестве графического процессора выступает GF114 с 40-нанометровым техпроцессом.

- Тактовая частота ядра составляет 822 МГц.

- Количество установленных транзисторов – 1950 млн. штук.

- Число потоковых мультипроцессоров – 8.

- Количество блоков растеризации – 32.

- Текстурных блоков – 64.

- Объем видеопамяти составляет 1024 МБ типа GDDR5 и пропускной способностью 128 Гбайт/с.

- Эффективная частота – 4008 МГц.

- Шина памяти – 256 бит.

Этих характеристик Nvidia Geforce GTX 560 Ti будет достаточно для запуска современных игр на низких и средних настройках. Также этот видеоускоритель отлично справится с обработкой фотографий и видео в «тяжелых» программах.

Сравнение производителей

В таблице можно посмотреть цены на GTX 560 от разных брендовых компаний.

| Производитель | Характеристики | Цена, руб. |

|---|---|---|

| Видеокарта PCI-E Asus GeForce GTX 560 | Общий объем памяти: 1 Гб. | 6500 |

| Показатель частоты: 4008 МГц. | ||

| Разъем для видео: mini HDMI. | ||

| Значение разрешения: 2560*1600. | ||

| Минимальное значение частоты: 810 МГц. | ||

| MSI GeForce GTX 560 Ti 448 732Mhz PCI-E 2.0 | Значение частоты видеокарты: 3800 МГц. | 7000 |

| Объем видеопамяти: 1280 Мб. | ||

| Показатель разрядности шины: 320 бит. | ||

| GIGABYTE GeForce GTX 560 900Mhz PCI-E 2.0 | Параметр частотности графического процессора: 900 МГц. | 3500 |

| Значение объема памяти: 1024 Мб. | ||

| Техпроцессор: 40 нм. | ||

| Palit GeForce GTX 560 810Mhz PCI-E 2.0 | Показатель для графического процессора: 810 МГц. | 4500 |

| Частота шейдерных блоков: 620 МГц. | ||

| Разрядность шины: 256 Мб. | ||

| Видеокарта ZOTAC Nvidia GeForce GTX 560 | Объем видеопамяти: 1 Гб. | 4000 |

| Частота видеопамяти: 4008 МГц. | ||

| Мощность блока питания: 550 Вт. | ||

| 150 Вт потребляется при сильных нагрузках. |

Как видно из сравнительной таблицы, в зависимости от производителя, цены на эту модель видеокарты начинаются от 3500 руб. и доходят до 7000 руб.

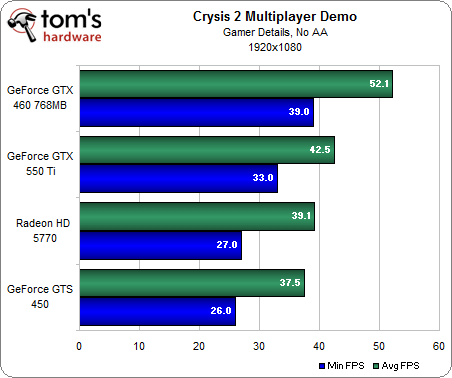

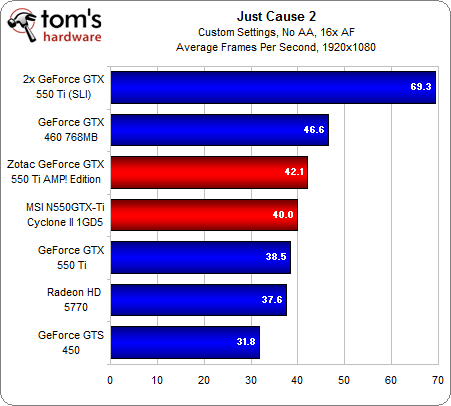

Какие игры тянет видеокарта Nvidia Geforce GTX 550 Ti

Рассматриваемый видеоадаптер обладает вполне приемлемыми характеристиками для увлечения видеоиграми, о чем говорит и частота ядра, и количество памяти, и прочие показатели. Рассмотрим подробнее, какие игры пойдут с Nvidia Geforce GTX 550 Ti.

Карточка способна поддерживать и предоставлять вполне комфортные условия в следующих играх на разрешении 1680х1050 dpi:

- Mafia 2 – занимает 2 позицию из тестируемых карт, находится между GTX 460 768MB и GTS 450 1024MB.

- Bulletstorm – находится на 3 месте и обеспечивает вполне нормальные условия на максимальных настройках графики.

- Crysis: Warhead – карта находится уже на 4-й позиции после Radeon HD 5770, выдает 28,1 fps.

Также неплохой показывает тест карта GTX 550 Ti в играх: Just Cause 2, Two Worlds 2, Colin McRae: DiRT 2, Aliens vs. Predator.

Как разогнать видеокарту

В отличие от разгона процессора, разгон видеокарты выполняют не через BIOS, а с использованием программ и утилит. Можно выделить три типа разгона:

- Разгон с помощью драйвера;

- С использованием специальных программ для разгона, выпущенных самими производителями видеокарт;

- С помощью дополнительных программ.

Процесс оптимизации в принципе одинаковый для любого типа, будь то Radeon AMD или Asus. По сути, чтобы повысить производительность видеокарты нужно усилить частоту ядра и памяти и сбалансировать систему охлаждения. Рассмотрим оптимизацию конкретно на примере использования некогда одной из самых популярных программ RivaTuner В.

Ищем в интернете и скачиваем на свой компьютер саму программу RivaTuner, программу Everest, которая позволит отслеживать температуру нагревания и 3Dmark, необходимую для тестирования производительности. Устанавливаем скачанный софт.

Запускаем RivaTuner.

Кликаем на треугольный знак в правой части экрана и выбираем пункт «Системные настройки».

В системных настройках ищем строку «Кулер» и опцию низкоуровневого управления кулером. На экране появится всплывающее окно с оповещением о перезагрузке. Ставим галочку в пункте «определить всё» и кликаем «ок». Затем выставляем настройки кулера вручную: выбираем постоянный режим, устанавливаем 95% и сохраняем изменения. Если при работе компьютера кулер работает слишком громко, можно снизить значение до 80–85%. Выбираем пункт «загружать настройки с Windows»

Снова открываем окно разгона видеокарты. Включаем опцию «низкоуровневое управление разгоном» и в выскочившем окошке указываем «определить всё». Теперь два ползунка активизировались, ими можно управлять. Двигаем ползунок, изменяющий частоту ядра. Повышаем частоту постепенно, с шагом 10%. Параллельно после каждого изменения тестируем. Если тест положительный, кликаем «ок» и применяем настройки. Открываем Everest и 3Dmark. Тестируем видеокарту с изменёнными настройками. В Everest проверяем температуру — она должна быть не больше 90%. Во время тестирования тщательно следим за экраном — если изображение начнёт искажаться (появляются так называемые артефакты), прекращайте тестирование и уменьшайте частоту на 15 МГц. Запускайте тест снова. Ровно те же операции производим при высоких показателях температуры.

С помощью тестов нам необходимо найти пороговую частоту, т.е. самое высокое значение, при котором артефакты не обнаруживаются. При нормальных результатах повышаем частоту снова и снова пока не увидим искажение картинки. Далее снижаем частоту на небольшое значение и удостоверяемся, что артефакты не появляются. Так мы нашли максимально рабочую частоту видеокарты. Отмечаем её значение на листе бумаги и кликаем в настройках на «сбросить все настройки».

Займёмся оптимизацией памяти. Суть разгона та же, как и при разгоне частоты. Постепенно увеличиваем значение на 10%, следим за температурой и искажениями изображений. Аналогично с пунктом 4 находим максимальное значение памяти, записываем его. Не изменяя максимального значения памяти, устанавливаем значение частоты на максимальную (частота, которую вы записали на листике). Кликаем «тест». Если тест положительный, начинаем само тестирование. Далее следует самый значительный этап. Очень внимательно проверяем наличие артефактов при тестировании. Если артефактов не наблюдается, разгон выполнен успешно и следует проверить его на практике, то есть непосредственно в играх. Правильный разгон должен ощутимо увеличить FPS. Если в тесте все же видны искажения, снижаем частоту памяти на 10 МГц и повторяем тест. В случае если даже многократное снижение частоты не помогает устранить появление артефактов, оставляем теперешнее значение частоты памяти и снижаем частоту ядра на 10 МГц. Один или два раза повторяем процедуру до устранения артефактов. Пробуем снова немного увеличить частоту памяти.

ВАЖНО. Вы можете сами подобрать программы для контроля и тестирования

Например, 3D mark считается своеобразным эталоном программ такого типа, однако существуют другие, которые, возможно облегчат вам жизнь. Например, программа OCCT не только тестирует видеопамять, а и сама отслеживает появление артефактов.

Инструментарий и методика тестирования

Для разгона видеокарт, а также для мониторинга температур и оборотов вентилятора использовалась утилита MSI Afterburner 2.1.0 Beta 6. Для регулировки напряжения питания GPU применялась утилита NVIDIA Inspector v. 1.9.4.2.

Для прогрева и проверки стабильности работы видеокарт в процессе разгона использовались утилиты OCCT GPUw (режим Error Check, 1024 x 768) и FurMark (Stability Test, Extreme burning mode, 1920 х 1200, AA0). Полученные частоты дополнительно проверялись прогонами теста Heaven Benchmark v 2.1 c экстремальным уровнем тесселяции и графических тестов из пакетов 3DMark 06 и 3DMark Vantage.

Для проверки температурного режима видеокарт в условиях, приближенных к повседневным, использовался Heaven BenchMark v. 2.1 (shader: high, tessellation: normal, AA4x, 1920 х 1200).

Производительность в игре Crysis Warhead исследовалась с помощью утилиты Framebuffer Benchmarking Tool. В игре Lost Planet было проведено дополнительное тестирование с помощью утилиты FRAPS v. 3.2.3 для выявления минимального FPS. Остальные игры тестировались с помощью встроенных средств оценки производительности. Во всех случаях была отключена вертикальная синхронизация.

Уровень шума измерялся при помощи цифрового шумомера Becool ВС-8922 с погрешностью измерений не более 0,5 дБ. Измерения проводились с расстояния 1 м. Уровень фонового шума в помещении – не более 27 дБ. Температура воздуха в помещении составляла 22-23 градуса.

Где взять драйвера

Для получения максимальной производительности нужно скачать последние драйвера Nvidia Geforce GTX 560 Ti с официального сайта. Компания-производитель старается выпускать новые версии драйверов как можно чаще. Они направлены на улучшение работы устройства в современных играх. Чтобы не пропускать выход новых версий драйверов, можно скачать программу Geforce Experience. С ее помощью пользователи получает оповещения о необходимости установки обновлений.

Для Windows 10

Размер файла: ~400.00 МБВерсия драйвера: 391.35 (WHQL) от 27.03.2018;Язык: РусскийОперационная система: Windows 10 32/64-bit, Windows 7 32/64-bit, Windows 8.1 32/64-bit, Windows 8 32/64-bit, Windows Vista

Технические характеристики

Для получения полной картины о том, что именно из себя представляет видеокарта, нужно более подробно рассмотреть характеристики GTX 560 Ti:

- В качестве графического процессора выступает GF114 с 40-нанометровым техпроцессом.

- Тактовая частота ядра составляет 822 МГц.

- Количество установленных транзисторов – 1950 млн. штук.

- Число потоковых мультипроцессоров – 8.

- Количество блоков растеризации – 32.

- Текстурных блоков – 64.

- Объем видеопамяти составляет 1024 МБ типа GDDR5 и пропускной способностью 128 Гбайт/с.

- Эффективная частота – 4008 МГц.

- Шина памяти – 256 бит.

Этих характеристик Nv >Обзор видеокарты

За раскрытие мощностей видеокарты отвечает процессор. Для модели GTX 560 Ti отличным вариантом являются чипы от компании Intel. Видеоускоритель в связке с процессором Intel core i3 и выше будет работать на 100% своих возможностей в современных играх и программах.

Что же касается нагрева видеоускорителя, то рабочая температура видеокарты Nv >Улучшение производительности

Если стандартных мощностей видеокарты кажется вам недостаточно, то стоит обратить внимание на разгон GTX 560 Ti. Он позволит увеличить производительность

Для осуществления разгона понадобится программа MSI Afterburner. После ее запуска можно наблюдать интерфейс со следующими показателями:

- Core Voltage – отвечает за напряжение ядра.

- Power Limit – предел энергопотребления.

- Core Clock – частота ядра графического процессора.

- Memory Clock – частота памяти графического процессора.

- Fan speed – скорость кулера.

Из всех пунктов нам нужно будет увеличить два показателя: Core Clock и Memory Clock. Частоту ядра ГП увеличиваем до 900 MHz. Частоту памяти поднимаем до 2100 MHz.

После того как разгон видеокарты Nvidia Geforce GTX 560 Ti завершен, нужно произвести стресс-тест при помощи утилиты Funmark. Он позволит выявить неполадки в работе, если они имеются. В случае обнаружения неисправностей, увеличенные в MSI Afterburner показатели нужно уменьшить.

Финальный результат разгона можно посмотреть при помощи программы GPU-Z. Она позволяет производить мониторинг всех показателей видеоускорителя.