Обзор и тестирование видеокарты Zotac GeForce GTX 680 AMP! Edition

10.05.2012 19:00

Slayer Moon

| Оглавление |

|---|

| Обзор и тестирование видеокарты Zotac GeForce GTX 680 AMP! Edition |

| Конфигурация тестового стенда |

| Игровые тесты |

| Синтетические тесты |

| Энергопотребление видеокарты Zotac GeForce GTX 680 AMP! Edition |

| Уровень шума |

| Разгон видеокарты Zotac GeForce GTX 680 AMP! Edition |

| Выводы |

Разгон видеокарты Zotac GeForce GTX 680 AMP! Edition

Чем разгонялась карточка — не ясно, но напряжение не менялось, да и логику управления вентиляторов не трогали. В итоге был достигнут следующий результат: 1130/7460МГц (ядро/память):

Итого — 2% по ядру и 14% по памяти, могло бы быть и лучше. Впрочем, у моей GTX 680 дела нисколько не лучше, как я ни старался.

Далее нам показали табличку, по которой становится ясно, как погнались те или иные карты на основе разных графических чипов:

| Сравнение разгона видеокарт | ||

|---|---|---|

| Максимальная частота ядра | Максимальная частота памяти | |

| Zotac GeForce GTX 680 AMP! Edition | 1130 МГц | 1890 МГц |

| MSI HD 7870 Twin Frozr | 1230 МГц | 1615 МГц |

| NVIDIA GTX 680 | 1147 МГц | 1833 МГц |

| ASUS HD 7870 DirectCU II | 1260 МГц | 1620 МГц |

| AMD HD 7870 | 1205 МГц | 1520 МГц |

| Palit GTX 680 JetStream | 1165 МГц | 1833 МГц |

| ASUS GTX 680 DirectCU II | 1207 МГц | 1766 МГц |

Полезная табличка, ничего не скажешь. Однако, стоит держать в уме золотое правило — «разгон = лотерея».

По табличке ниже можно понять, как сильно оверклокерские манипуляции повлияли на производительность видеокарты Zotac (на примере игры Battlefield 3):

Рост производительности за счёт разгона составил 4.7%. Не ахти, но это из-за того, что изначальный разгон у карточки и так немаленький.

А теперь посмотрим на то, как увеличились температуры у Zotac GeForce GTX 680 AMP! Edition в разгоне:

Разница в 2 градуса по Цельсию — не та вещь, о которой стоит беспокоиться.

Далее следует таблица сравнения температур видеокарт от разных производителей:

| Сравнение температуры графического ядра | ||

|---|---|---|

| Простой | Нагрузка | |

| MSI HD 7870 HAWK | 32°C | 76°C |

| MSI HD 7870 Twin Frozr | 37°C | 69°C |

| ASUS HD 7870 DirectCU II | 33°C | 75°C |

| ASUS GTX 680 DirectCU II | 33°C | 70°C |

| AMD HD 7870 | 29°C | 69°C |

| Palit GTX 680 JetStream | 33°C | 78°C |

| ASUS GTX 680 DirectCU II | 33°C | 70°C |

Zotac GeForce GTX 680 AMP! Edition, как и многие другие видеокарты под разными видами нагрузки, выставляют особые частоты и напряжения, вот соответствующая табличка:

| Частота ядра | Частота памяти | Напряжение на GPU (основано на замерах) | |

| Режим 2D (карта в простое) | 324 МГц | 162 МГц | 0.99 V |

| Мультимониторная конфигурация | 324 МГц | 162 МГц | 0.99 V |

| Воспроизведение Blu-ray | 324 МГц | 162 МГц | 0.99 V |

| Режим 3D (карта в нагрузке) | 1020-1202 МГц | 1652 МГц | 1.012-1.175 V |

<< Предыдущая — Следующая >>

| Последние материалы на сайте: |

|

Разгон GeForce 600 Series

Линейка презентовала 28-нм графическое ядро с технологией динамического управления частотой GPU Boost – изменение характеристики в соответствии с нагрузкой без превышения TDP. В чипах реализовано улучшение картинки TXAA – очищает сцены от мерцаний, сглаживает движения. Появилась возможность подключения четырёх дисплеев к одному графическому ускорителю – явная ориентация на геймерскую аудиторию, и блок NVENC – аппаратное кодирование видео.

Драйверами реализовано динамическое сверхвысокое разрешение для адаптации разделительной способности контента под экраны (обычно снижение разрешение высококачественной картинки под экраны с малым разрешением).

| Параметр \ Модель карты | GTX 670 | GTX 680 | GTX 690 | GTX 650 | GTX 650 Ti | GTX 660 | GTX 650 Ti Boost | GTX 660 Ti |

| Core Voltage, В | 1.175 | 1.075 | 1.125 | 1.010 | 1.037 | 1.1750 | 1.070 | 1.162 |

| Power Limit | 106% | 125% | 135% | — | — | 107.5% | — | 123% |

| Core Clock, МГц | 1061 | 1280 | 1172 | 1240 | 1176 | 1180 | + 400 | 1071 |

| Memory Clock, МГц | 1615 | 1800 | 1700 | 1552 | 1575 | 1652 | — | 1765 |

Как разогнать видеокарту NVIDIA GeForce?

Графические процессоры компании Nvidia нельзя ускорить путем модификации BIOS (биос просто не шился до определенного времени). Флагману 2017 года GTX 1080Ti повышали хешрейт на эфире путем установки специального ПО, так называемой «таблетки», но для других устройств такого софта не существует. В зависимости от целей разгона нужно определить показатели, при которых устройство покажет себя максимально эффективно и не будет греться. Для майнинга придётся искать оптимальные параметры под конкретную валюту. Рассмотрим, как правильно разгонять разные видеокарты Nvidia GeForce.

Работа с программой для разгона видеокарты

Теперь необходимо рассмотреть особенности работы с программой MSI Afterburner, настройка видеокарты где является простым и доступным действием. Далее будут инструкции, которые позволят вам добиться желаемого результата.

Выполнение настроек

Запустите программу, где вы увидите главный экран. Можно будет заметить графу под названием Graphics Card, где указано имя видеокарты.

Немного выше нарисована кнопка в виде шестеренки. С её помощью вы сможете открыть настройки. Кликните по ней.

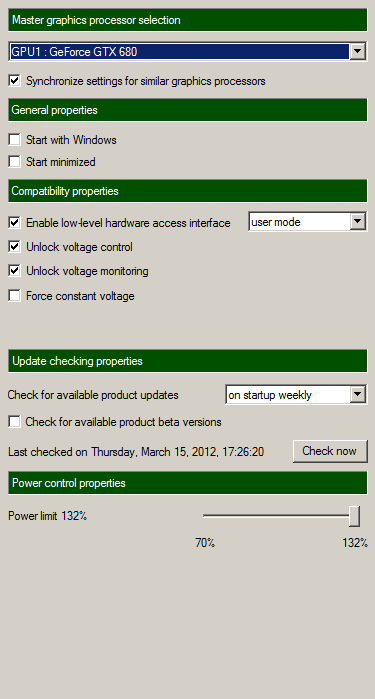

Есть специальная графа «Выбор ведущего графического процессора», расположенная в разделе «Основные». Укажите в ней именно ту видеокарту, которую планируете разгонять. Если у вас имеется два модуля (обычный и дискретный), также необходимо включить пункт «Синхронизировать настройки одинаковых ГП».

На той же вкладке необходимо установить галочку возле пункта «Разблокировать мониторинг напряжения».

Откройте вкладку под названием «Кулер» и выберите «Включить программный пользовательский авторежим». Это нужно для того, чтобы создать зависимость между температурой видеокарты, а также скоростью, с которой вращается вентилятор.

Работа с ползунками

Вернувшись на главный экран, следует выполнить настройку ползунков. Трогать напряжение, а также температуру и потребление энергии не рекомендуется. Fan Speed необходимо оставить на значении «Auto».

Главное, с чем придётся работать – это Core Clock и Memory Clock, то есть частота ядра и видеопамяти. Значения выставляются в зависимости от того, какая у вас видеокарта.

Параметр Core Clock следует сместить на отметку в 10-21 МГц. Затем жмите на «Применить». Для Memory Clock выберите 10-20 МГц и так же кликните на «Применить». Итогом станут цифры в виде 921 и 2072 МГц.

Тестирование

Теперь запустите мощную и требовательную игру. Разгон видеокарты через MSI Afterburner уже был реализован. Самое время для того, чтобы проверить результат. Программу не закрывайте и пару часов поиграйте в игру. Отслеживайте график температуры. Если всё работает ровно, а игра не тормозит и отсутствуют искажения изображения, вы можете продолжать увеличение показателей. Как разгонять видеокарты NVIDIA через MSI Afterburner вы уже знаете. Увеличьте показатели ещё на 10 МГц.

Вновь пробуйте играть. Действуйте до тех пор, пока не возникнет каких-то помех и искажений изображения. Если что-то уже не так, вернитесь в настройки и понизьте значения до тех показателей, когда всё работало стабильно.

Преимущества

Причины выбрать NVIDIA GeForce GTX 1050 (Desktop)

- Видеокарта новее, разница в датах выпуска 4 year(s) 1 month(s)

- Частота ядра примерно на 32% больше: 1290 MHz vs 980 MHz

- Частота ядра в режиме Boost на 35% больше: 1392 MHz vs 1033 MHz

- Более новый технологический процесс производства видеокарты позволяет её сделать более мощной, но с меньшим энергопотреблением: 14 nm vs 28 nm

- Примерно на 87% меньше энергопотребление: 75 Watt vs 140 Watt

- Максимальный размер памяти больше в 2 раз(а): 4 GB vs 2 GB

- Частота памяти в 1168 раз(а) больше: 7008 MHz vs 6.0 GB/s

- Производительность в бенчмарке PassMark — G3D Mark примерно на 44% больше: 5701 vs 3954

- Производительность в бенчмарке PassMark — G2D Mark примерно на 26% больше: 541 vs 428

- Производительность в бенчмарке Geekbench — OpenCL примерно на 69% больше: 17733 vs 10470

- Производительность в бенчмарке CompuBench 1.5 Desktop — Face Detection (mPixels/s) в 2.2 раз(а) больше: 67.209 vs 30.505

- Производительность в бенчмарке CompuBench 1.5 Desktop — Ocean Surface Simulation (Frames/s) примерно на 13% больше: 799.414 vs 705.293

- Производительность в бенчмарке CompuBench 1.5 Desktop — T-Rex (Frames/s) примерно на 47% больше: 4.536 vs 3.08

- Производительность в бенчмарке CompuBench 1.5 Desktop — Bitcoin Mining (mHash/s) в 3.6 раз(а) больше: 223.683 vs 62.69

- Производительность в бенчмарке GFXBench 4.0 — Car Chase Offscreen (Frames) примерно на 97% больше: 7043 vs 3581

- Производительность в бенчмарке GFXBench 4.0 — Car Chase Offscreen (Fps) примерно на 97% больше: 7043 vs 3581

| Характеристики | |

| Дата выпуска | 25 October 2020 vs 6 September 2012 |

| Частота ядра | 1290 MHz vs 980 MHz |

| Частота ядра в режиме Boost | 1392 MHz vs 1033 MHz |

| Технологический процесс | 14 nm vs 28 nm |

| Энергопотребление (TDP) | 75 Watt vs 140 Watt |

| Максимальный размер памяти | 4 GB vs 2 GB |

| Частота памяти | 7008 MHz vs 6.0 GB/s |

| Бенчмарки | |

| PassMark — G3D Mark | 5701 vs 3954 |

| PassMark — G2D Mark | 541 vs 428 |

| Geekbench — OpenCL | 17733 vs 10470 |

| CompuBench 1.5 Desktop — Face Detection (mPixels/s) | 67.209 vs 30.505 |

| CompuBench 1.5 Desktop — Ocean Surface Simulation (Frames/s) | 799.414 vs 705.293 |

| CompuBench 1.5 Desktop — T-Rex (Frames/s) | 4.536 vs 3.08 |

| CompuBench 1.5 Desktop — Bitcoin Mining (mHash/s) | 223.683 vs 62.69 |

| GFXBench 4.0 — Car Chase Offscreen (Frames) | 7043 vs 3581 |

| GFXBench 4.0 — Car Chase Offscreen (Fps) | 7043 vs 3581 |

Причины выбрать NVIDIA GeForce GTX 660

- Скорость текстурирования на 35% больше: 78.4 billion / sec vs 58.2 GTexel / s

- Количество шейдерных процессоров на 50% больше: 960 vs 640

- Производительность с плавающей точкой на 6% больше: 1,981 gflops vs 1,862 gflops

- Производительность в бенчмарке CompuBench 1.5 Desktop — Video Composition (Frames/s) примерно на 16% больше: 35.416 vs 30.523

- Производительность в бенчмарке GFXBench 4.0 — T-Rex (Frames) примерно на 99% больше: 6694 vs 3360

- Производительность в бенчмарке GFXBench 4.0 — T-Rex (Fps) примерно на 99% больше: 6694 vs 3360

| Характеристики | |

| Скорость текстурирования | 78.4 billion / sec vs 58.2 GTexel / s |

| Количество шейдерных процессоров | 960 vs 640 |

| Производительность с плавающей точкой | 1,981 gflops vs 1,862 gflops |

| Бенчмарки | |

| CompuBench 1.5 Desktop — Video Composition (Frames/s) | 35.416 vs 30.523 |

| GFXBench 4.0 — Manhattan (Frames) | 3691 vs 3685 |

| GFXBench 4.0 — T-Rex (Frames) | 6694 vs 3360 |

| GFXBench 4.0 — Manhattan (Fps) | 3691 vs 3685 |

| GFXBench 4.0 — T-Rex (Fps) | 6694 vs 3360 |

Тестирование GeForce GTX 680 в разгоне до 1300+ МГц

27.03.2012 19:00

Slayer Moon

| Оглавление |

|---|

| Тестирование GeForce GTX 680 в разгоне до 1300+ МГц |

| Энергопотребление/температурный режим/уровень шума |

| Конфигурация тестового стенда и используемые игры |

| DX10: 3DMark Vantage |

| DX11: Crysis 2 + текстуры высокого разрешения |

| DX9: Hard Reset |

| DX11: Metro 2033 |

| DX11: Battlefield Bad Company 2 |

| DX11: Battlefield 3 |

| DX11: Aliens Versus Predator |

| DX11: Lost Planet 2 |

| DX11: Anno 2070 |

| DX11: 3DMark 11 |

| Выводы |

SocButtons v1.5

Спецификации новой видеокарты от Nvidia, а также некоторых её родственниц изложены в табличке ниже:

| GTX 680 | GTX 580 | GTX 560 Ti | GTX 480 | |

| Потоковые процессоры | 1536 | 512 | 384 | 480 |

| Текстурные блоки | 128 | 64 | 64 | 60 |

| ROPы | 32 | 48 | 32 | 48 |

| Частота ядра | 1006МГц | 772МГц | 822МГц | 700МГц |

| Частота шейдеров | Н/Д | 1544МГц | 1644МГц | 1401МГц |

| Частота Boost | 1058МГц | Н/Д | Н/Д | N/A |

| Частота памяти | 6.008ГГц GDDR5 | 4.008ГГц GDDR5 | 4.008ГГц GDDR5 | 3.696ГГц GDDR5 |

| Шина памяти | 256-бит | 384-бит | 256-бит | 384-бит |

| Объём памяти | 2ГБ | 1.5ГБ | 1ГБ | 1.5ГБ |

| FP64 | 1/24 FP32 | 1/8 FP32 | 1/12 FP32 | 1/12 FP32 |

| TDP | 195 ватт | 244 ватта | 170 ватт | 250 ватт |

| Количество транзисторов | 3.5 миллиарда | 3 миллиарда | 1.95 миллиарда | 3 миллиарда |

| Тех.процесс изготовления | TSMC 28нм | TSMC 40нм | TSMC 40нм | TSMC 40нм |

| Стоимость, установленная при запуске решения | $499 | $499 | $249 | $499 |

Прежде чем приступить к просмотру результатов тестов разогнанной GTX 680, нам предлагают посмотреть, до каких, собственно, частот карточка погналась вообще:

| Частоты референсной карты GeForce GTX 680 (в МГц) | Частоты GeForce GTX 680 в номинале (в МГц) | Частоты GeForce GTX 680 в разгоне (в МГц) |

| Ядро: 1006 | 1006 | ~1300 |

| Видеопамять: 6000 | 6000 | 7128 |

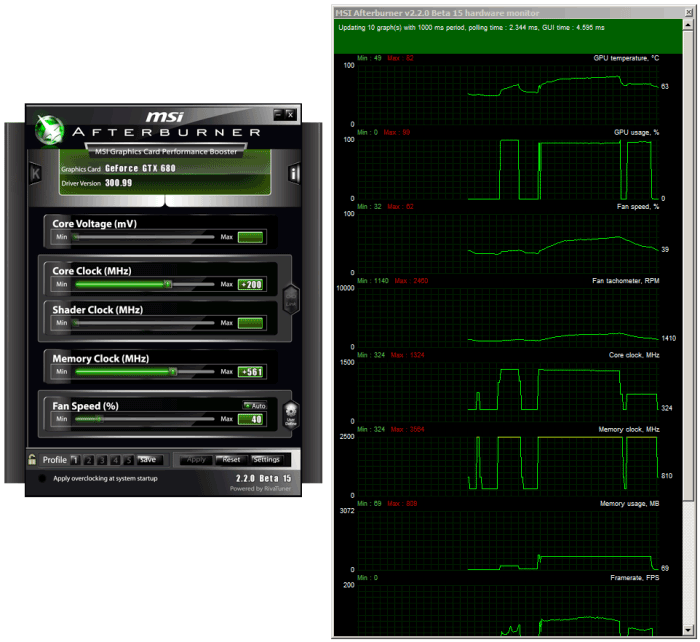

Вновь, как и в прошлый раз, частоты карты поднимали с помощью утилиты MSI Afterburner:

В опциях Afterburner нужно повысить TDP карточки, как показано на скриншоте выше — до 132%. Это не позволит функции Dynamic Boost понижать частоты каждый раз, когда карточка будет превышать лимит по TDP.

Снова нам сообщают, что возможности изменения напряжения на графическом ядре видеокарты во время написания материала не было (хотя утилита EVGA Precision X позволяла поднимать «напругу» до 1.15 вольт, но особой роли это не сыграло), потому разгон в табличке выше получен без игр с «вольтажом».

Как можно увидеть на скриншоте выше, ядро работало на частоте в 1300МГц +/- 25МГц, а память — на 7128МГц, при этом карточка функционировала абсолютно стабильно.

Предыдущая — Следующая >>

| Последние материалы на сайте: |

|

Сравнение бенчмарков

GPU 1: NVIDIA GeForce GTX 1050 (Desktop) GPU 2: NVIDIA GeForce GTX 660

| PassMark — G3D Mark | GPU 1 |

| GPU 2 |

5701

| 3954 |

PassMark — G2D Mark

GPU 1

| GPU 2 |

541

| 428 |

Geekbench — OpenCL

GPU 1

| GPU 2 |

17733

| 10470 |

CompuBench 1.5 Desktop — Face Detection (mPixels/s)

GPU 1

| GPU 2 |

67.209

| 30.505 |

CompuBench 1.5 Desktop — Ocean Surface Simulation (Frames/s)

GPU 1

| GPU 2 |

799.414

| 705.293 |

CompuBench 1.5 Desktop — T-Rex (Frames/s)

GPU 1

| GPU 2 |

4.536

| 3.08 |

CompuBench 1.5 Desktop — Video Composition (Frames/s)

GPU 1

| GPU 2 |

30.523

| 35.416 |

CompuBench 1.5 Desktop — Bitcoin Mining (mHash/s)

GPU 1

| GPU 2 |

223.683

| 62.69 |

GFXBench 4.0 — Car Chase Offscreen (Frames)

GPU 1

| GPU 2 |

7043

| 3581 |

GFXBench 4.0 — Manhattan (Frames)

GPU 1

| GPU 2 |

3685

| 3691 |

GFXBench 4.0 — T-Rex (Frames)

GPU 1

| GPU 2 |

3360

| 6694 |

GFXBench 4.0 — Car Chase Offscreen (Fps)

GPU 1

| GPU 2 |

7043

| 3581 |

GFXBench 4.0 — Manhattan (Fps)

GPU 1

| GPU 2 |

3685

| 3691 |

GFXBench 4.0 — T-Rex (Fps)

GPU 1

| GPU 2 |

3360

| 6694 |

| Название | NVIDIA GeForce GTX 1050 (Desktop) | NVIDIA GeForce GTX 660 |

| PassMark — G3D Mark | 5701 | 3954 |

| PassMark — G2D Mark | 541 | 428 |

| Geekbench — OpenCL | 17733 | 10470 |

| CompuBench 1.5 Desktop — Face Detection (mPixels/s) | 67.209 | 30.505 |

| CompuBench 1.5 Desktop — Ocean Surface Simulation (Frames/s) | 799.414 | 705.293 |

| CompuBench 1.5 Desktop — T-Rex (Frames/s) | 4.536 | 3.08 |

| CompuBench 1.5 Desktop — Video Composition (Frames/s) | 30.523 | 35.416 |

| CompuBench 1.5 Desktop — Bitcoin Mining (mHash/s) | 223.683 | 62.69 |

| GFXBench 4.0 — Car Chase Offscreen (Frames) | 7043 | 3581 |

| GFXBench 4.0 — Manhattan (Frames) | 3685 | 3691 |

| GFXBench 4.0 — T-Rex (Frames) | 3360 | 6694 |

| GFXBench 4.0 — Car Chase Offscreen (Fps) | 7043 | 3581 |

| GFXBench 4.0 — Manhattan (Fps) | 3685 | 3691 |

| GFXBench 4.0 — T-Rex (Fps) | 3360 | 6694 |

| 3DMark Fire Strike — Graphics Score |

Кратко о принципе разгона видеокарт

Подготовительным этапом, если не меняете охлаждение, можно считать:

- подробное ознакомление с архитектурой своей графики, разгонным потенциалом модели;

- очистку системного блока от пыли, особенно радиаторов, термотрубок, лопастей вентиляторов, плат;

- замену термопасты на видеочипе;

- обновление графического драйвера до последней версии;

- загрузку необходимого программного обеспечения для оверклокера: утилиты для разгона, мониторинга, тестирования графического ускорителя – FurMark или MSI Kombustor на его основе.

С чего начинается разгон?

Серьёзный разгон начинается с повышения лимита энергопотребления, ограниченного в BIOS графического ускорителя. Если нужен прирост плюс пару процентов, Power Limit не трогайте: многие модели и экземпляры разгоняются без затрагивания предела потребляемой мощности. Насколько не повышайте частоты с напряжением, свыше пикового значения электроэнергии устройство не съест. При достижении лимита видеокарта сбрасывает частоты, дабы удержать термопакет в заданных программой рамках.

Повышаем тактовую частоту ядра

Сначала поднимается тактовая частота одного компонента (мы начнём с графического ядра Core Clock) на десяток-второй МГц или пару процентов, применяются настройки и устройство тестируется. Рекомендуется не менее 30 минут в FurMark, только мало кто следует советам, но минут 10 стресс-тесту уделите, наблюдая за температурой графической подсистемы. Если она превышает 80-85°, позаботьтесь об охлаждении или убавляйте разгон.

Процесс повторяйте до достижения нужного значения либо появления проблем (изрядный нагрев, троттлинг, ошибки). После обнаружения проблем, скидывания установленных частот понизьте значения на одну-две ступени (10-20 МГц, смотря на сколько повышали)

Увеличиваем частоту шины памяти

Затем аналогично разгоняется графическая память Memory Clock с последующим тестированием, но с шагом 50 МГц (чем выше номинальная, тем больше значение).

Для поддержания частот иногда приходится повышать подаваемое на видеоядро напряжение, с ним (не всегда) – энергопотребление карты в целом Power Limit. А с ростом аппетита видеокарта сильнее греется и шумит. Здесь придётся опытным путём подбирать оптимальные цифры, приблизительные значения которых мы приведём для каждой модели ниже.

Как разогнать видеокарту

В отличие от разгона процессора, разгон видеокарты выполняют не через BIOS, а с использованием программ и утилит. Можно выделить три типа разгона:

- Разгон с помощью драйвера;

- С использованием специальных программ для разгона, выпущенных самими производителями видеокарт;

- С помощью дополнительных программ.

Процесс оптимизации в принципе одинаковый для любого типа, будь то Radeon AMD или Asus. По сути, чтобы повысить производительность видеокарты нужно усилить частоту ядра и памяти и сбалансировать систему охлаждения. Рассмотрим оптимизацию конкретно на примере использования некогда одной из самых популярных программ RivaTuner В.

Ищем в интернете и скачиваем на свой компьютер саму программу RivaTuner, программу Everest, которая позволит отслеживать температуру нагревания и 3Dmark, необходимую для тестирования производительности. Устанавливаем скачанный софт.

Запускаем RivaTuner.

Кликаем на треугольный знак в правой части экрана и выбираем пункт «Системные настройки».

В системных настройках ищем строку «Кулер» и опцию низкоуровневого управления кулером. На экране появится всплывающее окно с оповещением о перезагрузке. Ставим галочку в пункте «определить всё» и кликаем «ок». Затем выставляем настройки кулера вручную: выбираем постоянный режим, устанавливаем 95% и сохраняем изменения. Если при работе компьютера кулер работает слишком громко, можно снизить значение до 80–85%. Выбираем пункт «загружать настройки с Windows»

Снова открываем окно разгона видеокарты. Включаем опцию «низкоуровневое управление разгоном» и в выскочившем окошке указываем «определить всё». Теперь два ползунка активизировались, ими можно управлять. Двигаем ползунок, изменяющий частоту ядра. Повышаем частоту постепенно, с шагом 10%. Параллельно после каждого изменения тестируем. Если тест положительный, кликаем «ок» и применяем настройки. Открываем Everest и 3Dmark. Тестируем видеокарту с изменёнными настройками. В Everest проверяем температуру — она должна быть не больше 90%. Во время тестирования тщательно следим за экраном — если изображение начнёт искажаться (появляются так называемые артефакты), прекращайте тестирование и уменьшайте частоту на 15 МГц. Запускайте тест снова. Ровно те же операции производим при высоких показателях температуры.

С помощью тестов нам необходимо найти пороговую частоту, т.е. самое высокое значение, при котором артефакты не обнаруживаются. При нормальных результатах повышаем частоту снова и снова пока не увидим искажение картинки. Далее снижаем частоту на небольшое значение и удостоверяемся, что артефакты не появляются. Так мы нашли максимально рабочую частоту видеокарты. Отмечаем её значение на листе бумаги и кликаем в настройках на «сбросить все настройки».

Займёмся оптимизацией памяти. Суть разгона та же, как и при разгоне частоты. Постепенно увеличиваем значение на 10%, следим за температурой и искажениями изображений. Аналогично с пунктом 4 находим максимальное значение памяти, записываем его. Не изменяя максимального значения памяти, устанавливаем значение частоты на максимальную (частота, которую вы записали на листике). Кликаем «тест». Если тест положительный, начинаем само тестирование. Далее следует самый значительный этап. Очень внимательно проверяем наличие артефактов при тестировании. Если артефактов не наблюдается, разгон выполнен успешно и следует проверить его на практике, то есть непосредственно в играх. Правильный разгон должен ощутимо увеличить FPS. Если в тесте все же видны искажения, снижаем частоту памяти на 10 МГц и повторяем тест. В случае если даже многократное снижение частоты не помогает устранить появление артефактов, оставляем теперешнее значение частоты памяти и снижаем частоту ядра на 10 МГц. Один или два раза повторяем процедуру до устранения артефактов. Пробуем снова немного увеличить частоту памяти.

ВАЖНО. Вы можете сами подобрать программы для контроля и тестирования

Например, 3D mark считается своеобразным эталоном программ такого типа, однако существуют другие, которые, возможно облегчат вам жизнь. Например, программа OCCT не только тестирует видеопамять, а и сама отслеживает появление артефактов.

⇡#ZOTAC GeForce GTX 660: технические характеристики, комплект поставки

Семпл для тестирования GeForce GTX 660 предоставлен ZOTAC. В ассортименте этой компании есть разогнанная версия карты — GTX 660 AMP! Edition — и версия с частотами, близкими к референсу. Близкими — потому что ZOTAC и здесь не удержалась от маленького разгона GPU со штатных 980 до 993 МГц. В остальном все стандартно.

| ZOTAC GeForce GTX 660 Ti AMP! Edition | |

| Модельный номер | ZT-60901-10M |

| Основные компоненты | |

| GPU | GK104 |

| Число транзисторов, млн | 3 540 |

| Техпроцесс, нм | 28 |

| Тактовая частота GPU, МГц: Base Clock / Boost Clock | 993/1046 |

| Потоковые процессоры | 960 |

| Текстурные блоки | 80 |

| ROPs | 24 |

| Видеопамять: тип, объем, Мбайт | GDDR5, 2048 |

| Тактовая частота памяти: реальная (эффективная), МГц | 1502 (6008) |

| Ширина шины памяти, бит | 192 |

| Интерфейс | PCI-Express 3.0 x16 |

| Вывод изображения | |

| Макс. разрешение: цифр. / аналог. | 2560×1600 / 2048×1536 |

| Разъемы | 1 х DL DVI-I, 1 x DL DVI-D, 1 x HDMI, 1 x DisplayPort |

| Физические характеристики | |

| Макс. потребляемая мощность, Вт | НД |

| Габаритные размеры: ДхВхГ, мм | НД |

| Масса, г | НД |

| Гарантийный срок, лет | 2 |

| Средняя розничная цена, руб. | Нет данных |

Рекомендованная цена карты ZOTAC для российской розницы — 8 499 руб. Версия AMP! Edition должна стоить 8 999 руб.

Адаптер комплектуется скромным набором аксессуаров: бумажная документация, адаптер питания, переходник с интерфейса DVI-I на VGA и купон на игру Trackmania Canyon.

⇡#ZOTAC GeForce GTX 660: конструкция

Референсные варианты GTX 660 с виду сильно похожи на GTX 660 Ti и GTX 670. GTX 660 от ZOTAC, соответственно, выглядит как GTX 660 Ti и GTX 660 Ti AMP! Edition производства той же компании. Отличительный признак — система охлаждения открытого типа с двумя вентиляторами.

Однако по сравнению с системой охлаждения GTX 660 Ti AMP! Edition в кулере GTX 660 недостает одной теплотрубки.

Зато появилась небольшая пластина, которая отводит тепло от микросхем памяти на лицевой стороне платы. Микросхемы на задней поверхности обходятся без радиатора, да и один из передних чипов, вот смех, прикрыт пластиной только наполовину.

Отдельный радиатор предусмотрен для элементов системы питания. В отличие от того, как это было устроено в GTX 660 Ti и GTX 670, они расположены не у заглушки, а на более привычном месте в конце платы.

Набор видеовыходов такой же, что мы видели на всех старших картах Kepler: два порта Dual-Link DVI, полноразмерные HDMI и DisplayPort.

ZOTAC GeForce GTX 660: плата

PCB GTX 660, с одной стороны, и GTX 660 Ti и GTX 670 — с другой, несмотря на поверхностное сходство, имеют существенно различающийся дизайн. Как уже сказано, элементы системы питания распаяны в другом месте, и есть только один шестиконтактный разъем питания. Сама система питания упрощена и включает только четыре фазы для GPU (от контроллера ON Semiconductor NCP5392G) и одну — для видеопамяти (Anpec APL3516A).

Видеопамять набрана микросхемами Samsung K4620325FD-FC03 с номинальной эффективной частотой 6 ГГц. Раньше в референсных моделях Kepler нам встречалась только память Hynix.

Кристалл GPU заметно меньше, чем GK104, что и неудивительно: в нем на миллиард транзисторов меньше.

| GK106 | GK104 |

⇡#TXAA и Adaptive V-Sync

Как и остальные GPU в линейке, GK106 поддерживает все новые функции, которые принесла архитектура Kepler: шину PCI-E 3.0, графические возможности DirectX 11.1 и два новых эффекта, которые активно популяризирует NVIDIA: TXAA и Adaptive V-Sync.

TXAA — дальнейшее развитие идеи быстрого антиалиасинга после метода FXAA. Если FXAA представляет собой фильтр постобработки, который обнаруживает в готовом кадре ступенчатые края и размывает их, то в TXAA фильтр работает совместно с привычным аппаратным сглаживанием типа MSAA. Плюс еще один компонент — временной фильтр, привлекающий семплы пикселей из предшествующих кадров.

Лучшее качество сглаживания сейчас обеспечивает комбинация MSAA с отдельным применением SSAA на прозрачных текстурах. TXAA не может претендовать на эквивалентную замену этому методу, так как не только сглаживает ступенчатые края полигонов, но и все-таки немного размывает площади текстур (хотя далеко не так сильно, как FXAA). Однако если не приглядываться к деталям, то картинка в целом весьма качественная, да и падение FPS не столь велико, как в случае с комбо MSAA + SSAA. В варианте TXAA 1 заявлено более качественное сглаживание краев полигонов, чем при MSAA 8x, с потерей производительности на уровне MSAA 2x. TXAA 2 обеспечивает гораздо более высокое качество, чем MSAA 8x с затратами на уровне MSAA 4x. Особенно хорошо TXAA проявляет себя в динамических сценах, где эффективно устраняется привычное «шевеление» пикселов на краях объектов.

По той информации, которая сопровождала релиз GeForce GTX 680, метод TXAA независим от аппаратной платформы и распространяется среди разработчиков в виде набора библиотек. Тем не менее драйверы NVIDIA поддерживают TXAA только для GPU семейства Kepler. А о том, появится ли в будущем поддержка со стороны AMD, вообще ничего не известно.

Первой игрой, в которой внедрили TXAA, стала The Secret World. NVIDIA изготовила видеоролик с несколькими игровыми сценами, наглядно показывающий TXAA в динамике.

Другая функция, которая появилась вместе с Kepler, — Adaptive V-Sync. Мы уже кратко описывали ее сущность в обзоре GTX 680:

Зачем нам нужна вертикальная синхронизация? Чтобы устранить разрывы изображения при смене кадров, которые особенно часто возникают в случае, если FPS превышает частоту вертикальной развертки дисплея. А почему вертикальную синхронизацию так редко используют? Потому что, если FPS меньше частоты развертки, VSync приводит его к половине или четверти частоты, например 30 и 15 FPS. Возникают тормоза. Чтобы устранить этот недостаток, NVIDIA предложила простое решение: если FPS больше частоты развертки, то VSync работает, а когда падает ниже, VSync отключается. Эта функция совместима и с картами GeForce предыдущего поколения.

⇡#Выводы

GPU GK106 стал ценным дополнением к линейке Kepler. Как и GK104, новый процессор оказался весьма эффективным по соотношению TDP и производительности. В большинстве игр GTX 660 может легко заменить гораздо более горячий и прожорливый GeForce GTX 570 или Radeon HD 6970 и подчас наступает на пятки GTX 580. Самая близкая по энергопотреблению карта из серии AMD Southern Islands, Radeon HD 7850, по результатам всех бенчмарков, также не может конкурировать с GTX 660. Как и старшие карты на платформе Kepler, GTX 660 хорошо разгоняется, хотя практическая ценность разгона адаптеров этой ценовой категории и невелика.

С сугубо практической точки зрения GeForce GTX 660 представляет собой такой видеоадаптер, который за относительно небольшие деньги позволит играть в современные игры с максимальными настройками в разрешении 1920х1080, не чувствуя дефицита производительности.

Благодаря более компактному GPU, GTX 660 наверняка обходится дешевле в производстве, чем GTX 660 Ti, и если реальные цены карт в российской рознице не будут сильно отличаться от рекомендованной цены 8,5 тыс. руб., то у новинки есть шанс стать весьма выгодной покупкой в своей ценовой категории. За такую же сумму можно купить Radeon HD 6970, GeForce GTX 570 или недорогие варианты Radeon HD 7870. Первые две карты покупать нет никакого смысла ввиду более низкой производительности и гораздо более высокого TDP. Но и для HD 7870 GTX 660 представляет серьезную угрозу, так как при заметно меньшем энергопотреблении и габаритах он во многих тестах показывает равный, а подчас и более высокий уровень производительности.

Заключение

Надеемся, что наша статья была вам понятна и интересна, а также помогла разобраться в линейках и маркировках видеокарт от NVIDIA. Если возникли вопросы и несостыковки, то сначала загляните в Введение, если проблема не разрешилась и вопросы остались, то милости просим в комментарии!

Выбор видеокарты – непростое занятие, так как производители выпускают устройства в большом количестве. Сориентироваться во всем этом многообразии непросто, даже если графические ускорители отличаются друг от друга только буквенной маркировкой, они могут иметь существенную разницу в производительности.

Сегодня мы ответим на вопрос, что значит Ti в видеокартах Nvidia, расскажем о других буквенных обозначениях и характеристиках.

Вывод

Итак, вот мы и познакомились с флагманской Maxwell-видеокартой. После тестирования GeForce GTX 980 я получил множество ответов, но появились и дополнительные вопросы. Но сначала начну с фактов.

Видеокарта получилась быстрой. По уровню производительности ее можно поставить на уровень между GeForce GTX 780 и кастомными GeForce GTX 780 Ti. Как показало тестирование, первую она опережает прилично — на 20–30%. От второй отстает совсем чуть-чуть — на 5–10%. При этом главная цель — быть быстрее Radeon R9 290X — достигнута. В принципе, всё логично, если учитывать рекомендованную стоимость в размере 24 000 рублей.

С другой стороны, получается, что среди референсных образцов GeForce GTX 980 можно считать самой быстрой одночиповой игровой видеокартой в портфолио NVIDIA. В то же время «девятьсот восьмидесятая» не претендует на лавры, например, . Хотя бы потому, что у нее урезана поддержка двойной точности вычислений с плавающей запятой.

И все же в плане производительности GeForce GTX 980 не удивляет. Ведь кастомные модели GeForce GTX 780 Ti работают даже чуточку быстрее.

Еще выход GeForce GTX 750 Ti продемонстрировал, насколько энергоэффективной оказалась архитектура Maxwell. GeForce GTX 980 тоже подтвердила мои ожидания. Это невообразимо, но 165-ваттная видеокарта действительно работает эффективнее 290-ваттной Radeon R9 290X! В этом плане GeForce GTX 980 — уникальный продукт. Поэтому я присуждаю устройству награду «Лучший дизайн» в знак того, насколько энергоэффективным оказался GPU GM204. Да и сама видеокарта — холодная и очень тихая. В общем, сбалансированная.

Посмотрим на ситуацию под другим углом. В России вопрос экономии электроэнергии стоит не так остро. Поэтому при покупке компьютерного железа на данный аспект смотрят далеко не в первую очередь. И стоит ли в таком случае переплачивать за небольшой рост производительности по отношению к Radeon R9 290X? Напомню: кастомизированную версию видеокарты «красных» можно приобрести где-то за 21 000 рублей.

Технологиям, представленным вместе с новинками, надо дать время на адаптацию. На бумаге применение нового типа антиалиазинга (пока еще находящегося на стадии разработки), а также технологии Dynamic Super Resolution, выглядит рациональным и привлекательным. Интересно смотрятся и фишки, реализованные вместе с Ubisoft. Посмотрим, как окажется на практике.

Важно, на мой взгляд, другое. Что AMD, представившая низкоуровневый API Mantle, что Microsoft, анонсировавшая DirectX 12, что NVIDIA со своими MFAA и VGXI — все вязли курс на улучшение быстродействия и улучшение оптимизации компьютерных игр

Наконец-то!

Видно, что NVIDIA не спешит раскрывать все козыри. К тому же жизненный цикл топовых видеокарт GeForce GTX 780, GeForce GTX 780 Ti и GeForce GTX TITAN (BLACK) не закончен. Не хочу быть голословным, но не удивлюсь, если в следующем году калифорнийская компания продемонстрирует миру и 250-ваттный Maxwell. И вот эту видеокарту можно будет назвать по-настоящему флагманом девятисотой линейки.

Интересно проследить за реакцией AMD на выход GeForce GTX 980. Первая же мысль — снижение цен на Radeon R9 290 и Radeon R9 290X (хотя последняя и так стоит заметно дешевле). Но мы-то ждем чего-нибудь новенького. Не зря же в последнее время с геометрической прогрессией разрастаются слухи вокруг Radeon R9 390X.