⇡#Производительность: вычисления

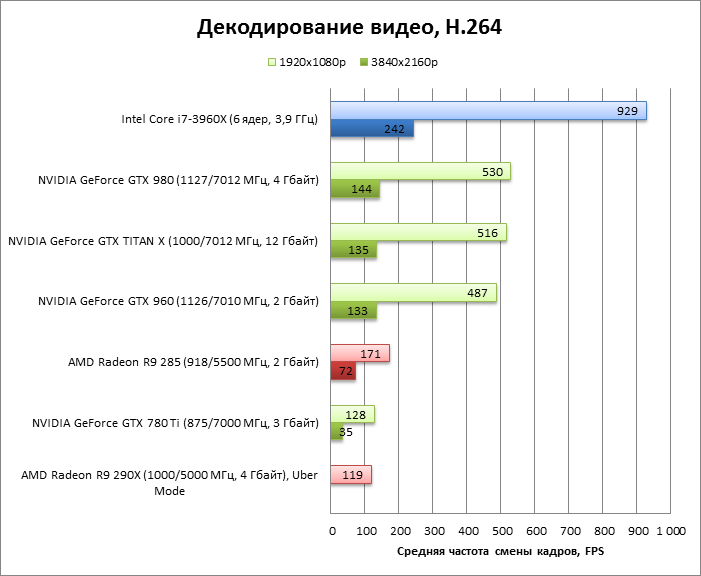

Декодирование видео (DXVA Checker, Decode Benchmark)

- Выделенный декодер H.264 в GM200 такой же, как и в других чипах семейства Maxwell. Производительности его более чем достаточно для воспроизведения видео с разрешением вплоть до Ultra HD и частотой смены кадров 60 Гц и выше.

- Среди дискретных видеоадаптеров AMD подобным может похвастаться только Radeon R9 285. GeForce GTX 780 Ti способен выдать до 35 FPS при разрешении 3840 × 2160.

- CPU с 6-8 ядрами x86 лучше подходят для быстрого декодирования с целью конвертации видео, однако блок фиксированной функциональности выполняет эту работу с меньшим энергопотреблением, да и, наконец, просто дается в нагрузку к мощнейшему GPU.

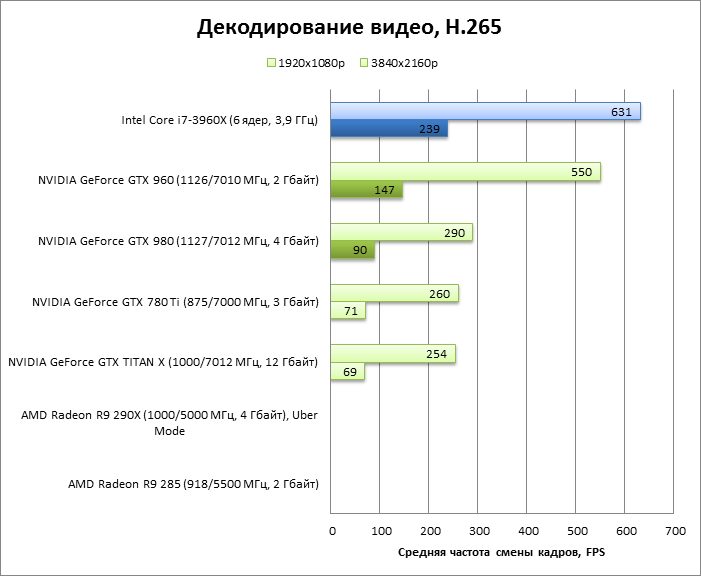

- Единственным GPU с полностью аппаратным декодированием H.265 является GM206 в составе GeForce GTX 960. Остальные представители архитектуры Maxwell, а также Kepler часть операций выполняют на конвейере декодера H.264. Остальное ложится на центральный процессор.

- Производительности всех этих адаптеров при хорошем CPU вполне достаточно для воспроизведения видео с любым разумным разрешением и частотой смены кадров. Для работы на скорость лучше подходит GTX 960 или мощный CPU.

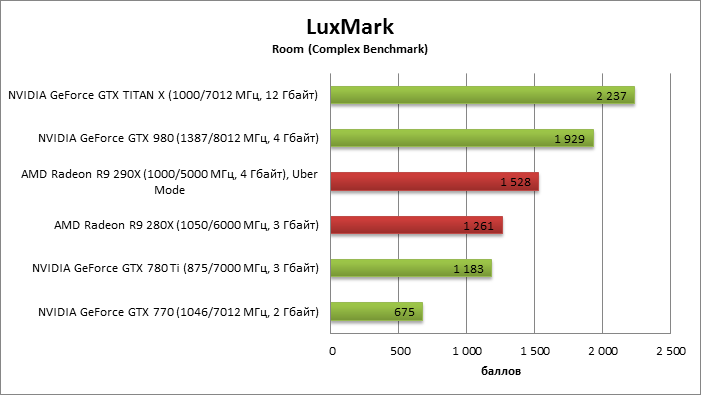

Luxmark: Room (Complex Benchmark)

- Архитектура Maxwell в этой задаче демонстрирует удивительный прирост производительности по сравнению с Kepler, благодаря чему TITAN X удвоил скромный результат GeForce GTX 780 Ti и оставил далеко позади Radeon R9 290X. Впрочем, это еще не значит, что результаты LuxMark репрезентативны относительно любых задач трассировки лучей.

- Разница между TITAN X и GeForce GTX 980 не такая огромная, как в игровых тестах.

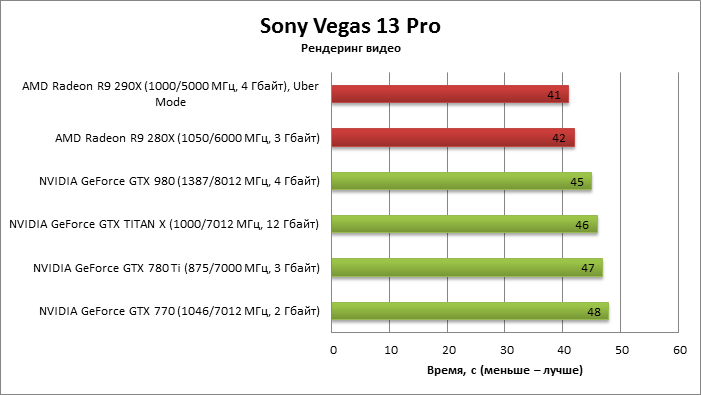

Sony Vegas Pro 13

Видеоадаптеры AMD сохраняют лидерство в задаче рендеринга видео. А TITAN X ничем не выделяется в группе наиболее производительных устройств NVIDIA.

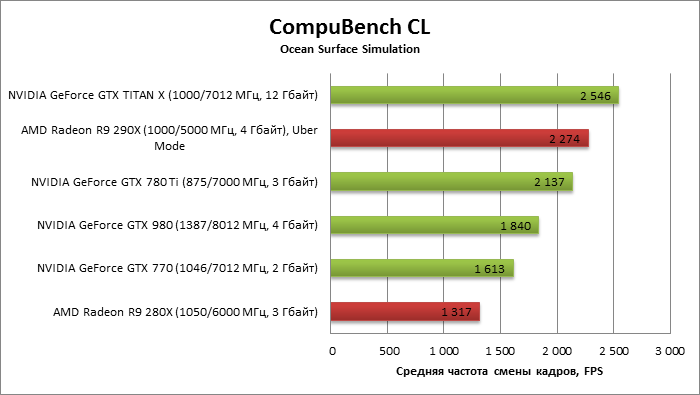

CompuBench CL: Ocean Surface Simulation

TITAN X отнимает пальму первенства у Radeon R9 290X и компенсирует неудачу GeForce GTX 980, которому этот тест дается на удивление трудно.

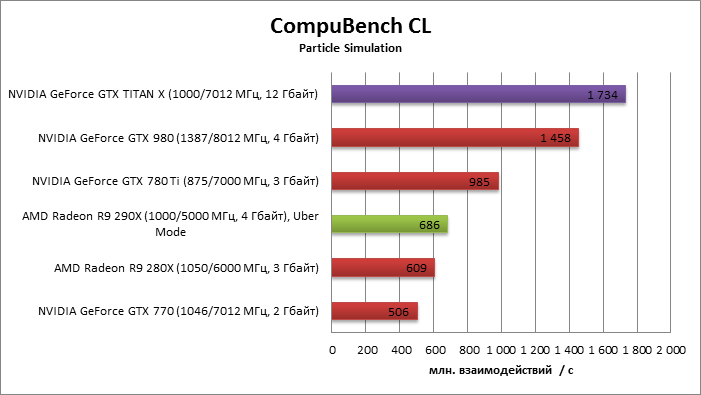

CompuBench CL: Particle Simulation

Здесь, напротив, GTX 980 сделал большой шаг вперед от GTX 780 Ti, а TITAN X закрепил успех. Radeon R9 290X не идет ни в какое сравнение с флагманом NVIDIA.

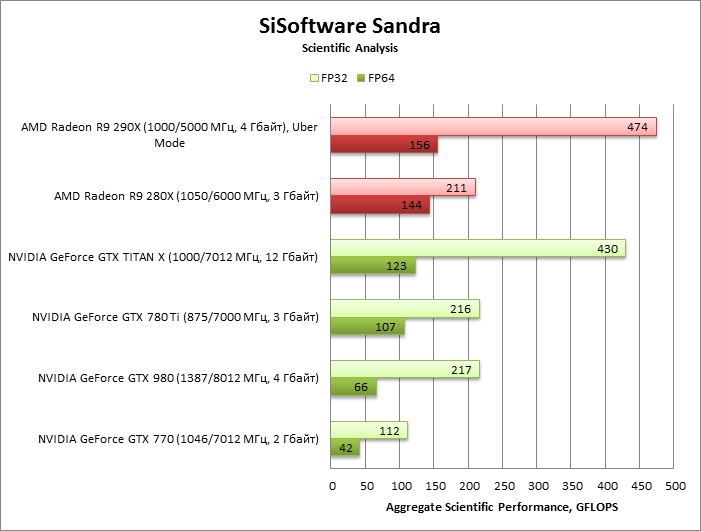

SiSoftware Sandra 2020: Scientific Analysis

- В условиях двойной точности (FP64) ускорители AMD по-прежнему не знают равных, и даже Radeon R9 280X на базе далеко не нового GPU может дать фору TITAN X.

- Среди «зеленых» TITAN X предсказуемо лидирует по производительности в FP64, в особенности по сравнению с откровенно слабым GTX 980.

- В вычислениях FP32 TITAN X резко выделяется из всех видеокарт NVIDIA. Лишь она обеспечивает уровень производительности, сопоставимый с таковым у Radeon R9 290X.

⇡#Производительность: синтетические тесты

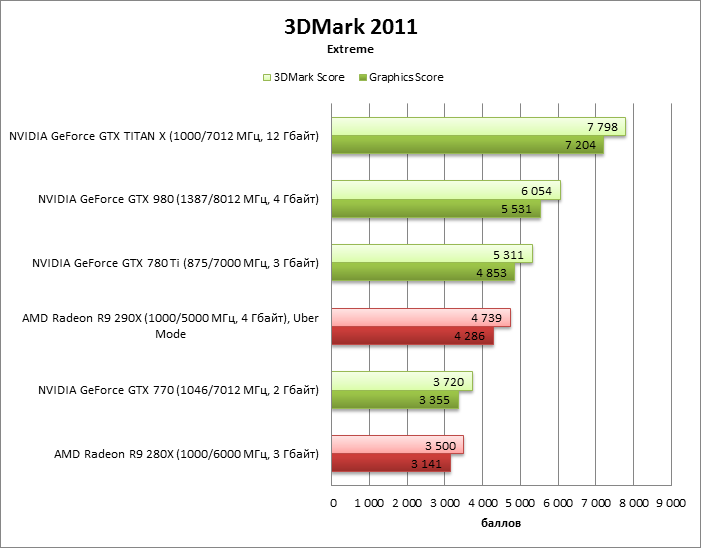

3DMark 2011

- TITAN X впечатляет с первого же теста. По сравнению с GTX 780 Ti и Radeon R9 290X видеокарта в полтора раза производительнее.

- С Radeon R9 280X и GeForce GTX 770 — адаптерами на базе некогда топовых GPU — разница более чем двукратная.

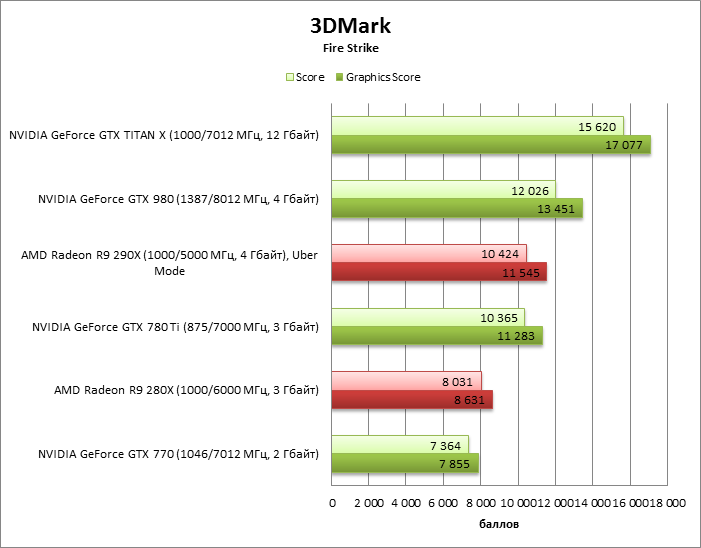

3DMark

Все вышесказанное справедливо и для 3DMark 2013 года.

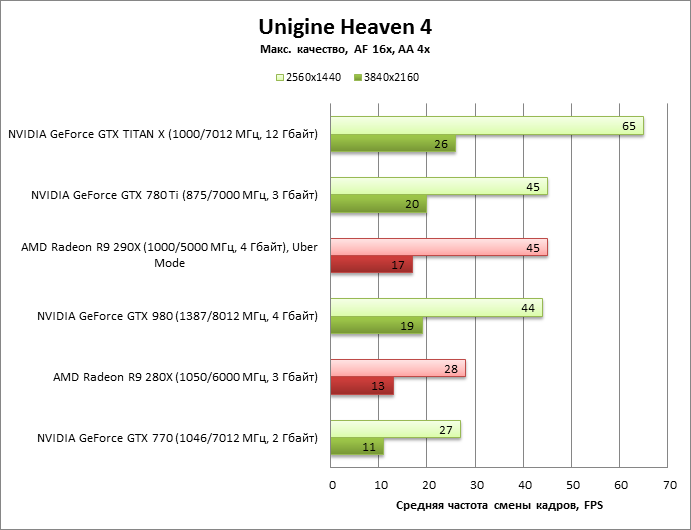

Unigine Heaven 4

- TITAN X сохраняет преимущество около 50% перед GTX 780 Ti и Radeon R9 290X при разрешении WQHD. Кстати, в отличие от 3DMark, GTX 980 в этом тесте ничуть не лучше GTX 780 Ti.

- При разрешении Ultra HD ранее выпущенные видеоадаптеры сократили расстояние, и все же TITAN X на голову превосходит всех соперников.

Строение GTX 690

Уж не знаю, что побудило NVIDIA выпустить двойной тандем в столь короткие сроки: верхние позиции отвоеваны силами GTX 680, скорых анонсов более быстрых решений у конкурента не предвидится. Вот бы ещё в средний сектор подбавить решений на базе свежей архитектуры — судя по прогрессу, достигнутому NVIDIA при разработке Kepler, его обрезанные решения с ещё более «холодным нравом» и замечательной производительностью могли бы потеснить семитысячные решения в наиболее интересующем пользователей среднем ценовом сегменте.

А тут — 690-я, которая сама по себе является сложным (а значит, дорогим) решением, и предназначается для хардкорных геймеров. Тем более, что в прошлом подобные решения давались компании не без труда. Чего только стоит переход с двухплатного решения на одноплатное, которое случилось уже на закате линейки 2хх. Правда, 590-я была удачнее предшественницы, однако холодной её назвать язык не поворачивался. Многие из тех, кому довелось опробовать эти карты в деле, заговаривали о пользе жидкостного охлаждения для таких решений. У «красных» проблемы были примерно те же — значительное энергопотребление, высокие рабочие температуры… В общем, при проектировании таких решений перед производителями встает непростая задача: ужать до размеров одной платы в два раза больше элементов, организовать отвод и рассеивание огромного количества тепла, сделать это решение конкурентоспособным и доступным для покупателя. Видимо, окрыленная успехом GTX 680 (который, кстати, отличался вполне умеренными аппетитами), NVIDIA рискнула представить решение с двумя графическими процессорами.

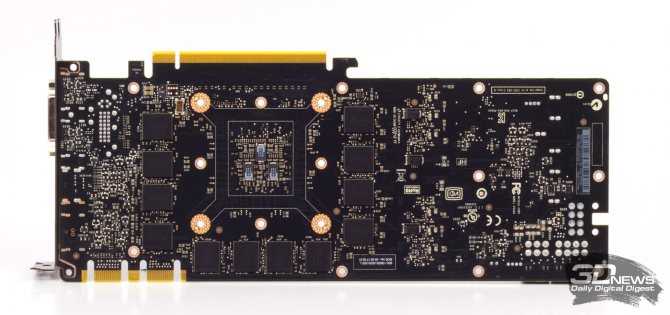

⇡#Плата

Дизайн печатной платы, что совершенно неудивительно, вызывает ассоциации с серией видеоадаптеров на чипе GK110. Преобразователь напряжения построен по схеме 6+2 (число фаз для питания GPU и микросхем памяти соответственно). Питание подается через один восьмиконтактный и один шестиконтактный разъем. А вот контроллер питания графического процессора ON Semiconductor NCP81174 мы здесь видим впервые.

24 микросхемы памяти SK hynix H5GQ4H24MFR-R2C со штатной частотой 7 ГГц расположены на обеих сторонах платы.

NVIDIA GeForce GTX TITAN X, печатная плата, передняя сторона

NVIDIA GeForce GTX TITAN X, печатная плата, задняя сторона

Тестовый стенд, методика тестирования

| Конфигурация тестовых стендов | |

| CPU | Intel Core i7-5960X @ 4 ГГц (100 × 40) |

| Материнская плата | ASUS RAMPAGE V EXTREME |

| Оперативная память | Corsair Vengeance LPX, 2133 МГц, 4 × 4 Гбайт |

| ПЗУ | Intel SSD 520 240 Гбайт |

| Блок питания | Corsair AX1200i, 1200 Вт |

| Охлаждение CPU | Thermalright Archon |

| Корпус | CoolerMaster Test Bench V1.0 |

| Операционная система | Windows 8.1 Pro X64 |

| ПО для GPU AMD | AMD Catalyst Omega 14.12 |

| ПО для GPU NVIDIA | 347.52 |

Энергосберегающие технологии CPU во всех тестах отключены. В настройках драйвера NVIDIA в качестве процессора для вычисления PhysX выбирается CPU. В драйверах AMD параметр Tesselation переводится из состояния AMD Optimized в Use application settings.

| Бенчмарки: синтетические | |||

| Программа | Настройки | Анизотропная фильтрация, полноэкранное сглаживание | Разрешение |

| 3DMark 2011 | Тест Extreme | – | – |

| 3DMark | Тест Fire Strike (не Extreme) | – | – |

| Unigine Heaven 4 | DirectX 11, макс. качество, тесселяция в режиме Extreme | AF 16x, MSAA 4x | 1920 × 1080 / 2560 × 1440 |

| Бенчмарки: игры | |||

| Программа | Настройки | Анизотропная фильтрация, полноэкранное сглаживание | Разрешение |

| Far Cry 3 + FRAPS | DirectX 11, макс. качество, HDAO. Начало миссии Secure the Outpost | AF, MSAA 4x | 2560 × 1440/3840 × 2160 |

| Tomb Raider. Встроенный бенчмарк | Макс. качество | AF 16x, SSAA 4x | 2560 × 1440/3840 × 2160 |

| Bioshock Infinite. Встроенный бенчмарк | Макс. качество. Postprocessing: Normal | AF 16x, FXAA | 2560 × 1440/3840 × 2160 |

| Crysis 3 + FRAPS | Макс. качество. Начало миссии Post Human | AF 16x, MSAA 4x | 2560 × 1440/3840 × 2160 |

| Metro: Last Light. Встроенный бенчмарк | Макс. качество | AF 16x, SSAA 4x | 2560 × 1440/3840 × 2160 |

| Company of Heroes 2. Встроенный бенчмарк | Макс. качество | AF, SSAA 4x | 2560 × 1440/3840 × 2160 |

| Battlefield 4 + FRAPS | Макс. качество. Начало миссии Tashgar | AF 16x, MSAA 4x + FXAA | 2560 × 1440/3840 × 2160 |

| Thief. Встроенный бенчмарк | Макс. качество | AF 16x, SSAA 4x + FXAA | 2560 × 1440/3840 × 2160 |

| Alien: Isolation | Макс. качество | AF 16x, SMAA T2X | 2560 × 1440/3840 × 2160 |

| Бенчмарки: вычисления | |

| Программа | Настройки |

| DXVA Checker | Decode benchmark. H.264, H.265. Файлы 1920 × 1080p (битрейт видео ~3000 Кбит/с), 3840 × 2160p (битрейт видео ~7500 Кбит/с). Microsoft H264 Video Decoder (H.264), LAV Video Decoder (H.265), ускорение на аппаратном кодеке GPU (DXVA2) |

| LuxMark 2.0 X64 | Сцена Room (Complex Benchmark) |

| Sony Vegas Pro 13 | Бенчмарк Sony для Vegas Pro 11, продолжительность — 65 с, рендеринг в XDCAM EX, 1920х |

| CompuBench CL Desktop Edition X64, Ocean Surface Simulation | — |

| CompuBench CL Desktop Edition X64, Particle Simulation — 64K | — |

| SiSoftware Sandra 2020, Scientific Analysis | Open CL, FP32/FP64 |

Участники тестирования

В тестировании производительности приняли участие следующие видеокарты:

- NVIDIA GeForce GTX TITAN X (1000/7012 МГц, 12 Гбайт);

- AMD Radeon R9 290X (1000/5000 МГц, 4 Гбайт), Uber Mode;

- NVIDIA GeForce GTX 980 (1127/7012 МГц, 4 Гбайт);

- NVIDIA GeForce GTX 780 Ti (875/7000 МГц, 3 Гбайт);

- NVIDIA GeForce GTX 770 (1046/7012 МГц, 2 Гбайт).

Железный цех №38: какую видеокарту купить в 2016 году

AMD и NVIDIA отстрелялись. В будущем нас ждут еще видеокарты поколений Polaris и Pascal, но основная обойма выпущена. Самое главное — дефицит закончился, цены на новинки устаканились. Определяемся, какие модели нам подойдут, а также выбираем наиболее интересные и доступные варианты.

В этом году, точнее, этим летом AMD и NVIDIA на двоих выпустили восемь видеокарт, разместившись тем самым во всех ценовых категориях. Некоторые адаптеры заметно подняли планку производительности в компьютерных играх. Это GeForce GTX 1080 и Titan X. Другие 3D-ускорители серьезно снизили так называемую «стоимость за FPS». Это GeForce GTX 1060 и Radeon RX 480. Во всех случаях игровые видеокарты стали лучше. Переход на новые техпроцессы — 14 нм для Polaris и 16 нм для Pascal — снизил уровень энергопотребления продукции. Новые видеокарты стали холоднее, тише и дешевле. На мой взгляд, сейчас отличное время, чтобы обновить свою старую систему или же собрать новый игровой десктоп.

Простой и практичный дизайн

В противоположность таким производителям игровых ноутбуков, как Asus и Predator, компания Lenovo в своем Legion Y740-17ICHg делает ставку в принципе на простой и сдержанный дизайн. Большая часть корпуса имеет гладкую поверхность в цвете «титан». Только вентиляторы, напоминающие промышленные радиаторы, говорят о том, что перед нами игровой ноутбук. О это же указывают, естественно, пестрая RGB-подсветка клавиатуры и вентиляционные отверстия.

Отличительной чертой является смещенный вперед дисплей, из-за чего корпус получается сдвинутым на пару сантиметров вперед. При разработке конструкции Legion Y740-17ICHg компания Lenovo решила разместить большую часть интерфейсов на задней панели, а не сбоку. Эти разъемы практично отмечены подсвечиваемыми символами, поэтому вы найдете нужный интерфейс без особых усилий. Такое расположение разъемов обеспечивает больший порядок с проводами, когда ноутбук находится стационарно на письменном столе. Но при мобильном использовании, однако, может быть удобнее, если разъемы находятся на боковых сторонах. Таким образом, подобный дизайн имеет свои как преимущества, так и недостатки. Качество материалов при этом превосходное.

В работе

Устанавливая топовую двухчиповую видеокарту, подсознательно готовишься к тому, что сейчас все начнет шуметь и греться. На практике с GeForce GTX 690 такого не происходит.

Во время работы на открытом стенде в режиме покоя графические процессоры прогрелись всего до 28 С. Вентилятор на 1150–1200 об/мин работает очень тихо. После хорошей игровой нагрузки в нашем случае температура GPU повысилась всего до 71 градуса, а скорость вращения вентилятора приблизилась к 2000 об/мин. Шум, издаваемый системой охлаждения увеличился, но если сравнивать его с таковым, издаваемым референсным кулером GeForce GTX 680, то эти величины сопоставимы. Пара одночиповых видеокарт определенно будут несколько голосистее одной GTX 690.

Общая эффективность системы охлаждения, конечно, впечатляет. Однако условия окружающей среды на открытом стенде и в корпусе заметно отличаются

Потому еще раз акцентируем внимание на организации принудительного вывода нагретого воздуха за пределы системного блока. Как минимум, один 120-миллиметровый вентилятор на задней стенке корпуса, работающий на выдув, в данном случае точно не будет лишним

Говоря о нюансах работы видеокарты, следует отметить частотные особенности графического ядра. Алгоритм работы динамического разгона GPU Boost в данном случае весьма агрессивен. Учитывая то, что штатным значением является 915 МГц, даже при плотной нагрузке чип «выстреливал» до 1058 МГц. Заявленные же производителем 1019 МГц скорее являются неким промежуточным значением. В действительности дельта может составлять более 140 МГц, но, опять же, величина эта не постоянная и варьируется в зависимости от нагрузки, нагрева и уровня энергопотребления.

⇡#Тактовые частоты, энергопотребление, температура, разгон

GM110 работает на базовой частоте, до которой никогда не поднимался GK110 в референсных спецификациях. Кроме того, GPU Boost действует весьма агрессивно, поднимая частоту вплоть до 1177 МГц. При этом процессор довольствуется напряжением 1,174 В — более низким относительно топовых продуктов на базе GK110.

Настройки BIOS позволяют увеличить лимит мощности до 110% и добавить 83 мВ к максимальному напряжению на GPU. На деле напряжение поднимается только до 1,23 В, но одновременно открываются несколько дополнительных ступенек частоты/VID: разница между базовой частотой и максимальной частотой, зарегистрированной в динамике, возрастает до 203 МГц.

Разгон видеокарты позволил достигнуть базовой частоты в 1252 МГц, а в динамике наблюдались частоты вплоть до 1455 МГц. Видеопамять смогла прибавить 1,2 ГГц, успешно работая на эффективной частоте 8 212 МГц.

| Base Clock, МГц | Макс. Boost Clock, МГц | Base Clock, МГц (разгон) | Макс. зарегистрированная Boost Clock, МГц (разгон) | |

| GeForce GTX TITAN X | 1000 | 1177 (+177) | 1252 | 1455 (+203) |

| GeForce GTX 980 | 1127 | 1253 (+126) | 1387 | 1526 (+139) |

| GeForce GTX TITAN Black | 889 | 1032 (+143) | 1100 | 1262 (+162) |

| GeForce GTX TITAN | 836 | 1006 (+145) | 966 | 1150 (+184) |

| GeForce GTX 780 Ti | 876 | 1020 (+144) | 986 | 1130 (+144) |

| GeForce GTX 780 | 863 | 1006 (+143) | 1053 | 1215 (+162) |

| GeForce GTX 770 | 1046 | 1176 (+130) | 1190 | 1333 (+143) |

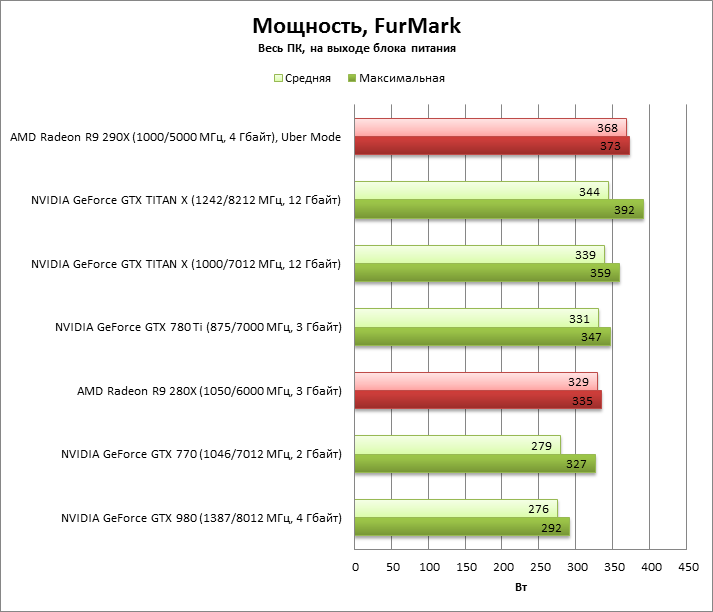

По энергопотреблению TITAN X близок к GTX 780 Ti и намного превосходит GTX 980. Вопреки ожиданиям, в Crysis 3 нет существенной разницы между TITAN X и Radeon R9 290X, а вот в FurMark R9 290X (как и R9 280X) разогревается сильнее и заметно превосходит TITAN X.

Разгон TITAN X увеличивает мощность на 5-25 Вт в зависимости от того, на результаты какого теста опираться — FurMark или Crysis 3.

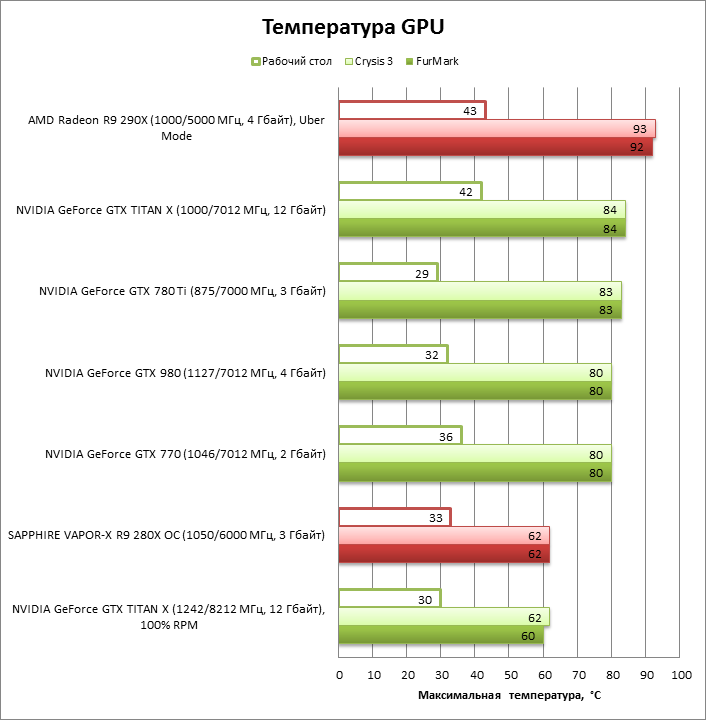

Максимальная температура, которая допустима для GPU, определяется настройками BIOS, поэтому TITAN X не выходит за рамки установленных 83° C. При этом турбина системы охлаждения раскручивается на 49% от максимальной скорости — до 2339 об/мин. На первый взгляд это довольно много, но на самом деле шум от кулера вполне приемлемый.

Результаты тестирования

В отсутствии реального конкурента в лице двухчиповой модели от AMD с парой GPU Tahiti XT, превосходство GeForce GTX 690 над любой видеокартой с одним графическим процессором не вызывает сомнений. Мы провели ряд практических тестов, чтобы оценить насколько велико преимущество новинки и оправдывает ли она свою цену. Специально для техногурманов также включены результаты замеров производительности связки Quad SLI.

Неудивительно, что синтетические приложения, предназначенные для оценки производительности платформ, чутко реагируют на изменение возможностей конфигураций. В обоих пакетах от Futuremark двухчиповая новинка имеет серьезное преимущество над GTX 680 – 65–75%. Использование второй GTX 690 приносит дополнительные 45% «попугаев» в 3DMark Vantage. Последняя версия пакета получше оптимизирована, возможности графической подсистемы более весомы в общем результате. Потому Quad SLI приносит 81%-ную прибавку скорости.

В Heaven Benchmark 2.5 двухголовая видеокарта, в зависимости от разрешения, имеет преимущество в 83–91% над GTX 680. Вторая видеокарта в режиме Full HD приносит дополнительные 59%, а при 2560×1440 – порядка 77%.

Если ситуация в синтетике представляет чисто академический интерес, то вот тесты в реальных играх переводят исследование в практическую плоскость. Весьма технологичных шутер Lost Planet 2 как-то без энтузиазма воспринял увеличение количества графических процессоров. И если GTX 690 еще имеет ощутимое преимущество (23–58%) над GTX 680, то использование второй двухчиповой видеокарты приносит очень и очень скромные 9–16%.

Одному из самых ненасытных пожирателей системных ресурсов – игре Metro 2033 – режимы SLI нравятся в любом виде и количестве. 56–63% – таково преимущество GTX 690 над GTX 680. Вторая двухчиповая видеокарта приносит еще 66% в режиме с высоком разрешением. Наконец-то уже можно собрать конфигурацию, которая позволит комфортно поиграть в детище 4A Games с максимальным качеством на мониторах 27–30”. В 1920×1080 количество кадров/c увеличилось на 31%. Очевидно здесь уже сказывается возможности центрального процессора.

Dirt3 заметно оживился после установки двухчиповой GeForce GTX 690 (+46-74% к результатам GTX 680), а вот с Quad SLI достойно совладать не сумел, даже в высоком разрешении (+14%). Здесь скорее сказывается особенность игрового движка, потому как в 1920х1080 полученная разница с результатами для GTX 680 была даже выше – порядка 18%, что в целом не характерно для других приложений.

Aliens vs. Predator оказалась едва ли не эталоном эффективного использования ресурсов графической подсистемы в реальных условиях. В данном случае GTX 690, графические чипы которого работают на меньшей частоте, чем у GTX 680, но их два, вместо одного, смогла на 90–92% опередить последнего. Ну, а когда две GTX 690 работают в паре, скорость отрисовки кадров возрастает еще на 74–82%. Если же сравнивать результаты платформы с Quad SLI и одной GeForce GTX 680, то их производительность отличается в 3,5 раза.

На первый взгляд не слишком притязательная к ресурсам Mafia II также с благосклонностью относится к увеличению числа GPU – GeForce GTX 690 опережает одночипового флагмана NVIDIA на 63–75%. Quad SLI приносит 56%-ную прибавку в 2560х1440, а вот в разрешении Full HD прирост уже не столь убедительный – всего 16%. С другой стороны, нужен ли он при 150 кадрах/c, вопрос риторический.

Говоря о производительности двухчиповой видеокарты, следует помнить о том, что мы имеем дело с SLI-режимом работы GPU. В этом случае скоростные показатели очень сильно зависят от программной оптимизации, как игровых движков, так и драйверов. NVIDIA активно работает с разработчиками и оперативно оптимизирует свое ПО

Энергопотребление системы с GeForce GTX 690 во время хорошей игровой нагрузки оказалось примерно на 130 Вт выше, чем у идентичной платформы c GeForce GTX 680. С одной стороны, разница ощутимая, с другой – такая конфигурация очевидно будет экономичнее ПК с парой GeForce GTX 680, работающих в SLI-режиме. Системе с разогнанным до 4,5 ГГц процессором Core i7-3770K и Quad SLI потребуется порядка 800 Вт, а если платформа собрана с щестиядерным CPU или топовыми чипами AMD, то энергопотребление будет еще выше. Это стоит учитывать при выборе БП.

GeForce GTX 690

Очередной носитель архитектуры NVIDIA, основанный на двух чипах GK 104, в общей сложности имеет 3072 потоковых вычислителя CUDA. Базовая частота GPU – 915 МГц, при этом GPU Boost позволяет ядрам динамически ускоряться более чем на 100 МГц – до 1019 МГц. Отметим, что тактовые частоты графических процессоров, хотя и ниже, чем у такового для GeForce GTX 680, но отличие не столь велико, к тому же модель с двумя GPU использует более агрессивный алгоритм динамического ускорения.

Видеокарта оснащена 4 ГБ памяти GDDR5, которая работает на 6008 МГц. Каждому чипу доступны 2 ГБ, которые связаны с соответствующими процессорами 256-битовой шиной. Для подключения дополнительного питания понадобится два 8-контактных разъема. Заявленный уровень TDP сравнительно невелик, как для двухчипового решения – 300 Вт. При этом требования к мощности блока питания также довольно скромные: системе с GeForce GTX 690 будет достаточно 650-ваттного БП. Как и остальные адаптеры с чипами на Kepler, видеокарта готова к работе с PCI Express 3.0, пропускная способность которой вдвое выше, чем у шины предыдущего стандарта. Напомним, что для функционирования в режиме 3.0, новую версию интерфейса должны поддерживать процессор, в котором собственно содержится сам контроллер, материнская плата, а также видеокарта.

Дизайнеры отлично поработали над экстерьером видеокарты. Для верхней крышки применяется не традиционный для этого элемента пластик, а хромированный алюминий. При этом кожух адаптера не является цельным, через поликарбонатные окна можно увидеть радиаторные кассеты c набором пластин. Видеокарта выглядит очень стильно и эффектно.

Интерфейсная панель содержит три разъема DVI DL (2хDVI-I и DVI-D) и один Mini DisplayPort 1.2, каждый из которых может выводить картинку с разрешением до 2560х1600. Как и одночиповые модели на GK104, GeForce GTX 690 позволяет одновременно использовать четыре монитора. Часть крепежной пластины занимает решетка для выхлопа нагретого воздуха.

С обратной стороны адаптера в защитном кожухе предусмотрена рама, также предназначенная для вывода воздуха. В этот раз он будет уже поступать внутрь системного блока, потому подумать о дополнительной вентиляции системы не помешает.

На верхней кромке нанесена надпись «GEFORCE GTX», которая подсвечивается во время работы видеокарты. В целом визуально видеокарта выглядит очень стильно и эффектно, в этом отношении разработчики отлично справились со своей задачей.

Не меньше внимания уделено и внутреннему убранству. Каркас системы охлаждения выполнен из магниевого сплава. В конструкции СО используется две испарительные камеры с наборами никелированных алюминиевых пластин. Радиатор продувается 90-миллиметровым вентилятором осевого типа, установленным в центральной части видеокарты. Особо отметим, что система охлаждения занимает два слота, не посягая на пространство, предназначенное для других плат расширения.

Печатная плата концептуально отчасти похожа на ту, что использовалась для двухчиповой видеокарты предыдущего поколения – GeForce GTX 590. В данном случае применяется 10-слойная PCB и низкопрофильные качественные компоненты. Силовая подсистема использует 10-фазную схему – по пять фаз для каждого GPU, а также две отдельные фазы для питания памяти. Согласование работы обоих графических ядер производится с помощью скоростного моста PLX PEX8747, имеющего пропускную способность, соответствующую спецификации PCI Express 3.0.

С обратной стороны печатной платы нет никаких защитных пластин. Силовые компоненты здесь отсутствуют, потому с практической точки зрения в подобных элементах нет необходимости.

На верхней кромке PCB, ближе к крепежной пластине, расположен разъем для подсоединения моста позволяющего объединить две подобные видеокарты. Отметим, что коннектор всего один, а не два, как у многих производительных решений с чипами от NVIDIA. По понятным причинам, пары GeForce GTX 690 достаточно, чтобы получить максимально возможную графическую конфигурацию Quad SLI.

Много дискового пространства и интерфейсов, а еще — пестрая RGB-подсветка

Относительно оснащения можно было бы сделать не так много больше, чем есть в Lenovo Legion Y740-17ICHg. Протестированная нами конфигурация включает в себя 512-гигабайтный SSD-накопитель и 1000-гигабайтный классический жесткий диск, то есть предлагает достаточно большое дисковое пространство. Три USB-3.0-интерфейса Type-A дополняют один Type-C-порт с поддержкой Thunderbolt-3-стандарта, вместе с тем и поддержкой DisplayPort. Два USB-разъема находятся на задней стороне устройства, еще по одному — на каждой из боковых сторон. Для подключения внешнего монитора имеется отдельный разъем Mini-DisplayPort. Также доступны для использования WLAN ac и Bluetooth 4.1. Как и у большинства других игровых ноутбуков, данная модель от Lenovo располагает гигабитным сетевым интерфейсом. Лишь недостающие «бонусные» пункты списка оснащения не позволили устройству получить в данной тестовой категории максимальную оценку.

Что касается управления RGB-подсветкой клавиатуры и других элементов, то с поиском у нас возникли некоторые проблемы. Данный функционал является частью не стандартного программного обеспечения Lenovo, а отдельного, предоставляемого компанией Corsair. Если об этом знать с самого начала, то потом можно управлять цветом каждого отдельно светодиода. Любители пестрых подсветок будут абсолютно довольны.

Итоги

На сегодняшний день GeForce GTX 690 – самая быстрая видеокарта в мире. О целесообразности покупки графического адаптера за $1000 можно дискутировать довольно долго. Конечно, ценник с тремя нулями серьезно ограничивает круг потенциальных владельцев GeForce GTX 690, но в том, что она найдет своего покупателя, нет никаких сомнений. Прежде всего, это достаточно обеспеченные энтузиасты, которым нужна максимально возможная производительность. Вряд ли откажутся от подобной видеокарты и владельцы конфигураций с несколькими крупноформатными мониторами. Сдвоенная модель приносит серьезный прирост производительности, который возрастает с увеличением разрешения и улучшением настроек качества картинки. Никаким разгоном видеокарты с одним GK104 добиться таких же результатов не удастся.

⇡#Выводы

Если учесть, что производство дискретных GPU все еще остается в рамках техпроцесса 28 нм, результаты GeForce GTX TITAN X выглядят просто фантастически. При таком же TDP, как у видеоадаптеров на базе GK110, TITAN X достигает 130-150% быстродействия таких ускорителей, как GTX 780 Ti и Radeon R9 290X. Если взять первые 28-нанометровые GPU — GK104 (GTX 680, GTX 770) и Radeon R9 280X, то TITAN X зачастую превосходит их в два раза.

TITAN X, как и его предшественники на этой позиции, чрезвычайно дорог для видеокарты на одиночном GPU. Позиционирование не изменилось по сравнению с предыдущими «Титанами». Во-первых, это альтернатива SLI-конфигурациям из двух дискретных GeForce GTX 980: пусть потенциальная производительность тандема выше, одиночный GPU обладает более предсказуемым быстродействием. Во-вторых, компактные ПК, в которых нет места для двух видеокарт. И наконец, неграфические вычисления (GP-GPU). Хотя производительность FP64 в GM200 ограничена 1/32 от производительности FP32, TITAN X отчасти компенсирует это ограничение грубой силой GPU. Кроме того, вычисления FP32 преобладают в «просьюмерской» нагрузке (тот же Ray Tracing, ускорение рендеринга видео), а в этой дисциплине GM200 по меньшей мере не уступает лучшим продуктам AMD, а часто и превосходит так же, как в игровых тестах.

Заключение

Преимущества:

Недостатки:

Мы уже немало писали о долгожданном выходе очередного семейства графических процессоров ATI — Radeon X1000. На деле же с их производительностью не все оказалось гладко, а доступность решений на новых чипах продолжает вызывать вопросы. Однако в NVIDIA весьма серьезно отнеслись к этой потенциальной угрозе, и по всем правилам военной тактики был нанесен упреждающий удар.

Удар стал поистине сокрушительным: в то время как ATI до сих пор развертывает свои боевые порядки (пытаясь наладить выпуск Radeon X1300 Pro/X1600 XT/X1800 XT в достаточных для удовлетворения потребностей рынка масштабах), NVIDIA с легкостью дополняет диспозицию новыми решениями. Речь идет о видеоплатах GeForce 6600 DDR2, GeForce 6800 GS и GeForce 7800 GTX 512MB. К сожалению, первая пока только ожидается в нашей Тестовой лаборатории, а вот о двух последних мы поговорим более предметно.

Итак, GeForce 7800 GTX 512MB

является тяжелой артиллерией компании — это флагманский продукт NVIDIA, призванный конкурировать с Radeon X1800 XT. Помимо удвоенного объема видеопамяти, эта плата отличается значительно повышенными по сравнению с 256-мегабайтовой версией GeForce 7800 GTX тактовыми частотами (для чего специально отбирались процессоры, способные работать в таком режиме). Также использована самая быстрая существующая на данный момент память со временем доступа 1,1 нс. В сумме эти факторы позволяют сегодня назвать GeForce 7800 GTX 512MB самой быстрой одночиповой видеокартой. Кроме того, возможность объединить две такие платы в SLI вообще снимает все вопросы относительно лидерства в high-end сегменте. Справедливости ради отметим, что доступность нового флагмана NVIDIA все же далека от желаемой, как и цена, очень сильно завышенная. Впрочем, для покупателей продуктов этого класса стоимость не имеет решающего значения.

GeForce 6800 GS

ведет свою родословную отпредыдущего поколения продуктов NVIDIA — он базируется на 0,11-микронном ядре NV42. Эта карта выпущена в качестве «противовеса» Radeon X1600 XT, и, как показывают тесты, с этой ролью успешно справляется. Для ее производства использованы печатная плата от 7800 GT и довольно мощная система охлаждения, что совсем не лишне, учитывая повышенные тактовые частоты, составляющие 425/1000 MHz для ядра и памяти соответственно. Чип имеет 12 пиксельных и 5 вершинных конвейеров. Судя по всему, видеокарты на его базе будут иметь значительную популярность до появления решений следующего поколения

Принимая во внимание все факторы, данная видеокарта обладает отличным соотношением цены и быстродействия в среднем классе. Что же касается доступности, то сам за себя говорит тот факт, что представленная на тестирование плата является серийно выпускаемым образцом компании MSI, хотя анонсирован GeForce 6800 GSбыл много позже Radeon X1600 XT

Результаты тестов в большинстве случаев демонстрируют превосходство новых продуктов NVIDIA над соперниками, что весьма показательно. Не следует забывать о том, что и GeForce 6600 DDR2 (убедительно противостоящий Radeon X1300 Pro), и GeForce 6800 GS являются представителями прошлого поколения продуктов, а решения среднего и бюджетного классов NVIDIA на базе новой «семитысячной» серии до сих пор не анонсированы, следовательно, у компании еще есть довольно существенные резервы.

Тем не менее в нынешнем году ожидается много интересных новинок от обеих компаний, и не исключено, что расстановка сил изменится. Однако авторитет и имидж лидера не завоевываются за один день, хотя отрицать высокую динамичность этого рыночного сектора также нельзя. Судя по всему, самое интересное нас ждет впереди, а сегмент графических адаптеров в этом году будет во всех отношениях весьма горячим.

| Видеокарта | ATI RADEON X1800 XT 512MB PCI-E | ATI RADEON X1600 XT 256MB PCI-E | NVIDIA GeForce 7800 GTX 512MB | MSI NX6800GS-TD256E |

| Видеопроцессор | Radeon X1800 XT | Radeon X1600 XT | GeForce 7800 GTX 512 | GeForce 6800 GS |

| Техпроцесс, мкм | 0,09 | 0,09 | 0,11 | 0,11 |

| Количество транзисторов, млн | 320 | 157 | 302 | 220 |

| Число пиксельных/вершинных процессоров | 16/8 | 12(4TMU)/6 | 24/8 | 12/5 |

| Разрядность шины памяти, бит | 256 | 128 | 256 | 256 |

| Частоты ядра/памяти, MHz | 625/750 (1500) | 590/690 (1380) | 550/850 (1700) | 425/500 (1000) |

| Видеопамять | 512 MB GDDR3, 1,26 нс | 256 MB GDDR3, 1,26 нс | 512 MB GDDR3, 1,1 нс | 256 MB GDDR3, 2,0 нс |

| Интерфейсы | DVI (2), S-Video | DVI (2), S-Video | DVI (2), S-Video | DVI, D-sub, S-Video |

| Цена, $ | 620 | 196 | 718 | 200 |